Depois que a Meta lançou o Llama 3.1, a Mistral AI lançou seu modelo carro-chefe Mistral Large 2, com um volume de parâmetro de 123 bilhões, uma janela de contexto de surpreendentes 128k e desempenho comparável ao Llama 3.1. O modelo suporta múltiplas linguagens e linguagens de programação, é projetado para inferência de nó único, é eficiente e econômico. Este artigo examinará em profundidade os vários indicadores de desempenho, métodos de uso e seu excelente desempenho em processamento multilíngue, compreensão de código e acompanhamento de instruções do Mistral Large 2, além de analisar seu potencial em aplicações comerciais e campos de pesquisa.

Após o anúncio da Meta ontem sobre o lançamento do modelo de código aberto mais forte, Llama3.1, a Mistral AI lançou grandiosamente seu modelo carro-chefe, Mistral Large2, no início desta manhã. Este novo produto tem 123 bilhões de parâmetros e uma grande janela de contexto de 128k. comparável ao Lhama3.1.

Detalhes do modelo Mistral Large2

Mistral Large2 possui uma janela de contexto de 128k e suporta dezenas de idiomas, incluindo francês, alemão, espanhol, italiano, português, árabe, hindi, russo, chinês, japonês e coreano, bem como Python, Java, C, C++, mais de 80 linguagens de codificação, incluindo JavaScript e Bash.

O Mistral Large2 foi projetado para inferência de nó único, visando aplicações de contexto longo - seu tamanho de parâmetro de 123 bilhões permite que ele seja executado com alto rendimento em um único nó. Mistral Large2 é lançado sob a Licença de Pesquisa Mistral e destina-se à pesquisa e uso não comercial; se houver necessidade comercial, os usuários precisam entrar em contato para obter uma licença comercial;

Desempenho geral:

Em termos de desempenho, Mistral Large2 estabeleceu um novo benchmark em indicadores de avaliação, alcançando especialmente uma precisão de 84,0% no teste de benchmark MMLU, demonstrando um forte equilíbrio entre desempenho e custo do serviço.

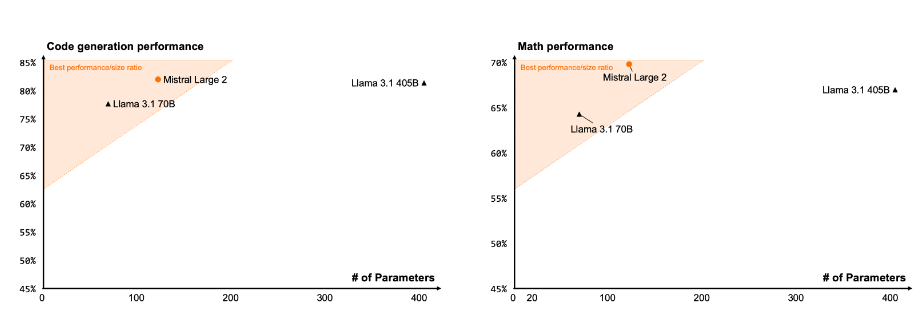

Código e raciocínio

Através da experiência de treinamento do Codestral22B e Codestral Mamba, o Mistral Large2 tem um bom desempenho no processamento de código, mesmo comparável a modelos de ponta como GPT-4o, Claude3Opus e Llama3405B.

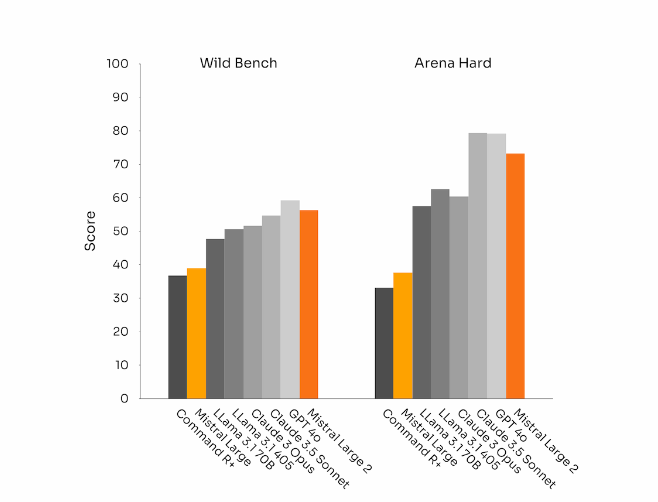

Conformidade e alinhamento das instruções

O Mistral Large 2 também fez progressos significativos nas capacidades de acompanhamento de comando e diálogo, especialmente ao lidar com diálogos complexos e multivoltas com maior flexibilidade. Em alguns benchmarks, gerar respostas mais longas tende a melhorar as pontuações. No entanto, em muitas aplicações comerciais, a simplicidade é crucial – a geração de modelos mais curtos ajuda a interações mais rápidas e torna a inferência mais econômica.

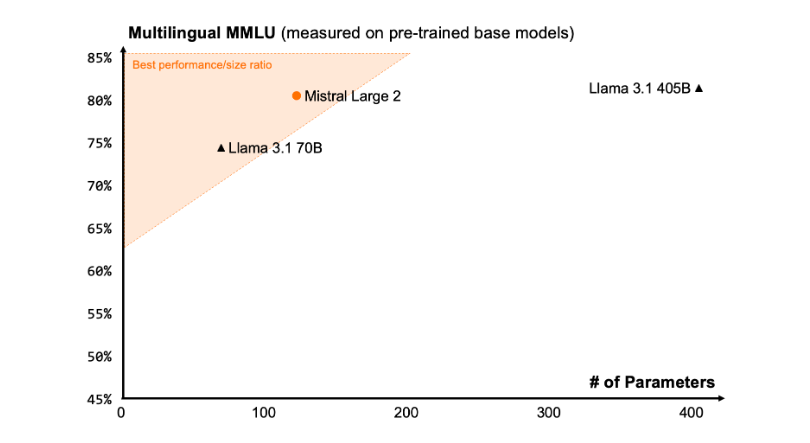

diversidade linguística

O novo Mistral Large2 é treinado em grandes quantidades de dados multilíngues, especificamente em inglês, francês, alemão, espanhol, italiano, português, holandês, russo, chinês, japonês, coreano, árabe e hindi. Excelente desempenho. Abaixo estão os resultados de desempenho do Mistral Large2 no benchmark MMLU multilíngue, em comparação com os modelos anteriores Mistral Large, Llama3.1 e Command R+ da Cohere.

Uso de ferramentas e chamadas de função

O Mistral Large2 vem equipado com habilidades aprimoradas de chamada e recuperação de funções e é treinado para executar habilmente chamadas de funções paralelas e sequenciais, permitindo que ele sirva como uma potência para aplicações de negócios complexas.

Como usar:

Atualmente, os usuários podem usar o Mistral Large2 sob o nome mistral-large-2407 à la Plateforme (https://console.mistral.ai/) e testado no le Chat. Está disponível na versão 24.07 (o sistema de controle de versão YY.MM que aplicamos a todos os modelos) e sob o nome API mistral-large-2407 . Os pesos para o modelo de instrução estão disponíveis e também hospedados no HuggingFace (https://huggingface.co/mistralai/Mistral-Large-Instruct-2407).

Os produtos da La Plateforme incluem dois modelos universais, Mistral Nemo e Mistral Large, e dois modelos profissionais, Codestral e Embed. À medida que eliminamos modelos mais antigos no La Plateforme, todos os modelos Apache (Mistral7B, Mixtral8x7B e 8x22B, Codestral Mamba, Mathstral) ainda podem ser implantados e ajustados usando o SDK mistral-inference e mistral-finetune.

A partir de hoje, o produto expandirá os recursos de ajuste fino à la Plateforme: esses recursos agora estão disponíveis para Mistral Large, Mistral Nemo e Codestral.

A Mistral AI também fez parceria com vários provedores líderes de serviços em nuvem para disponibilizar o Mistral Large2 globalmente, principalmente na Vertex AI no Google Cloud Platform.

** Destaques: **

Mistral Large2 possui janelas de contexto de 128k e suporta até dez linguagens e mais de 80 linguagens de programação.

Atingindo uma precisão de 84,0% no teste de benchmark MMLU, com excelente desempenho e custo.

?Os usuários podem acessar novos modelos através do La Plateforme e são amplamente utilizados em plataformas de serviços em nuvem.

Em suma, o Mistral Large 2 demonstrou forte competitividade no campo dos grandes modelos linguísticos com o seu desempenho poderoso, amplo suporte linguístico e utilização conveniente, proporcionando novas possibilidades para investigação e aplicações comerciais. A sua natureza de código aberto também promove ainda mais o desenvolvimento inovador no domínio da IA.