A equipe do Alibaba Qwen lançou um novo benchmark denominado "PROCESSBENCH", que visa avaliar de forma mais abrangente a capacidade dos modelos de linguagem no raciocínio matemático, com foco particular na capacidade do modelo de identificar erros de processo. Os benchmarks existentes têm limitações, como serem muito simplistas para modelos de alto nível ou fornecerem apenas avaliações de correção binária, sem análise detalhada das etapas de erro. O surgimento do "PROCESSBENCH" preenche esta lacuna e fornece uma nova ferramenta para uma compreensão mais profunda e melhoria do mecanismo de raciocínio dos modelos de linguagem.

Recentemente, pesquisadores da equipe Qwen do Alibaba lançaram um novo benchmark chamado "PROCESSBENCH", que foi projetado para medir a capacidade dos modelos de linguagem de identificar erros de processo no raciocínio matemático. À medida que os modelos de linguagem têm feito progressos significativos em tarefas complexas de raciocínio, os investigadores nesta área descobriram que, apesar do seu excelente desempenho, ainda enfrentam desafios no tratamento de certos problemas difíceis. Portanto, é particularmente importante desenvolver um método de supervisão eficaz.

Os atuais padrões de avaliação para modelos linguísticos apresentam algumas deficiências. Por um lado, alguns conjuntos de problemas tornam-se demasiado simples para modelos avançados e, por outro lado, os métodos de avaliação existentes muitas vezes fornecem apenas avaliações de correcção binária sem anotações detalhadas de erros. Este fenómeno realça a necessidade urgente de quadros de avaliação mais abrangentes para examinar mais profundamente os mecanismos de inferência de modelos linguísticos complexos.

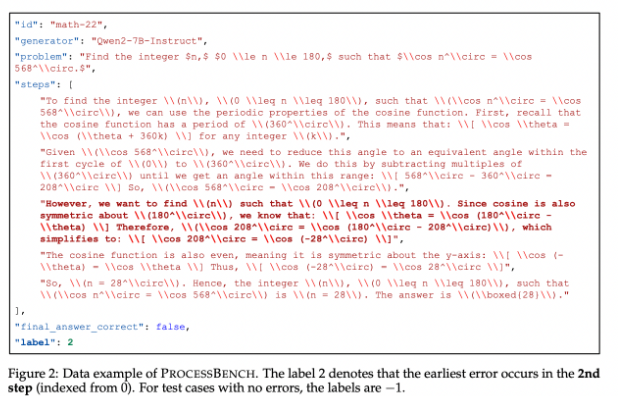

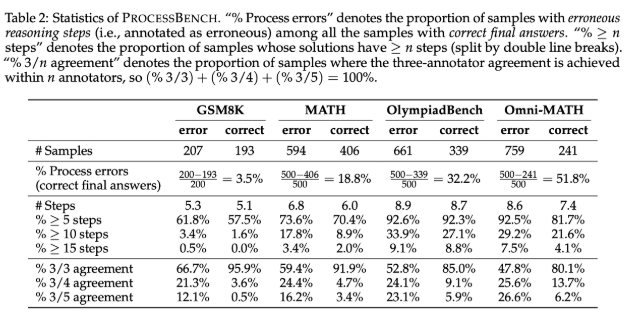

Para preencher esta lacuna, os pesquisadores criaram o “PROCESSBENCH”, um benchmark focado na identificação de etapas falhas no raciocínio matemático. Seus princípios de design incluem dificuldade do problema, diversidade de soluções e avaliação abrangente. O benchmark visa problemas matemáticos de competição e de olimpíada, aproveitando vários modelos de linguagem de código aberto para gerar soluções que demonstrem diferentes abordagens para resolver os problemas. PROCESSBENCH contém um total de 3.400 casos de teste que foram cuidadosamente anotados por vários especialistas humanos para garantir a qualidade dos dados e a confiabilidade da avaliação.

Durante o desenvolvimento, a equipe de pesquisa coletou problemas matemáticos de quatro conjuntos de dados bem conhecidos (GSM8K, MATH, OlympiadBench e Omni-MATH), garantindo que uma ampla gama de dificuldades fosse coberta desde a escola primária até o nível de competição. Eles aproveitaram modelos de código aberto para gerar até 12 soluções diferentes para aumentar a diversidade de soluções. Além disso, para unificar o formato das etapas da solução, a equipe adotou um método de reformatação para garantir um raciocínio passo a passo logicamente completo.

Os resultados da pesquisa mostram que os modelos de recompensa de processo existentes têm um desempenho fraco ao lidar com problemas difíceis, especialmente em conjuntos de problemas mais simples, e o modelo de julgamento orientado por prompt tem um desempenho mais proeminente. A pesquisa revela as limitações dos modelos existentes na avaliação do raciocínio matemático, principalmente quando o modelo atinge a resposta correta por meio de etapas intermediárias erradas, dificultando o julgamento com precisão.

Como referência pioneira para avaliar a capacidade dos modelos de linguagem para identificar erros no raciocínio matemático, o PROCESSBENCH fornece uma estrutura importante para pesquisas futuras e promove a compreensão e melhoria da IA no processo de raciocínio.

Entrada de papel: https://github.com/QwenLM/ProcessBench?tab=readme-ov-file

Código: https://github.com/QwenLM/ProcessBench?tab=readme-ov-file

Em suma, o lançamento do benchmark PROCESSBENCH fornece uma ferramenta mais abrangente e aprofundada para avaliar a capacidade de raciocínio matemático dos modelos de linguagem, ajudando a promover o desenvolvimento da investigação neste campo e, em última análise, melhorando o desempenho dos modelos de linguagem em tarefas de raciocínio complexas.