Nos últimos anos, os grandes modelos de linguagem (LLMs) fizeram progressos significativos no campo do processamento de linguagem natural, mas seus métodos de processamento em nível de token têm limitações na compreensão do contexto e nas aplicações multilíngues e multimodais. A Meta AI propõe um método totalmente novo para este fim - Large Concept Models (LCMs), com o objetivo de resolver as deficiências dos LLMs existentes. Ao modelar no espaço de incorporação de alta dimensão SONAR, os LCMs suportam vários idiomas e modalidades e adotam uma arquitetura hierárquica para melhorar a consistência e as capacidades de edição local de conteúdo longo, melhorando significativamente a eficiência e as capacidades de generalização do modelo.

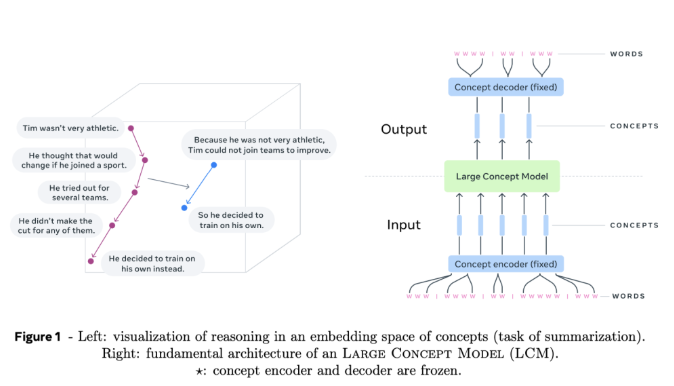

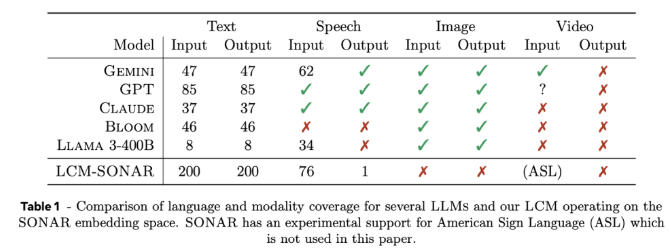

Grandes modelos conceituais (LCMs) representam uma mudança importante em relação à arquitetura LLM tradicional. Eles introduzem duas inovações principais: primeiro, o modelo LCMs em um espaço de incorporação de alta dimensão, em vez de depender de tokens discretos. Este espaço de incorporação, denominado SONAR, foi projetado para suportar mais de 200 idiomas e múltiplas modalidades, incluindo texto e fala, fornecendo capacidades de processamento independentes de idioma e modalidade. Em segundo lugar, o design dos LCMs permite uma transição perfeita no nível semântico, permitindo fortes capacidades de generalização zero-shot em diferentes linguagens e modalidades.

No centro dos LCMs, existem codificadores e decodificadores de conceito, que são componentes que mapeiam sentenças de entrada para o espaço de incorporação do SONAR e decodificam as incorporações de volta para a linguagem natural ou outras modalidades. O design congelado desses componentes garante modularidade, facilitando a extensão de novas linguagens ou modalidades sem retreinar todo o modelo.

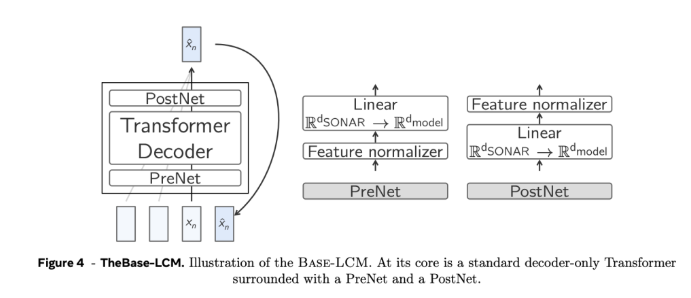

Em termos de detalhes técnicos, os LCMs adotam uma arquitetura hierárquica que imita o processo de raciocínio humano, melhorando assim a consistência do conteúdo de formato longo, ao mesmo tempo que permite a edição local sem perturbar o contexto geral. Os LCMs se destacam no processo de geração, empregando modelos de difusão que prevêem a próxima incorporação do SONAR com base na incorporação anterior. No experimento, foram utilizadas duas arquiteturas, torre única e torre dupla. A arquitetura de torre dupla processou a codificação de contexto e a remoção de ruído separadamente, o que melhorou a eficiência.

Os resultados experimentais mostram que os LCMs de duas torres baseados em difusão demonstram competitividade em múltiplas tarefas. Por exemplo, na tarefa de resumo multilíngue, os LCMs superam os modelos de linha de base no caso zero-shot, demonstrando sua adaptabilidade. Ao mesmo tempo, os LCMs também apresentam alta eficiência e precisão no processamento de sequências mais curtas, o que é confirmado pela melhoria significativa nas métricas relacionadas.

O grande modelo conceitual da Meta AI fornece uma alternativa promissora aos modelos tradicionais de linguagem em nível de token, resolvendo algumas das principais limitações dos métodos existentes por meio da incorporação de conceitos de alta dimensão e processamento independente de modalidade. À medida que a investigação sobre esta arquitetura se aprofunda, espera-se que os LCM redefinam as capacidades dos modelos de linguagem e forneçam uma abordagem mais escalável e adaptável à comunicação orientada pela IA.

Entrada do projeto: https://github.com/facebookresearch/large_concept_model

Em suma, o modelo LCMs proposto pela Meta AI oferece uma solução inovadora para resolver as limitações do LLM tradicional. Suas vantagens em processamento multilíngue e multimodal e design de arquitetura eficiente fazem com que ele tenha um grande futuro no campo da linguagem natural. processamento. Tem um enorme potencial e merece atenção contínua e investigação aprofundada.