O Google lançou oficialmente a TPU de sexta geração, Trillium, e a abriu para clientes do Google Cloud. Trillium é o TPU mais poderoso do Google até o momento e é usado para treinar o Gemini 2.0, seu modelo de IA mais poderoso. Ele melhora significativamente o desempenho do treinamento, o rendimento de inferência e a eficiência energética, ao mesmo tempo que reduz custos. Este artigo analisará em profundidade as melhorias de desempenho, os principais recursos e o excelente desempenho do Trillium TPU em diferentes cargas de trabalho de IA e demonstrará seus casos práticos de aplicação entre clientes como AI21Labs.

No início deste ano, o Google lançou o Trillium, seu TPU de sexta geração e mais poderoso até o momento. Hoje, o Trillium está oficialmente disponível para clientes do Google Cloud.

O Google usou o Trillium TPU para treinar o Gemini2.0 mais recente, que é o modelo de IA mais poderoso do Google até o momento. Agora, tanto as empresas como as startups podem aproveitar a mesma infraestrutura robusta, eficiente e sustentável.

O núcleo do supercomputador AI: Trillium TPU

Trillium TPU é um componente chave do hipercomputador Google Cloud AI. AI Hypercomputer é uma arquitetura de supercomputador inovadora que aproveita hardware com desempenho otimizado, software aberto, estruturas de ML líderes e sistemas flexíveis de integração de modelos de consumo. Com o lançamento oficial do Trillium TPU, o Google também fez melhorias importantes na camada de software aberta do hipercomputador de IA, incluindo a otimização do compilador XLA e estruturas populares como JAX, PyTorch e TensorFlow para alcançar liderança em preço/desempenho em treinamento de IA. , sintonia e serviços .

Além disso, recursos como descarregamento de host usando DRAM de host massivo (memória suplementar de alta largura de banda, ou HBM) fornecem níveis mais altos de eficiência. O AI Hypercomputer permite extrair o máximo valor de uma implantação sem precedentes de mais de 100.000 chips Trillium por arquitetura de rede Jupiter com 13 petabits/segundo de largura de banda bidirecional e a capacidade de dimensionar um único trabalho de treinamento distribuído para centenas de milhares de aceleradores.

Clientes como AI21Labs já estão usando o Trillium para fornecer soluções de IA significativas aos seus clientes com mais rapidez:

Barak Lenz, CTO da AI21Labs, disse: “Na AI21, trabalhamos constantemente para melhorar o desempenho e a eficiência dos modelos de linguagem Mamba e Jamba. Como usuários de longa data do TPU v4, estamos impressionados com os recursos do Trillium do Google Cloud. Em escala, velocidade e custo As melhorias na eficiência são significativas. Acreditamos que o Trillium desempenhará um papel vital na aceleração do desenvolvimento de nossa próxima geração de modelos de linguagem complexos, permitindo-nos fornecer soluções de IA mais poderosas e acessíveis aos nossos clientes.”

O desempenho do Trillium melhorou bastante e muitos indicadores estabeleceram novos recordes.

Comparado com a geração anterior, o Trillium fez melhorias significativas em:

O desempenho do treinamento melhorou em mais de 4 vezes

Melhoria de 3x no rendimento de inferência

A eficiência energética aumentou 67%

Melhoria de 4,7x no desempenho máximo de computação por chip

Memória de alta largura de banda (HBM) dobra capacidade

Interconexão entre chips (ICI) dobra a largura de banda

Uma única arquitetura de rede Júpiter contém 100.000 chips Trillium

Melhoria de 2,5x no desempenho do treinamento por dólar e melhoria de 1,4x no desempenho de inferência por dólar

Essas melhorias permitem que o Trillium tenha um bom desempenho em uma variedade de cargas de trabalho de IA, incluindo:

Dimensionando cargas de trabalho de treinamento de IA

Treinar LLMs, incluindo modelos densos e modelos Mixed Expert (MoE)

Desempenho de inferência e agendamento coletivo

Incorporando modelos densos

Fornecer treinamento e inferência de custo-benefício

Qual é o desempenho do Trillium em diferentes cargas de trabalho?

Dimensionando cargas de trabalho de treinamento de IA

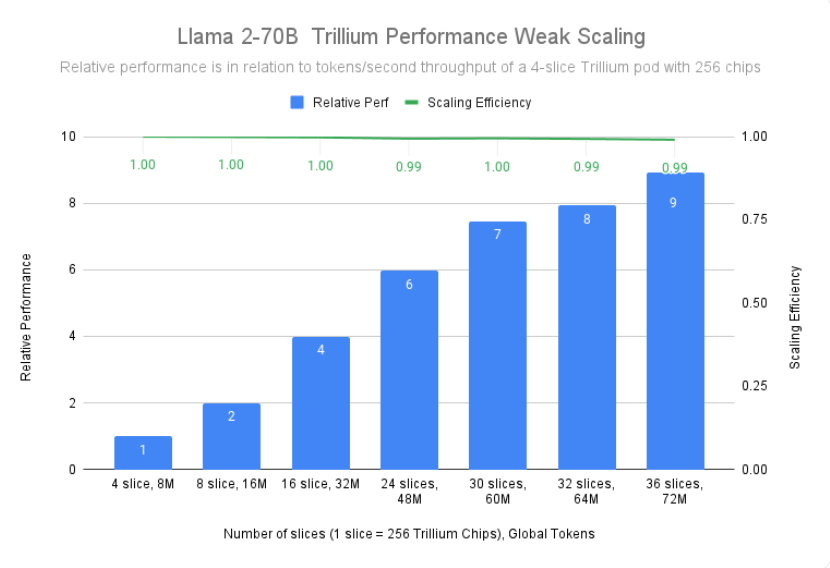

Treinar um modelo grande como o Gemini2.0 requer muitos dados e computação. A escalabilidade quase linear do Trillium permite que esses modelos sejam treinados significativamente mais rápido, distribuindo cargas de trabalho de maneira eficaz e eficiente entre vários hosts Trillium, conectados por meio de interconexões chip a chip de alta velocidade em pods de 256 chips e nosso estado da arte em a rede de data centers Júpiter. Isso é alcançado por meio da tecnologia TPU multi-chip full-stack para treinamento em larga escala e é ainda mais otimizado por meio do Titanium, um sistema dinâmico de descarregamento em nível de data center que varia de adaptadores de host a arquitetura de rede.

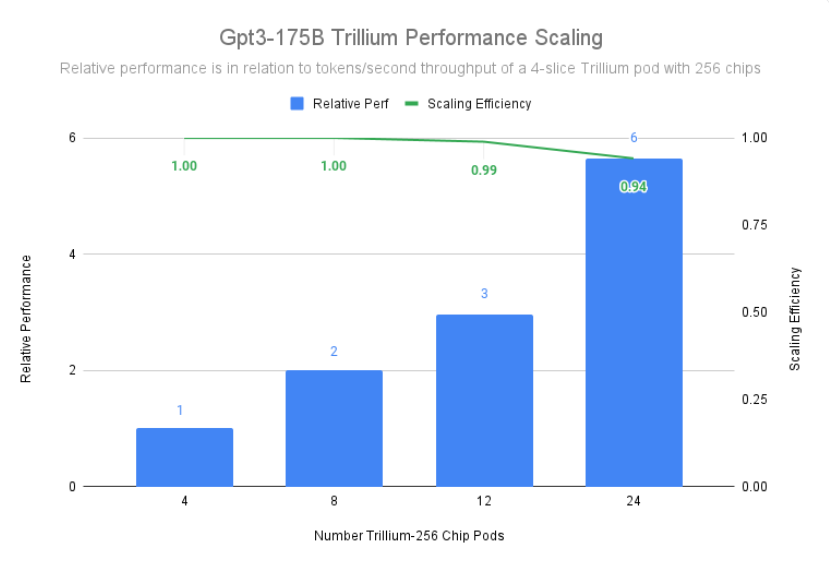

Trillium alcançou 99% de eficiência de escalonamento em uma implantação de 12 pods com 3.072 chips e demonstrou 94% de eficiência de escalonamento em 24 pods com 6.144 chips para pré-treinar gpt3-175b, mesmo em O mesmo acontece quando executado em redes de data center.

Treinar LLMs, incluindo modelos densos e modelos Mixed Expert (MoE)

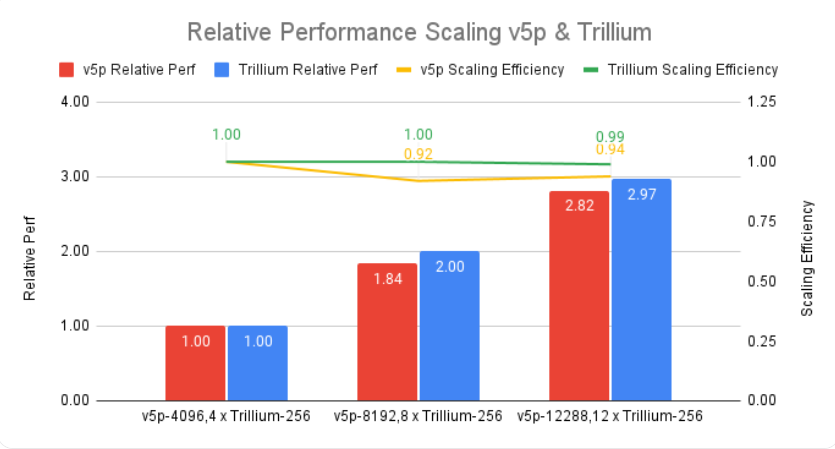

LLMs como o Gemini são inerentemente poderosos e complexos, com bilhões de parâmetros. O treinamento de um LLM tão intensivo requer enorme poder de computação, bem como otimização de software co-projetado. O Trillium é 4 vezes mais rápido que o Cloud TPU v5e da geração anterior ao treinar LLMs intensivos, como Llama-2-70b e gpt3-175b.

Além do LLM intensivo, uma abordagem cada vez mais popular é treinar LLM usando uma arquitetura mista especializada (MoE), que combina múltiplas redes neurais “especializadas”, cada uma especializada em diferentes aspectos da tarefa de IA. Gerenciar e coordenar esses especialistas durante o treinamento adiciona complexidade em comparação ao treinamento de um único modelo monolítico. O Trillium é 3,8 vezes mais rápido que o Cloud TPU v5e da geração anterior ao treinar modelos MoE.

Além disso, o Trillium TPU fornece três vezes mais memória dinâmica de acesso aleatório (DRAM) do host em comparação com o Cloud TPU v5e. Isso transfere parte da computação para o host, ajudando a maximizar o desempenho em larga escala e um bom rendimento. O recurso de descarregamento de host do Trillium fornece mais de 50% de melhoria de desempenho na utilização do modelo FLOP (MFU) ao treinar o modelo Llama-3.1-405B.

Desempenho de inferência e agendamento coletivo

A crescente importância da inferência em várias etapas requer aceleradores que possam lidar com eficiência com o aumento das demandas computacionais. O Trillium oferece avanços significativos para cargas de trabalho de inferência, permitindo uma implantação mais rápida e eficiente de modelos de IA. Na verdade, o Trillium oferece nosso melhor desempenho de inferência de TPU para difusão de imagens e LLM denso. Nossos testes mostram que o Stable Diffusion XL tem uma taxa de transferência relativa de inferência (imagens por segundo) três vezes maior em comparação com o Cloud TPU v5e, enquanto o Llama2-70B tem quase duas vezes.

Trillium é nossa TPU de melhor desempenho para casos de uso offline e de inferência de servidor. A figura abaixo mostra que, em comparação com o Cloud TPU v5e, a taxa de transferência relativa do Stable Diffusion XL (imagens por segundo) para inferência off-line é 3,1 vezes maior, e sua taxa de transferência relativa para inferência do servidor é 2,9 vezes maior.

Além de melhor desempenho, o Trillium também apresenta novos recursos de agendamento coletivo. Esse recurso permite que o sistema de agendamento do Google tome decisões inteligentes de agendamento de trabalhos para melhorar a disponibilidade geral e a eficiência das cargas de trabalho de inferência quando existem várias réplicas na coleção. Ele fornece uma maneira de gerenciar várias fatias de TPU executando cargas de trabalho de inferência de host único ou de vários hosts, inclusive por meio do Google Kubernetes Engine (GKE). O agrupamento dessas peças em uma coleção facilita o ajuste do número de réplicas para atender à demanda.

Incorporando modelos densos

Ao adicionar o SparseCore de terceira geração, o Trillium melhora o desempenho de modelos com uso intensivo de incorporação em 2x e DLRM DCNv2 em 5x.

SparseCore é um processador de fluxo de dados que fornece uma base arquitetônica mais adaptável para cargas de trabalho intensivas incorporadas. O SparseCore de terceira geração do Trillium é excelente na aceleração de operações dinâmicas e relacionadas a dados, como coleta de dispersão, somas de segmentos esparsos e particionamento.

Fornecer treinamento e inferência de custo-benefício

Além do desempenho absoluto e da escala necessária para treinar algumas das maiores cargas de trabalho de IA do mundo, o Trillium foi projetado para otimizar o desempenho por dólar. Até o momento, o Trillium alcançou um desempenho por dólar 2,1x melhor do que o Cloud TPU v5e e 2,5x melhor do que o Cloud TPU v5p ao treinar LLMs intensivos, como Llama2-70b e Llama3.1-405b.

O Trillium se destaca no processamento paralelo de grandes modelos de maneira econômica. Ele foi projetado para permitir que pesquisadores e desenvolvedores forneçam modelos de imagem poderosos e eficientes a um custo muito menor do que antes. O custo de geração de mil imagens no Trillium é 27% menor que o do Cloud TPU v5e para inferência offline e 22% menor que o do Cloud TPU v5e para inferência de servidor no SDXL.

Levando a inovação em IA para o próximo nível

O Trillium representa um grande avanço na infraestrutura de IA do Google Cloud, oferecendo desempenho, escalabilidade e eficiência incríveis para uma variedade de cargas de trabalho de IA. Com sua capacidade de escalar para centenas de milhares de chips usando software de co-design de classe mundial, o Trillium permite que você alcance avanços mais rápidos e forneça soluções de IA superiores. Além disso, o excepcional preço/desempenho do Trillium o torna uma escolha econômica para organizações que buscam maximizar o valor de seus investimentos em IA. À medida que o cenário da IA continua a evoluir, o Trillium demonstra o compromisso do Google Cloud em fornecer infraestrutura de ponta para ajudar as empresas a desbloquear todo o potencial da IA.

Introdução oficial: https://cloud.google.com/blog/products/compute/trillium-tpu-is-ga

Em suma, o surgimento do Trillium TPU marca uma melhoria significativa nas capacidades de computação de IA em nuvem. Seu poderoso desempenho, escalabilidade e benefícios econômicos promoverão um desenvolvimento mais rápido no campo de IA e fornecerão soluções de IA mais poderosas para empresas e instituições de pesquisa.