OpenAI anunciou que o modo de voz avançado do ChatGPT foi visualizado. Os usuários que assinam Plus, Team ou Pro podem interagir com o ChatGPT em tempo real através das câmeras de seus celulares e ter recursos de compartilhamento de tela. Este recurso foi adiado muitas vezes e finalmente foi lançado oficialmente após um longo período de testes. No entanto, nem todos os usuários poderão usá-lo imediatamente. Algumas regiões e tipos de usuários terão que esperar até janeiro do próximo ano ou até mais.

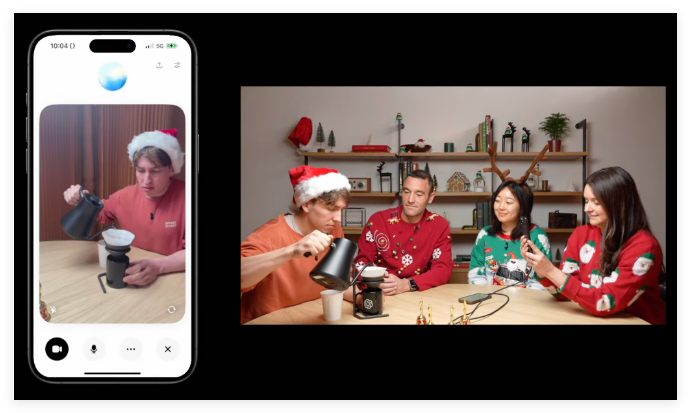

A OpenAI anunciou na quinta-feira que o recurso de conversa semelhante ao humano “Modo de fala avançado” desenvolvido para ChatGPT foi visualizado. Os usuários que assinam ChatGPT Plus, Team ou Pro agora podem apontar a câmera do telefone para um objeto e o ChatGPT responderá quase em tempo real.

Este modo de voz avançado com recursos de visão também possui recursos de compartilhamento de tela que analisam o conteúdo na tela do dispositivo. Por exemplo, pode explicar vários menus de configurações e fornecer conselhos sobre problemas matemáticos.

O método de uso é muito simples: clique no ícone de voz próximo à barra de bate-papo do ChatGPT e, a seguir, clique no ícone de vídeo no canto inferior esquerdo para iniciar o vídeo. Se quiser compartilhar sua tela, você pode clicar no menu de três pontos e selecionar “Compartilhar tela”.

Em relação ao lançamento do recurso, a OpenAI disse que o modo avançado de fala com visão será lançado a partir desta quinta-feira e terminará na próxima semana. É importante observar que isso não estará disponível para todos os usuários imediatamente. Os usuários do ChatGPT Enterprise e Edu terão que esperar até janeiro do próximo ano, enquanto os usuários da UE, Suíça, Islândia, Noruega e Liechtenstein ainda não anunciaram um cronograma específico.

Durante uma recente aparição no programa “60 Minutes” da CNN, o presidente da OpenAI, Greg Brockman, demonstrou recursos avançados de análise visual para padrões de fala para Anderson Cooper. Quando Cooper desenhou partes do corpo humano no quadro negro, o ChatGPT conseguiu entender e comentar seus desenhos. Por exemplo, afirma que o cérebro está posicionado com precisão e sugere que a forma do cérebro está mais próxima de uma elipse.

Porém, durante a demonstração, este modo de fala avançado também revelou algumas imprecisões em relação a questões geométricas, mostrando o risco potencial de “alucinações”.

Vale ressaltar que este modo de voz avançado com recursos visuais foi adiado várias vezes. Em abril, a OpenAI prometeu que seria lançada “dentro de semanas”, mas depois disse que precisaria de mais tempo. Este recurso não estava disponível para alguns usuários do ChatGPT até o início deste outono, e a função de análise visual ainda não estava disponível naquele momento.

No meio da crescente concorrência no domínio da inteligência artificial, rivais como a Google e a Meta também estão a desenvolver capacidades semelhantes. Esta semana, o Google abriu seu projeto de inteligência artificial conversacional de análise de vídeo em tempo real, Projeto Astra, para alguns testadores de Android.

Além dos recursos visuais, a OpenAI também lançou um festivo “Modo Papai Noel” na quinta-feira, permitindo aos usuários ativar a voz do Papai Noel por meio do ícone de floco de neve próximo à barra de notificação no aplicativo ChatGPT.

Esta atualização visual do modo de voz avançado do ChatGPT marca uma melhoria na capacidade da IA de interagir com o mundo real, mas também expõe desafios e limitações no desenvolvimento tecnológico. No futuro, vale a pena esperar pelo aprimoramento e popularização de funções semelhantes. O avanço da tecnologia de IA continuará a afetar nosso estilo de vida.