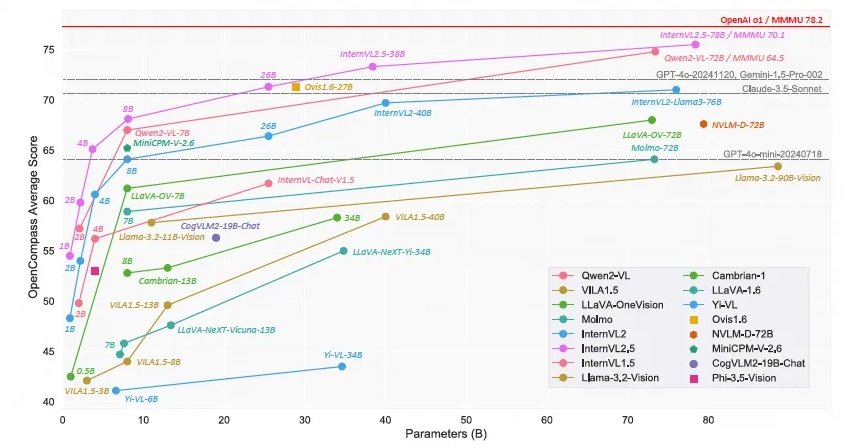

O Shanghai AI Laboratory lançou o modelo de linguagem multimodal em grande escala de código aberto - Scholar·Wanxiang InternVL2.5. Seu desempenho atingiu uma precisão de mais de 70% no benchmark de compreensão multimodal (MMMU), que é comparável ao. GPT-4o e Claude- Modelos comerciais como o 3.5-Sonnet têm desempenho comparável. O modelo InternVL2.5 usa tecnologia de raciocínio de pensamento em cadeia para demonstrar forte desempenho em vários testes de benchmark, especialmente em raciocínio multidisciplinar, compreensão de documentos e detecção de alucinações multimodais. A natureza de código aberto deste modelo promoverá enormemente o desenvolvimento e a inovação da tecnologia de IA multimodal.

Recentemente, o Shanghai AI Laboratory anunciou o lançamento do modelo Scholar·Wanxiang InternVL2.5. Com seu excelente desempenho, este modelo de linguagem multimodal de código aberto em grande escala tornou-se o primeiro modelo de código aberto a exceder 70% de precisão no Multi-modal Understanding Benchmark (MMMU), competindo com modelos comerciais como GPT-4o e Claude. -3.5-Soneto Desempenho comparável.

O modelo InternVL2.5 obteve uma melhoria de 3,7 pontos percentuais através da tecnologia de raciocínio Chain of Thinking (CoT), demonstrando um forte potencial de escalabilidade no tempo de teste. O modelo é desenvolvido com base no InternVL2.0, melhorando ainda mais o desempenho, aprimorando as estratégias de treinamento e teste e melhorando a qualidade dos dados. Pesquisas aprofundadas são conduzidas em codificadores visuais, modelos de linguagem, tamanhos de conjuntos de dados e configurações de tempo de teste para explorar a relação entre tamanho do modelo e desempenho.

InternVL2.5 demonstra desempenho competitivo em vários benchmarks, especialmente em raciocínio multidisciplinar, compreensão de documentos, compreensão de múltiplas imagens/vídeo, compreensão do mundo real, detecção de alucinações multimodais, fundamentação visual, recursos multilíngues e processamento de linguagem pura e outros campos. Esta conquista não só proporciona à comunidade de código aberto um novo padrão para o desenvolvimento e aplicação de sistemas de IA multimodais, mas também abre novas possibilidades para investigação e aplicações no domínio da inteligência artificial.

InternVL2.5 mantém a mesma arquitetura de modelo de seus antecessores InternVL1.5 e InternVL2.0, segue o paradigma "ViT-MLP-LLM" e implementa a integração do novo InternViT-6B pré-treinado incremental ou InternViT-300M com vários LLMs pré-treinados de diferentes tamanhos e tipos são integrados usando projetores MLP de duas camadas inicializados aleatoriamente. Para melhorar a escalabilidade do processamento de alta resolução, a equipe de pesquisa aplicou uma operação de embaralhamento de pixels para reduzir o número de tokens visuais para metade do número original.

A natureza de código aberto do modelo significa que pesquisadores e desenvolvedores podem acessar e usar livremente o InternVL2.5, o que promoverá enormemente o desenvolvimento e a inovação da tecnologia de IA multimodal.

Link do modelo:

https://www.modelscope.cn/collections/InternVL-25-fbde6e47302942

A versão de código aberto do InternVL2.5 fornece recursos valiosos para pesquisas de IA multimodais. Espera-se que seu excelente desempenho e escalabilidade promovam novos avanços neste campo e promovam o nascimento de aplicações mais inovadoras. Ansioso para ver resultados mais surpreendentes baseados no InternVL2.5 no futuro.