O mais recente modelo de linguagem visual aberta da NVIDIA, NVILA, alcançou avanços significativos em precisão e eficiência, tornando-se outro marco no campo da IA visual. Comparado com outros modelos de visão em larga escala, o NVILA obteve reduções significativas nos custos de treinamento, no uso de memória e na latência. Também demonstrou excelente desempenho em vários testes de benchmark, superando até mesmo alguns concorrentes. O artigo apresenta detalhadamente os detalhes técnicos do NVILA, incluindo a tecnologia "expansão primeiro e compressão depois", bem como expansão dinâmica S2, poda de conjunto de dados baseada em DeltaLoss e outras estratégias de otimização, visando equilibrar a precisão e a eficiência do modelo. Isto marca o desenvolvimento da tecnologia de modelos de linguagem visual em uma direção mais econômica e eficiente.

Recentemente, a NVIDIA lançou uma nova geração de modelo de linguagem visual aberta – NVILA. Projetado para otimizar a precisão e a eficiência, tornou-se líder no campo da IA visual com seu excelente desempenho.

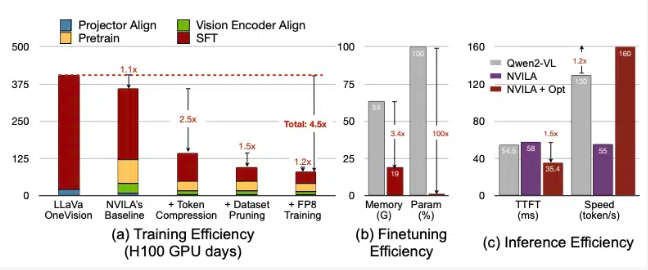

De acordo com a NVIDIA, o NVILA reduz os custos de treinamento em 4,5 vezes, reduz a memória necessária para ajuste fino em 3,4 vezes e reduz as latências de pré-preenchimento e decodificação em quase 2 vezes. Esses dados são comparados com outro modelo de visão de grande porte, o LLaVa OneVision.

Em benchmarks de vídeo, o NVILA superou o GPT4o Mini e também teve um bom desempenho em comparações com GPT4o, Sonnet3.5 e Gemini1.5Pro. Além disso, o NVILA também conseguiu uma ligeira vitória na comparação com o Llama3.2. Apesar disso, a NVIDIA afirmou que o modelo ainda não foi lançado para a plataforma Hugging Face, e prometeu lançar o código e o modelo em breve para promover a reprodutibilidade do modelo.

A NVIDIA apontou que o custo de treinamento de modelos de linguagem visual é muito alto. São necessários aproximadamente 400 dias de GPU para treinar um modelo de linguagem visual de 7B parâmetros. Ao mesmo tempo, o ajuste fino de tal modelo também consome muita memória, com um modelo de parâmetros de 7B exigindo mais de 64 GB de memória GPU.

Portanto, a NVIDIA usa uma técnica chamada expandir e compactar para equilibrar a precisão e a eficiência do modelo. Em vez de reduzir o tamanho das fotos e vídeos, o modelo utiliza vários frames de imagens e vídeos de alta resolução para garantir que nenhum detalhe seja perdido.

Durante o processo de compactação, o modelo reduz o tamanho dos dados de entrada, compactando informações visuais em menos tokens e agrupando pixels para reter informações importantes. A NVIDIA mencionou no artigo que duplicar a resolução duplicará o número de tokens visuais, o que aumentará os custos de treinamento e inferência em mais de 2 vezes. Portanto, eles reduzem esse custo comprimindo tokens de espaço/tempo.

A NVIDIA também mostrou demonstrações de alguns modelos, e o NVILA pode responder a múltiplas consultas com base em uma imagem ou vídeo. Seus resultados de saída também são comparados com o modelo VILA1.5 lançado anteriormente pela NVIDIA. Além disso, a NVIDIA também introduziu algumas outras tecnologias em detalhes, como expansão dinâmica S2, poda de conjunto de dados baseada em DeltaLoss, quantização usando precisão FP8, etc.

Essas técnicas são aplicadas a um modelo de parâmetros 8B, e os detalhes específicos podem ser visualizados no Arxiv.

Entrada de papel: https://arxiv.org/pdf/2412.04468

Destaque:

? O modelo NVILA reduz os custos de treinamento em 4,5 vezes, melhorando a eficiência da IA visual.

? Com imagens e quadros de vídeo de alta resolução, o NVILA garante a integridade das informações de entrada.

?NVIDIA promete lançar códigos e modelos em breve para promover a reprodutibilidade da pesquisa.

Em suma, o surgimento do NVILA trouxe novas possibilidades para o desenvolvimento de modelos de linguagem visual. O seu processo eficiente de formação e inferência reduzirá o limiar para aplicações de IA visual e promoverá um maior desenvolvimento neste campo. Estamos ansiosos pela divulgação antecipada de códigos e modelos pela NVIDIA para que mais pesquisadores possam participar e promover conjuntamente o progresso da tecnologia de IA visual.