A Epoch AI lançou recentemente um simulador de poder de computação para treinamento de modelo de linguagem em grande escala. O simulador fornece referência valiosa para pesquisadores, simulando o custo e a eficiência do treinamento do GPT-4 sob diferentes condições de hardware. Os resultados da simulação mostram que mesmo usando uma placa gráfica antiga GTX580 de 2012 pode treinar GPT-4, mas o custo será dez vezes maior que o do hardware moderno, o que destaca a importância da melhoria do desempenho do hardware para o treinamento do modelo de IA. O simulador também suporta simulação de treinamento em vários data centers, permitindo aos usuários personalizar parâmetros e analisar as diferenças de desempenho de diferentes estratégias de hardware e treinamento, fornecendo uma importante base de tomada de decisão para o treinamento de futuros modelos de IA em grande escala.

Recentemente, a empresa de pesquisa de inteligência artificial Epoch AI lançou um simulador interativo projetado especificamente para simular o poder de computação necessário para treinar grandes modelos de linguagem. Usando este simulador, os pesquisadores descobriram que embora fosse possível treinar o GPT-4 usando placas gráficas mais antigas de 2012, como a GTX580, o custo seria dez vezes maior do que o hardware moderno de hoje.

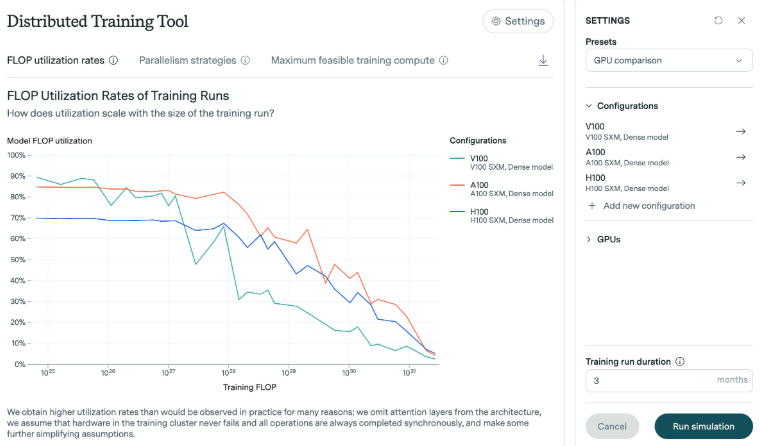

A pesquisa da Epoch AI mostra que o número de operações de ponto flutuante (FLOPs) necessárias para treinar o GPT-4 está entre 1e25 e 1e26. Para este estudo, o simulador analisou a eficiência de diferentes placas gráficas, especialmente à medida que o modelo aumenta. Os resultados mostram que à medida que o modelo cresce, a eficiência geralmente diminui. Tomemos como exemplo a placa gráfica H100 lançada nos últimos anos. Ela pode manter alta eficiência por um longo tempo, enquanto a eficiência da placa gráfica V100 cai mais obviamente ao enfrentar escalas de treinamento maiores.

Nos experimentos da Epoch AI, a memória da placa gráfica GTX580 era de apenas 3 GB. Esta placa gráfica foi a escolha principal ao treinar o modelo AlexNet em 2012. Embora a tecnologia tenha avançado, os investigadores acreditam que a formação em tão grande escala é possível utilizando hardware mais antigo, mas os recursos e custos necessários seriam proibitivos.

Além disso, o simulador oferece suporte a simulações de treinamento complexas em vários data centers. Os usuários podem personalizar parâmetros como tamanho do data center, latência e largura de banda de conexão para simular execuções de treinamento em vários locais. Esta ferramenta também permite analisar diferenças de desempenho entre placas gráficas modernas (como H100 e A100), estudar os efeitos de diferentes tamanhos de lote e treinamento multi-GPU e gerar arquivos de log detalhados que documentam a saída do modelo.

A Epoch AI disse que desenvolveu o simulador para aprofundar sua compreensão das melhorias de eficiência de hardware e avaliar o impacto dos controles de exportação de chips. Com o aumento esperado de missões de treino em grande escala durante este século, é especialmente importante compreender os requisitos de hardware necessários no futuro.

Em suma, esta pesquisa e simulador de Epoch AI fornece um valor de referência importante para o treinamento de grandes modelos de linguagem, ajudando os pesquisadores a compreender melhor a eficiência do hardware, otimizar estratégias de treinamento e fornecer treinamento mais confiável para futuros modelos de IA.