Os grandes modelos de linguagem (LLMs) alcançaram grande sucesso no campo do processamento de linguagem natural, mas seu processamento baseado em tokens limita seu desempenho na compreensão de textos longos e em aplicações multilíngues e multimodais. O Large Concept Model (LCM) proposto pela Meta AI fornece uma solução totalmente nova que opera unidades semânticas abstratas - conceitos em um espaço de incorporação de alta dimensão, superando assim as limitações do LLM. A inovação do LCM reside na sua abordagem de modelagem independente de linguagem e modalidade, bem como na sua arquitetura hierárquica e mecanismo de geração baseado em difusão. Isso permite que o LCM obtenha modelagem de linguagem eficiente e escalável com fortes recursos de generalização zero-shot.

Os grandes modelos de linguagem (LLMs) fizeram progressos significativos no campo do processamento de linguagem natural (PNL), tornando-os populares em aplicações como geração de texto, resumo e resposta a perguntas. No entanto, a dependência do LLM no processamento em nível de token (previsão de uma palavra por vez) também apresenta alguns desafios. Esta abordagem contrasta com a forma como os humanos comunicam, que normalmente opera num nível mais elevado de abstração, como frases ou ideias.

A modelagem em nível de token também é insuficiente em tarefas que exigem compreensão de contexto longo e podem produzir resultados inconsistentes. Além disso, estender esses modelos para aplicações multilíngues e multimodais é computacionalmente caro e exige muitos dados. Para resolver esses problemas, os pesquisadores da Meta AI propuseram um novo método: Large Conceptual Model (LCM).

Grandes modelos conceituais: um novo paradigma para a compreensão semântica

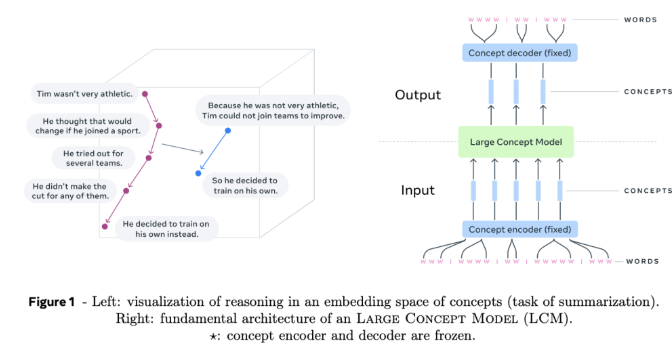

O grande modelo conceitual (LCM) da Meta AI representa uma mudança em relação à arquitetura LLM tradicional. LCM apresenta duas inovações principais:

Modelagem de espaço de incorporação de alta dimensão: o LCM não opera mais em tokens discretos, mas realiza cálculos em um espaço de incorporação de alta dimensão. Este espaço representa unidades abstratas de significado, chamadas conceitos, correspondentes a sentenças ou enunciados. Este espaço de incorporação, denominado SONAR, foi projetado para ser independente de idioma e modalidade, suportando mais de 200 idiomas e múltiplas modalidades, incluindo texto e fala.

Modelagem independente de linguagem e modalidade: Ao contrário dos modelos vinculados a uma linguagem ou modalidade específica, o LCM processa e gera conteúdo em um nível puramente semântico. Este design permite a alternância perfeita entre idiomas e modalidades, resultando em uma forte generalização zero-shot.

No centro do LCM estão codificadores e decodificadores de conceito que mapeiam sentenças de entrada para o espaço de incorporação do SONAR e decodificam as incorporações de volta para a linguagem natural ou outras modalidades. Esses componentes são congelados, garantindo modularidade e fácil expansão para novas linguagens ou modalidades sem retreinar todo o modelo.

Detalhes técnicos e vantagens do LCM

O LCM apresenta diversas inovações para avançar na modelagem de linguagem:

Arquitetura em camadas: o LCM adota uma estrutura em camadas que reflete o processo de raciocínio humano. Este design melhora a coerência do conteúdo de formato longo e permite a edição local sem destruir o contexto mais amplo.

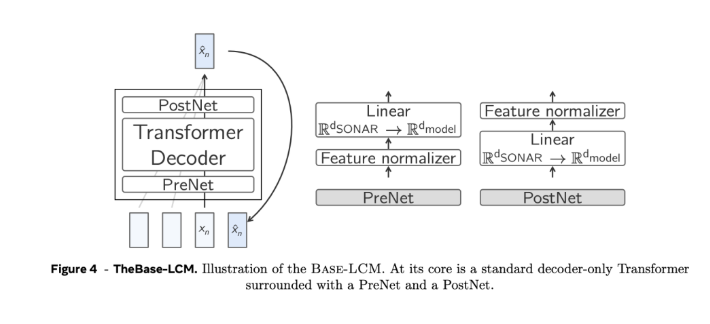

Geração baseada em difusão: O modelo de difusão é considerado o projeto mais eficiente de LCM. Esses modelos prevêem a próxima incorporação do SONAR com base na incorporação anterior. Duas arquiteturas foram exploradas:

Torre única: um único decodificador Transformer lida com codificação de contexto e eliminação de ruído.

Torres Gêmeas: Codificação e eliminação de ruído de contexto separadas, fornecendo componentes dedicados para cada tarefa.

Escalabilidade e eficiência: Em comparação com o processamento em nível de token, a modelagem em nível de conceito reduz o comprimento das sequências, resolve a complexidade quadrática dos Transformers padrão e pode lidar com contextos longos com mais eficiência.

Generalização zero-shot: O LCM exibe fortes capacidades de generalização zero-shot em idiomas e modalidades invisíveis, aproveitando o amplo suporte multilíngue e multimodalidade do SONAR.

Critérios de busca e parada: Algoritmo de busca com critérios de parada baseados na distância do conceito de “fim do documento”, garantindo geração coerente e completa sem necessidade de ajustes finos.

Em suma, o grande modelo conceitual (LCM) da Meta AI traz novas ideias para o campo do processamento de linguagem natural. Suas vantagens no processamento de texto longo, dados multilíngues e multimodais indicam uma direção importante para o desenvolvimento futuro de modelos de linguagem. . O surgimento do LCM aumentará significativamente as capacidades da inteligência artificial no processamento de informações entre idiomas e entre modais e expandirá suas aplicações em mais campos.