Answer.AI e LightOn lançaram em conjunto o modelo de linguagem de código aberto ModernBERT, que é uma grande melhoria em relação ao Google BERT e melhorou significativamente a velocidade, eficiência e qualidade. O ModernBERT processa quatro vezes mais rápido que o BERT, usa menos memória e pode lidar com texto de até 8.192 tokens, o que é 16 vezes mais rápido que os modelos existentes. Ele também fez um progresso revolucionário na codificação de código de programação pela primeira vez, marcando mais de 80 no conjunto de dados StackOverflow Q&A, estabelecendo um novo recorde. Mais importante ainda, o ModernBERT reduz significativamente o custo do processamento de texto em grande escala e pode ser executado em hardware comum de consumo, tornando-o mais econômico do que modelos como o GPT-4.

O design do ModernBERT permite processar texto de até 8.192 tokens, o que é uma melhoria de 16x em relação ao limite típico de 512 tokens dos modelos de codificação existentes. Além disso, ModernBERT é o primeiro modelo de codificação de código de programação extensivamente treinado, alcançando uma pontuação de mais de 80 no conjunto de dados StackOverflow Q&A, estabelecendo um novo recorde para modelos de codificação.

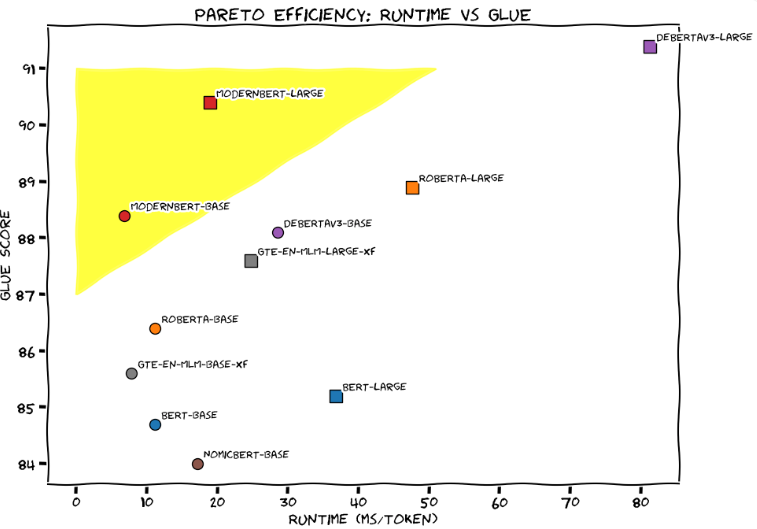

Na Avaliação de Compreensão Geral da Linguagem (GLUE), ModernBERT-Large alcançou o melhor equilíbrio entre velocidade e precisão de processamento, com um tempo de processamento de aproximadamente 20 milissegundos por token e uma pontuação de 90. A equipe de desenvolvimento comparou vividamente o ModernBERT a um Honda Civic ajustado, enfatizando que ele é confiável e eficiente em aplicações diárias.

Comparado com modelos de linguagem de grande escala existentes, como o GPT-4, o ModernBERT reduz significativamente o custo do processamento de texto em grande escala. O GPT-4 custa centavos por consulta, enquanto o ModernBERT é executado localmente e é mais rápido e barato. Por exemplo, quando o projeto FineWeb Edu filtrou 15 bilhões de tags, o custo de usar o modelo BERT foi de US$ 60 mil, e mesmo usando o decodificador Gemini Flash do Google, o custo foi de mais de US$ 1 milhão.

A equipe de desenvolvimento afirma que o ModernBERT é adequado para uma variedade de aplicações práticas, incluindo sistemas de geração aumentada de recuperação (RAG), pesquisa de código e revisão de conteúdo. Ao contrário do GPT-4, que requer hardware especializado, o ModernBERT pode funcionar de forma eficaz em GPUs de jogos comuns.

Atualmente, o ModernBERT está disponível em duas versões: o modelo básico contém 139 milhões de parâmetros e a versão grande contém 395 milhões de parâmetros. Ambas as versões foram lançadas no Hugging Face e os usuários podem substituir diretamente os modelos BERT existentes por elas. A equipe de desenvolvimento planeja lançar uma versão maior no próximo ano, mas não há planos para capacidades multimodais. Para promover o desenvolvimento de novos aplicativos, eles também estão lançando um concurso que premiará US$ 100 e uma assinatura profissional Hugging Face de seis meses para os cinco melhores apresentadores.

Desde que o Google lançou o BERT em 2018, o modelo tem sido um dos modelos de linguagem mais populares, com mais de 68 milhões de downloads mensais no HuggingFace.

Entrada do projeto: https://huggingface.co/blog/modernbert

Destaques:

ModernBERT é quatro vezes mais rápido que BERT e pode lidar com textos de até 8.192 tokens.

Comparado com o GPT-4, o custo do ModernBERT no processamento de texto em grande escala é significativamente reduzido e sua operação é mais eficiente.

Este modelo é particularmente bom no processamento de código de programação, pontuando mais de 80 no conjunto de dados StackOverflow Q&A, estabelecendo um novo recorde.

Em suma, o lançamento de código aberto do ModernBERT oferece aos desenvolvedores uma escolha de modelo de linguagem eficiente, econômica e poderosa. Possui vantagens significativas em velocidade, eficiência e capacidade de processar textos longos, e espera-se que promova o desenvolvimento inovador de mais aplicações de IA. . Ansioso por suas atualizações futuras e aplicações mais amplas.