O Zhiyuan Research Institute e a Tencent lançaram em conjunto o LongBench v2, uma plataforma de teste de benchmark para avaliar as capacidades de compreensão e raciocínio de textos longos de grandes modelos de linguagem (LLMs). O LongBench v2 melhora significativamente o comprimento do texto e a dificuldade da avaliação, incluindo 503 questões desafiadoras de quatro opções e múltipla escolha, o que torna difícil até mesmo para especialistas humanos obter alta precisão em um curto espaço de tempo. O benchmark abrange seis categorias principais de tarefas e inclui melhorias na metodologia de avaliação para aumentar a confiabilidade e a precisão dos resultados. Esta medida visa promover o progresso de grandes modelos de linguagem no processamento de textos longos e fornecer uma ferramenta de avaliação mais eficaz para pesquisas relacionadas.

Em uma conferência de imprensa em 19 de dezembro de 2024, o Zhiyuan Research Institute e a Tencent anunciaram o lançamento do LongBench v2, que foi projetado para avaliar as capacidades profundas de compreensão e raciocínio de grandes modelos de linguagem (LLMs) em multitarefas de texto longo do mundo real. Benchmarks projetados. A plataforma visa promover o progresso dos modelos de texto longo na compreensão e no raciocínio, e responde aos desafios atuais na aplicação de modelos de texto longo e de linguagem extensa.

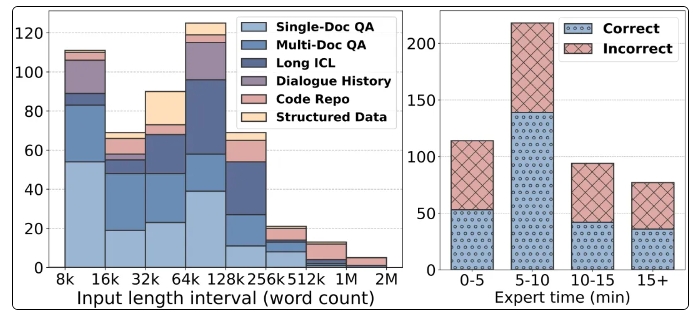

Os recursos notáveis do LongBench v2 incluem suporte para comprimentos de texto mais longos, variando de 8 mil a 2 milhões de palavras, e contém 503 questões desafiadoras de quatro opções e múltipla escolha com maior dificuldade, até mesmo a precisão média de especialistas humanos em 15 minutos A taxa é de apenas 53,7% . Além disso, o benchmark abrange seis categorias principais de tarefas, incluindo perguntas e respostas de documento único, perguntas e respostas de vários documentos, aprendizagem de contexto de texto longo, etc., garantindo uma ampla gama de cenários de aplicação.

Para garantir a confiabilidade da avaliação, todas as questões do LongBench v2 estão na forma de questões de múltipla escolha e passam por um rigoroso processo manual de anotação e revisão. Durante o processo de coleta de dados, foram recrutados anotadores das melhores universidades para garantir a qualidade e a dificuldade das questões. Ao introduzir variáveis de controle, o LongBench v2 melhora o algoritmo estatístico Bradley-Terry original, reduzindo o impacto de fatores de confusão e tornando a classificação do modelo mais científica e precisa.

Em termos de resultados de avaliação, a equipe de pesquisa testou 10 LLMs de código aberto e 6 LLMs de código fechado e descobriu que o desempenho do modelo melhorou significativamente após a introdução de variáveis de controle. Em particular, o modelo GPT-4o tem um bom desempenho em tarefas como resposta a perguntas com vários documentos e aprendizagem de contexto de texto longo após a introdução de mais etapas de raciocínio, mostrando a importância das capacidades de raciocínio.

O lançamento do LongBench v2 não só fornece uma nova ferramenta para a avaliação de grandes modelos de linguagem, mas também aponta a direção para pesquisas futuras, enfatizando a importância de melhorar as capacidades de compreensão e raciocínio do próprio modelo. A cooperação entre o Instituto de Pesquisa Zhiyuan e a Tencent marca um maior desenvolvimento no campo da tecnologia de IA. Espera-se que este teste de referência possa promover o avanço da tecnologia de compreensão e raciocínio de textos longos.

Página inicial: https://longbench2.github.io

Artigo: https://arxiv.org/abs/2412.15204

Dados e código: https://github.com/THUDM/LongBench

O lançamento do LongBench v2 marca uma nova etapa na avaliação de modelos de linguagem de grande porte. Seus padrões de avaliação mais rigorosos e conteúdo de teste mais abrangente ajudarão a promover a melhoria contínua de modelos de linguagem de grande porte em termos de compreensão e raciocínio de textos longos. Esperamos que mais resultados de pesquisas baseados no LongBench v2 apareçam no futuro para promover ainda mais o desenvolvimento da tecnologia de IA.