A NVIDIA lançou rapidamente as GPUs GB300 e B300, alcançando melhorias significativas de desempenho apenas meio ano após o lançamento das GPUs GB200 e B200, especialmente em modelos de inferência. Esta não é apenas uma simples atualização de hardware, mas também representa um ajuste estratégico de layout da NVIDIA no campo da aceleração de IA, que terá um impacto profundo na indústria. O núcleo desta atualização está em um grande salto no desempenho de inferência, bem como na otimização de memória e arquitetura, o que afetará diretamente a eficiência e o custo de grandes modelos de linguagem.

Apenas 6 meses após o lançamento do GB200 e B200, a Nvidia lançou mais uma vez as novas GPUs-GB300 e B300. Isto pode parecer uma pequena atualização, mas na verdade contém grandes mudanças, especialmente a melhoria significativa no desempenho do modelo de inferência, que terá um impacto profundo em toda a indústria.

B300/GB300: Um grande salto no desempenho de inferência

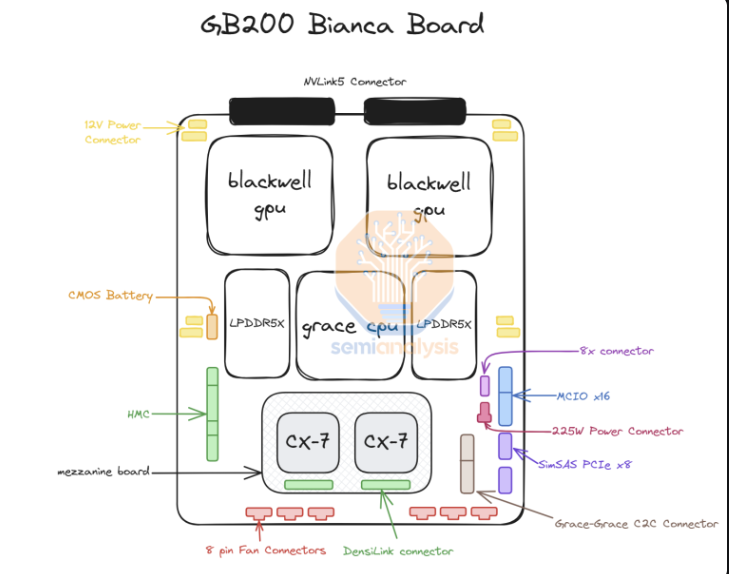

B300GPU usa o nó de processo 4NP da TSMC e é otimizado para chips de computação. Isto faz com que o desempenho de FLOPS do B300 seja 50% superior ao do B200. Parte da melhoria de desempenho vem do aumento no TDP. O TDP do GB300 e B300HGX atinge 1,4KW e 1,2KW respectivamente (GB200 e B200 são 1,2KW e 1KW respectivamente). Os ganhos restantes de desempenho vêm de melhorias arquitetônicas e otimizações no nível do sistema, como a alocação dinâmica de energia entre a CPU e a GPU.

Além do aumento de FLOPS, a memória também foi atualizada para 12-Hi HBM3E, e a capacidade HBM de cada GPU foi aumentada para 288GB. No entanto, a velocidade do pino permanece inalterada, portanto a largura de banda da memória por GPU ainda é de 8 TB/s. Vale a pena notar que a Samsung não conseguiu entrar na cadeia de fornecimento de GB200 ou GB300.

Além disso, a Nvidia também fez ajustes nos preços. Isto afetará a margem de lucro dos produtos Blackwell até certo ponto, mas o mais importante é que a melhoria do desempenho do B300/GB300 será refletida principalmente no modelo de inferência.

Adaptado para modelos de inferência

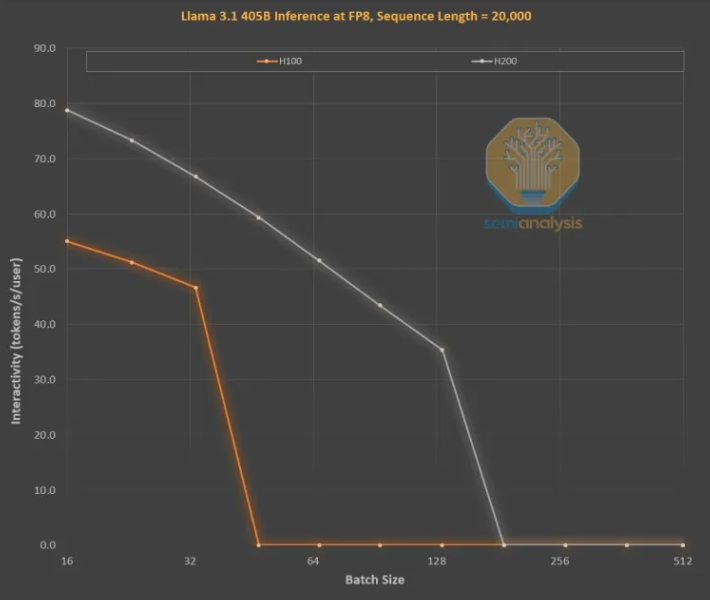

As melhorias de memória são essenciais para o treinamento de inferência LLM no estilo OpenAI O3, pois sequências longas aumentam o KVCache, limitando o tamanho crítico do lote e a latência. A atualização do H100 para o H200 (principalmente o aumento de memória) trouxe melhorias nos dois aspectos a seguir:

Maior largura de banda de memória (4,8 TB/s no H200 e 3,35 TB/s no H100) resultou em uma melhoria geral de 43% na interatividade em todos os tamanhos de lote comparáveis.

Como o H200 executa um lote maior que o H100, o número de tokens gerados por segundo aumenta 3 vezes e o custo é reduzido cerca de 3 vezes. Essa diferença se deve principalmente ao fato de o KVCache limitar o tamanho total do lote.

A melhoria de desempenho de maior capacidade de memória é enorme. As diferenças econômicas e de desempenho entre as duas GPUs são muito maiores do que suas especificações sugerem:

A experiência do usuário com modelos de inferência pode ser ruim porque há uma latência significativa entre solicitações e respostas. Se o tempo de inferência puder ser significativamente acelerado, a disposição dos usuários para usar e pagar aumentará.

A melhoria de 3x no desempenho do hardware devido às atualizações de memória de meia geração é impressionante e muito mais rápida do que a Lei de Moore, a Lei de Huang ou qualquer outra melhoria de hardware que vimos.

Em suma, o lançamento do NVIDIA B300/GB300 não é apenas mais um salto na tecnologia GPU, mas também uma forte promoção da aplicação de modelos de inferência de IA. Melhorará muito a experiência do usuário e reduzirá custos, levando a indústria de IA a. entrar em uma nova etapa de desenvolvimento.