A formação de grandes modelos de IA é dispendiosa e os enormes requisitos de recursos limitam a sua aplicação generalizada e levantam preocupações sobre a eficiência energética e o impacto ambiental. Os métodos tradicionais de treinamento são ineficientes, dependem de matrizes densas e exigem grandes quantidades de memória e poder computacional. Embora alguns métodos existentes tentem amenizar esses problemas, eles ainda apresentam limitações em aplicações práticas. Portanto, é crucial desenvolver uma abordagem que possa reduzir simultaneamente o uso de memória, o custo computacional e o tempo de treinamento sem comprometer o desempenho.

O treinamento de modelos de IA em grande escala (como transformadores e modelos de linguagem) tornou-se um elo fundamental indispensável no campo da IA, mas também enfrenta altos custos de computação, consumo de memória e requisitos de energia. Por exemplo, o GPT-3 da OpenAI tem 175 bilhões de parâmetros e requer semanas de treinamento em GPU. Esta enorme necessidade de recursos limita a aplicação desta tecnologia a organizações de grande escala com recursos computacionais abundantes, ao mesmo tempo que agrava as preocupações sobre a eficiência energética e o impacto ambiental. Enfrentar estes desafios é fundamental para garantir uma maior acessibilidade e sustentabilidade do desenvolvimento da IA.

Os métodos de formação tradicionais são ineficientes e são urgentemente necessárias soluções inovadoras

Estrutura CoMERA: Treinamento eficiente por meio de otimização de tensor adaptativo

A base do CoMERA é uma representação de tensor adaptativo, que permite que as camadas do modelo ajustem dinamicamente suas classificações com base nas restrições de recursos. Ao modificar a classificação do tensor, a estrutura permite a compressão sem comprometer a integridade operacional da rede neural. Esta otimização dinâmica é alcançada através de um processo de treinamento em duas etapas:

Fases iniciais: foco na convergência estável.

Estágios posteriores: ajuste fino da classificação para atender a metas específicas de compactação.

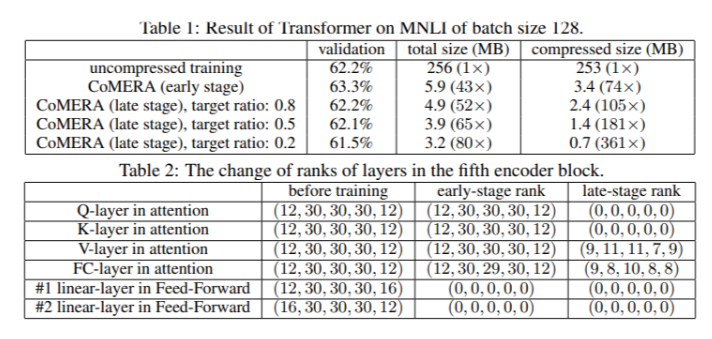

Em um modelo Transformer de seis codificadores, o CoMERA alcançou uma taxa de compressão de até 43x em seus estágios iniciais e uma taxa de compressão ainda maior de 361x em seus estágios posteriores de otimização. Além disso, reduz o consumo de memória em 9 vezes e acelera o treinamento em 2 a 3 vezes por rodada em comparação com o GaLore.

Vários resultados de testes mostram que o CoMERA tem excelente desempenho

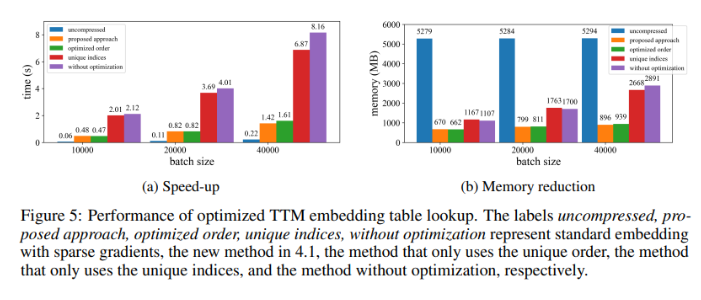

Quando aplicado a um modelo Transformer treinado no conjunto de dados MNLI, o CoMERA reduz o tamanho do modelo de 256 MB para 3,2 MB, mantendo a precisão. Em sistemas de recomendação de grande escala, como DLRM, o CoMERA compacta modelos em 99x e reduz o pico de uso de memória em 7x. A estrutura também teve um bom desempenho no pré-treinamento do CodeBERT, um modelo de linguagem de grande escala específico de domínio, alcançando uma taxa de compactação geral de 4,23x e alcançando uma aceleração de 2x em alguns estágios de treinamento. Esses resultados destacam sua capacidade de lidar com uma variedade de tarefas e arquiteturas, ampliando sua aplicabilidade em diversos campos.

Resumo dos principais benefícios da estrutura CoMERA

As principais conclusões deste estudo são as seguintes:

O CoMERA atinge taxas de compactação de até 361x para camadas específicas e 99x para todo o modelo, reduzindo significativamente os requisitos de armazenamento e memória.

Essa estrutura reduz o tempo de treinamento de cada rodada de Transformer e sistemas de recomendação em 2 a 3 vezes, economizando tempo e recursos de computação.

Ao usar representações tensorizadas e gráficos CUDA, o CoMERA reduz o pico de consumo de memória em 7x, possibilitando o treinamento em GPUs menores.

A abordagem do CoMERA suporta múltiplas arquiteturas, incluindo Transformers e grandes modelos de linguagem, enquanto mantém ou melhora a precisão.

Ao reduzir a energia e os recursos necessários para a formação, o CoMERA ajuda a permitir práticas de IA mais sustentáveis e disponibiliza modelos de ponta a um público mais vasto.

Em suma, a estrutura CoMERA fornece uma solução inovadora para o treinamento eficiente de grandes modelos de IA, o que reduz significativamente os custos computacionais e os requisitos de memória por meio da otimização adaptativa do tensor, mantendo a precisão do modelo. Esta investigação dá um contributo importante para o desenvolvimento contínuo e uma acessibilidade mais ampla ao campo da IA.