Recentemente, a equipe de aprendizagem profunda do Google e pesquisadores de várias universidades lançaram um novo sistema chamado "MegaSaM", que pode estimar com eficiência os parâmetros da câmera e mapas de profundidade a partir de vídeos dinâmicos. Isto marca um grande avanço no campo da visão computacional e espera-se que revolucione a tecnologia de processamento de vídeo e traga aplicações generalizadas em muitos campos. Os métodos tradicionais têm muitas limitações ao lidar com cenas dinâmicas. O surgimento do MegaSaM resolve efetivamente esses problemas e fornece uma nova solução para análise dinâmica de vídeo.

Recentemente, a equipe de aprendizagem profunda do Google e pesquisadores de várias universidades lançaram em conjunto um novo sistema chamado "MegaSaM" que pode estimar com rapidez e precisão os parâmetros da câmera e mapas de profundidade a partir de vídeos dinâmicos comuns. O advento desta tecnologia trará mais possibilidades aos vídeos que gravamos no nosso dia a dia, principalmente no que diz respeito à captura e análise de cenas dinâmicas.

As tecnologias tradicionais de Estrutura de Movimento (SfM) e Localização e Mapeamento Simultâneo Monocular (SLAM) geralmente exigem a entrada de vídeos de cenas estáticas e possuem altos requisitos de paralaxe. Diante de cenas dinâmicas, o desempenho desses métodos muitas vezes é insatisfatório, pois na ausência de fundo estático o algoritmo está sujeito a erros. Embora alguns métodos baseados em redes neurais tenham tentado resolver esse problema nos últimos anos, esses métodos geralmente apresentam enorme sobrecarga computacional e falta de estabilidade em vídeos dinâmicos, especialmente quando o movimento da câmera não é controlado ou o campo de visão é desconhecido.

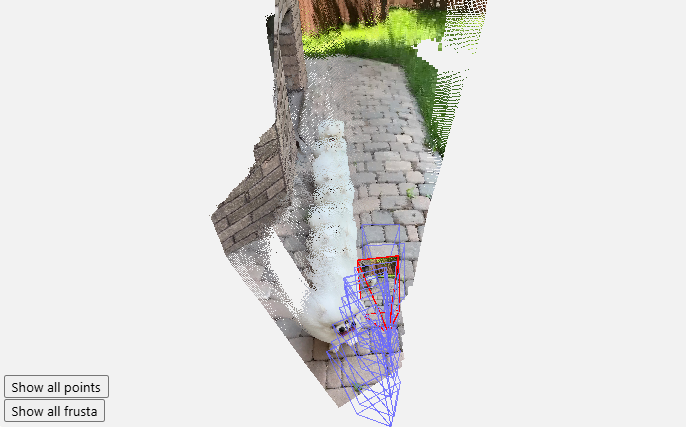

O surgimento do MegaSaM mudou esta situação. A equipe de pesquisa modificou cuidadosamente a estrutura SLAM de visão profunda para permitir sua adaptação a cenas dinâmicas complexas, especialmente quando o caminho da câmera não é restrito. Após uma série de experimentos, os pesquisadores descobriram que o MegaSaM superou significativamente as tecnologias anteriores relacionadas em termos de pose da câmera e estimativa de profundidade, e também teve um bom desempenho em termos de tempo de execução, até mesmo comparável a alguns métodos.

A potência do sistema permite lidar com praticamente qualquer vídeo, incluindo filmagens casuais onde pode haver movimento intenso ou dinâmica de cena durante a filmagem. MegaSaM processa o vídeo de origem a aproximadamente 0,7 quadros por segundo, demonstrando seu excelente desempenho. A equipe de pesquisa também mostra mais resultados de processamento em sua galeria para demonstrar sua eficácia em aplicações do mundo real.

O resultado desta pesquisa não apenas traz sangue novo ao campo da visão computacional, mas também oferece novas possibilidades de processamento de vídeo na vida cotidiana dos usuários. Esperamos ver o MegaSaM em mais cenas no futuro.

Entrada do projeto: https://mega-sam.github.io/#demo

Destaque:

O sistema MegaSaM é capaz de estimar com rapidez e precisão os parâmetros da câmera e mapas de profundidade a partir de vídeos dinâmicos comuns.

Esta tecnologia supera as deficiências dos métodos tradicionais em cenas dinâmicas e se adapta ao processamento em tempo real de ambientes complexos.

Os resultados experimentais mostram que o MegaSaM supera as tecnologias anteriores tanto em precisão quanto em eficiência operacional.

O surgimento do sistema MegaSaM trouxe mudanças revolucionárias ao processamento dinâmico de vídeo, e seu desempenho eficiente e preciso oferece a possibilidade de mais cenários de aplicação no futuro. Acredita-se que com o contínuo desenvolvimento e aprimoramento da tecnologia, o MegaSaM desempenhará um papel importante em mais áreas e trará mais comodidade à vida das pessoas.