A equipe Qwen abriu o código-fonte de seu mais recente modelo de raciocínio multimodal QVQ, que é construído em Qwen2-VL-72B e melhora significativamente a compreensão visual e as capacidades de raciocínio da IA. QVQ alcançou uma pontuação alta de 70,3 no teste MMMU e superou seu modelo antecessor em vários benchmarks matemáticos. Este artigo apresentará detalhadamente as características, vantagens, limitações e uso do modelo QVQ, e fornecerá links relevantes para facilitar aos leitores sua compreensão e utilização.

A equipe Qwen anunciou recentemente o código aberto de seu mais recente modelo de raciocínio multimodal QVQ, marcando um passo importante na compreensão visual da inteligência artificial e nas capacidades complexas de resolução de problemas. Este modelo é construído em Qwen2-VL-72B e visa melhorar as capacidades de raciocínio da IA, combinando linguagem e informações visuais. Na avaliação do MMMU, o QVQ alcançou uma pontuação alta de 70,3 e mostrou melhorias significativas de desempenho em comparação com o Qwen2-VL-72B-Instruct em vários testes de benchmark relacionados à matemática.

O modelo QVQ tem demonstrado vantagens particulares em tarefas de raciocínio visual, especialmente em áreas que requerem pensamento analítico complexo. Apesar do excelente desempenho do QVQ-72B-Preview, a equipe também apontou algumas limitações do modelo, incluindo problemas de mistura de linguagem e troca de código, a possibilidade de cair em padrões lógicos circulares, considerações éticas e de segurança e limitações de desempenho e benchmark. A equipe enfatizou que, embora o modelo tenha melhorado o raciocínio visual, ele não pode substituir completamente a capacidade do Qwen2-VL-72B. Durante o processo de raciocínio visual em várias etapas, o modelo pode perder gradualmente o foco no conteúdo da imagem, levando a alucinações.

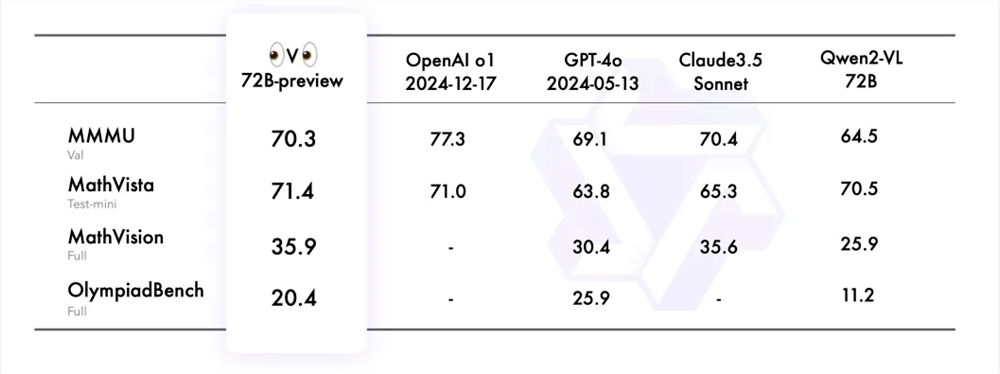

A equipe Qwen avaliou o QVQ-72B-Preview em quatro conjuntos de dados, incluindo MMMU, MathVista, MathVision e OlympiadBench. Esses conjuntos de dados são projetados para examinar a compreensão abrangente do modelo e as capacidades de raciocínio relacionadas à visão. O QVQ-72B-Preview teve um bom desempenho nesses benchmarks, efetivamente fechando a lacuna com o modelo líder.

Para demonstrar ainda mais a aplicação do modelo QVQ em tarefas de raciocínio visual, a equipe Qwen forneceu vários exemplos e compartilhou um link para o blog técnico. Além disso, a equipe também forneceu exemplos de código para inferência de modelo e como usar o Magic API-Inference para chamar diretamente o modelo QVQ-72B-Preview. A API-Inference da Magic Platform fornece suporte para o modelo QVQ-72B-Preview, e os usuários podem usar o modelo diretamente por meio de chamadas de API.

Link do modelo:

https://modelscope.cn/models/Qwen/QVQ-72B-Preview

Link da experiência:

https://modelscope.cn/studios/Qwen/QVQ-72B-preview

Blogue chinês:

https://qwenlm.github.io/zh/blog/qvq-72b-preview

O código aberto do modelo QVQ fornece recursos valiosos para pesquisas multimodais de inteligência artificial e também anuncia o desenvolvimento futuro da IA no campo do raciocínio visual. Embora existam algumas limitações, o seu excelente desempenho em muitos testes de benchmark ainda é impressionante. Esperamos continuar otimizando e melhorando o modelo QVQ no futuro.