Pesquisas conjuntas de instituições importantes, como a Universidade de Harvard e a Universidade de Stanford, mostram que o modelo de visualização o1 da OpenAI demonstrou capacidades incríveis em tarefas de raciocínio médico, superando até mesmo os médicos humanos. Este estudo conduziu uma avaliação abrangente do modelo o1-preview, cobrindo vários aspectos, como geração de diagnóstico diferencial, exibição do processo de raciocínio diagnóstico, diagnóstico diferencial de triagem, raciocínio probabilístico e raciocínio gerencial, e comparou-o com médicos humanos e linguagem inicial em larga escala modelos. Os resultados da pesquisa são atraentes, trazendo novos avanços para a aplicação da inteligência artificial na área médica e também apontando o caminho para a direção futura do desenvolvimento da inteligência artificial médica.

A aplicação da inteligência artificial na área médica mais uma vez marcou o início de um grande avanço! Um estudo conduzido em conjunto pela Universidade de Harvard, Universidade de Stanford e outras instituições importantes mostrou que o modelo de visualização o1 da OpenAI mostrou capacidades incríveis em múltiplas tarefas de raciocínio médico, superando até mesmo médicos humanos. Este estudo não apenas avaliou o desempenho do modelo em testes de referência médicos de múltipla escolha, mas também se concentrou em suas capacidades de diagnóstico e gerenciamento em cenários clínicos simulados da vida real. Os resultados são impressionantes.

Os pesquisadores conduziram uma avaliação abrangente do modelo de visualização o1 por meio de cinco experimentos, incluindo geração de diagnóstico diferencial, exibição do processo de raciocínio diagnóstico, diagnóstico diferencial de triagem, raciocínio probabilístico e raciocínio gerencial. Os experimentos foram avaliados por especialistas médicos usando métodos psicométricos validados e foram projetados para comparar o desempenho do o1-preview com controles humanos anteriores e benchmarks anteriores de grandes modelos de linguagem. Os resultados mostram que o o1-preview alcança melhorias significativas na geração de diagnóstico diferencial e na qualidade do raciocínio diagnóstico e gerencial.

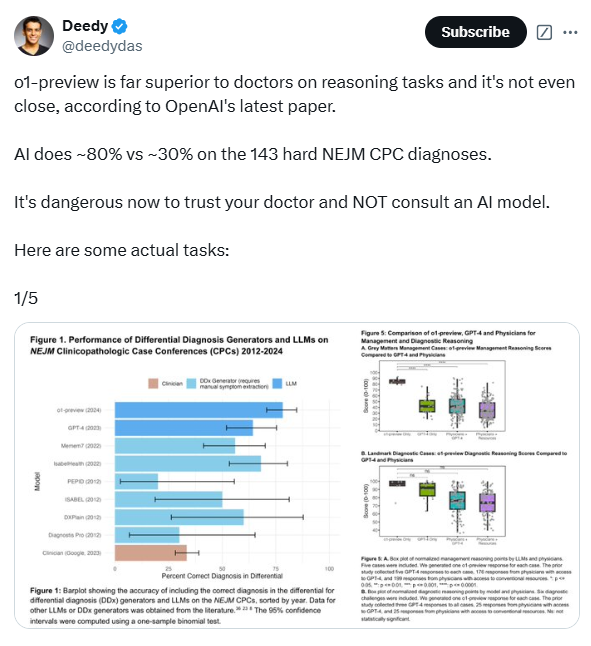

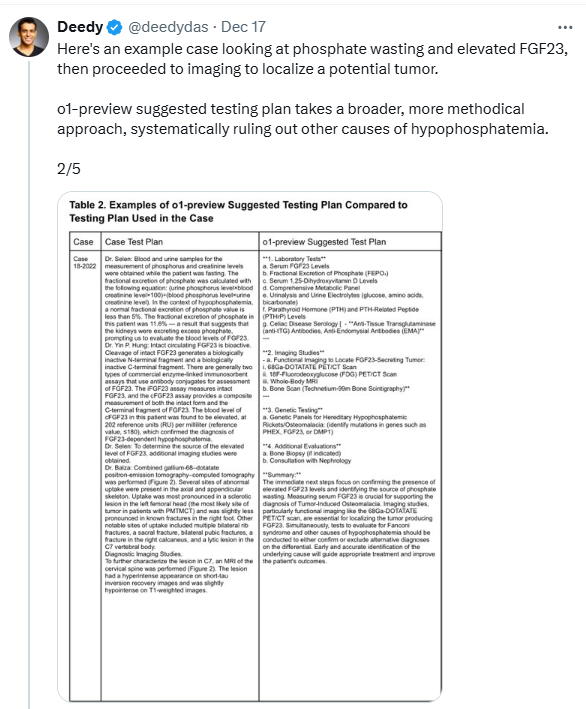

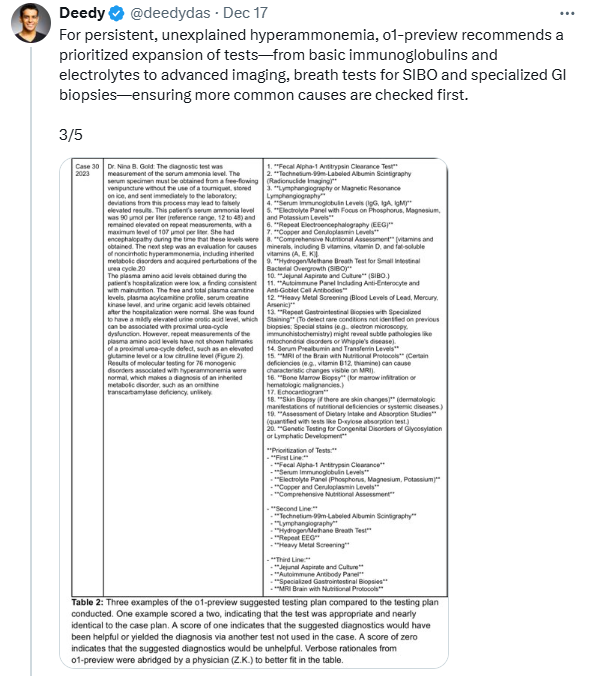

Ao avaliar a capacidade do o1-preview de gerar diagnósticos diferenciais, os pesquisadores usaram casos do Clinical Pathology Colloquium (CPC) publicados no New England Journal of Medicine (NEJM). Os resultados mostraram que o diagnóstico diferencial dado pelo modelo incluiu o diagnóstico correto em 78,3% dos casos, e em 52% dos casos o primeiro diagnóstico foi o diagnóstico correto. Ainda mais surpreendente, a visualização o1 forneceu diagnósticos precisos ou muito próximos em 88,6% dos casos, em comparação com 72,9% dos mesmos casos do modelo GPT-4 anterior. Além disso, o o1-preview também teve um bom desempenho na seleção do próximo teste diagnóstico, selecionando o teste correto em 87,5% dos casos e selecionando um regime de teste que foi considerado útil em 11% dos casos.

Para avaliar melhor as capacidades de raciocínio clínico do o1-preview, os pesquisadores usaram 20 casos clínicos do curso NEJM Healer. Os resultados mostraram que o o1-preview teve um desempenho significativamente melhor do que o GPT-4, médicos assistentes e residentes nesses casos, alcançando pontuações R-IDEA perfeitas em 78/80 casos. A pontuação R-IDEA é uma escala de 10 pontos usada para avaliar a qualidade da documentação do raciocínio clínico. Além disso, os pesquisadores avaliaram as capacidades de gerenciamento e raciocínio diagnóstico do o1-preview por meio do caso de gerenciamento "Grey Matters" e do caso de diagnóstico "Landmark". No caso "Grey Matters", a pré-visualização o1 teve pontuação significativamente mais alta do que GPT-4, médicos que usam GPT-4 e médicos que usam recursos tradicionais. No caso “Landmark”, o1-preview tem desempenho semelhante ao GPT-4, mas melhor do que os médicos que usam GPT-4 ou recursos tradicionais.

No entanto, o estudo também descobriu que o desempenho do o1-preview no raciocínio probabilístico foi semelhante ao modelo anterior, sem melhoria significativa. Em alguns casos, o modelo era inferior aos humanos na previsão de probabilidades de doenças. Os pesquisadores também notaram que uma limitação da visualização o1 é sua tendência a ser prolixo, o que pode ter contribuído para sua pontuação em alguns experimentos. Além disso, este estudo concentrou-se principalmente no desempenho do modelo e não envolveu interação humano-computador, portanto, mais pesquisas sobre como o o1-preview melhora a interação humano-computador são necessárias no futuro para desenvolver ferramentas de apoio à decisão clínica mais eficazes.

Ainda assim, este estudo mostra que o o1-preview tem um bom desempenho em tarefas que exigem pensamento crítico complexo, como diagnóstico e gerenciamento. Os pesquisadores enfatizam que os referenciais de raciocínio diagnóstico na área médica estão rapidamente ficando saturados, necessitando do desenvolvimento de métodos de avaliação mais desafiadores e realistas. Apelam à realização de ensaios destas tecnologias em ambientes clínicos reais e à preparação para a inovação colaborativa entre médicos e inteligência artificial. Além disso, é necessário estabelecer um quadro de supervisão robusto para monitorizar a implementação generalizada de sistemas de apoio à decisão clínica de IA.

Endereço do artigo: https://www.arxiv.org/pdf/2412.10849

Em suma, este estudo fornece fortes evidências para a aplicação da inteligência artificial na área médica e também aponta a direção de pesquisas futuras. O excelente desempenho do modelo o1-preview é empolgante, mas suas limitações também exigem uma consideração cuidadosa e a garantia de sua segurança e confiabilidade em aplicações clínicas. No futuro, a colaboração homem-máquina se tornará uma tendência importante na área médica.