Magic Square Quantitative lançou recentemente uma nova geração de modelo grande DeepSeek-V3. Sua escala de parâmetros de 671 bilhões e arquitetura MoE tornam seu desempenho comparável aos principais modelos de código fechado. atenção na indústria. DeepSeek-V3 teve um bom desempenho em muitos testes, superando especialmente todos os modelos existentes no teste de habilidade matemática, e fornece serviços de API a um preço significativamente inferior a modelos como GPT-4, fornecendo aos desenvolvedores e empresas uma solução de IA econômica. Este artigo analisará detalhadamente o desempenho, custo e estratégia de comercialização do DeepSeek-V3 e discutirá seu impacto na indústria de IA.

A Magic Square Quantitative lançou uma nova geração do modelo grande DeepSeek-V3 na noite de 26 de dezembro, mostrando um incrível avanço tecnológico. Este modelo que usa a arquitetura MoE (Mixed Experts) não é apenas comparável em desempenho aos principais modelos de código fechado, mas seus recursos de baixo custo e alta eficiência atraíram a atenção da indústria.

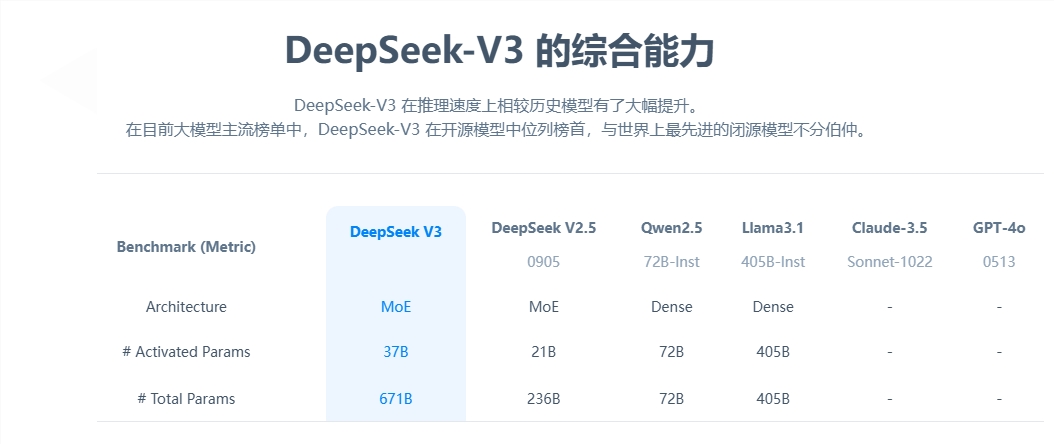

Do ponto de vista dos parâmetros principais, o DeepSeek-V3 possui 671 bilhões de parâmetros, dos quais 37 bilhões são parâmetros de ativação, e completou o pré-treinamento em uma escala de dados de 14,8 trilhões de tokens. Em comparação com o produto da geração anterior, a velocidade de geração do novo modelo foi aumentada em 3 vezes e pode processar 60 tokens por segundo, melhorando significativamente a eficiência das aplicações práticas.

Em termos de avaliação de desempenho, o DeepSeek-V3 apresenta excelente resistência. Ele não apenas supera modelos de código aberto bem conhecidos, como Qwen2.5-72B e Llama-3.1-405B, mas também está no mesmo nível do GPT-4 e Claude-3.5-Sonnet em vários testes. Especialmente no teste de habilidade matemática, o modelo superou todos os modelos existentes de código aberto e fechado com excelentes resultados.

O mais impressionante é a vantagem de baixo custo do DeepSeek-V3. De acordo com documentos de código aberto, calculado em US$ 2 por hora de GPU, o custo total de treinamento do modelo é de apenas US$ 5,576 milhões. Este resultado inovador se deve à otimização colaborativa de algoritmos, estruturas e hardware. O cofundador da OpenAI, Karpathy, elogiou isso, destacando que o DeepSeek-V3 alcançou desempenho superior ao Llama3 em apenas 2,8 milhões de horas de GPU, e a eficiência computacional aumentou cerca de 11 vezes.

Em termos de comercialização, embora o preço do serviço API do DeepSeek-V3 tenha aumentado em comparação com a geração anterior, ele ainda mantém um desempenho de custo elevado. A nova versão custa 0,5-2 yuans por milhão de tokens de entrada e 8 yuans por milhão de tokens de saída, com um custo total de aproximadamente 10 yuans. Em comparação, o preço de serviço equivalente do GPT-4 é de cerca de 140 yuans e a diferença de preço é significativa.

Como um grande modelo abrangente de código aberto, o lançamento do DeepSeek-V3 não apenas demonstra o progresso da tecnologia de IA da China, mas também fornece aos desenvolvedores e empresas uma solução de IA de alto desempenho e baixo custo.

O surgimento do DeepSeek-V3 marca um grande avanço na tecnologia de IA da China no campo de modelos de linguagem em grande escala. Suas vantagens de baixo custo e alto desempenho o tornam altamente competitivo em aplicações comerciais, e vale a pena aguardar seu desenvolvimento futuro. . O código aberto deste modelo também contribui com recursos valiosos para a comunidade global de IA e promove o compartilhamento e o desenvolvimento de tecnologia de IA.