A ByteDance lançou recentemente uma nova geração de modelo de profundidade, Depth Anything V2, que fez um avanço significativo no campo da estimativa de profundidade monocular. Em comparação com a geração anterior, a versão V2 foi bastante melhorada em termos de precisão de detalhes, robustez e eficiência, e sua velocidade é mais de dez vezes mais rápida que o modelo baseado em Difusão Estável. O progresso desta tecnologia não se reflete apenas na otimização do próprio modelo, mas também nos seus métodos de treinamento inovadores, que trazem novas possibilidades ao campo da visão computacional. O artigo detalha os principais recursos, métodos de treinamento e ampla gama de cenários de aplicação do Depth Anything V2, permitindo-nos obter uma compreensão aprofundada do avanço desta tecnologia.

Notícias do ChinaZ.com em 14 de junho: ByteDance lançou uma nova geração do modelo de profundidade Depth Anything V2, que alcançou melhorias significativas de desempenho no campo de estimativa de profundidade monocular. Em comparação com a geração anterior Depth Anything V1, a versão V2 tem detalhes mais finos e robustez mais forte, ao mesmo tempo que melhora significativamente a eficiência, mais de 10 vezes mais rápido que o modelo baseado em difusão estável.

Principais recursos:

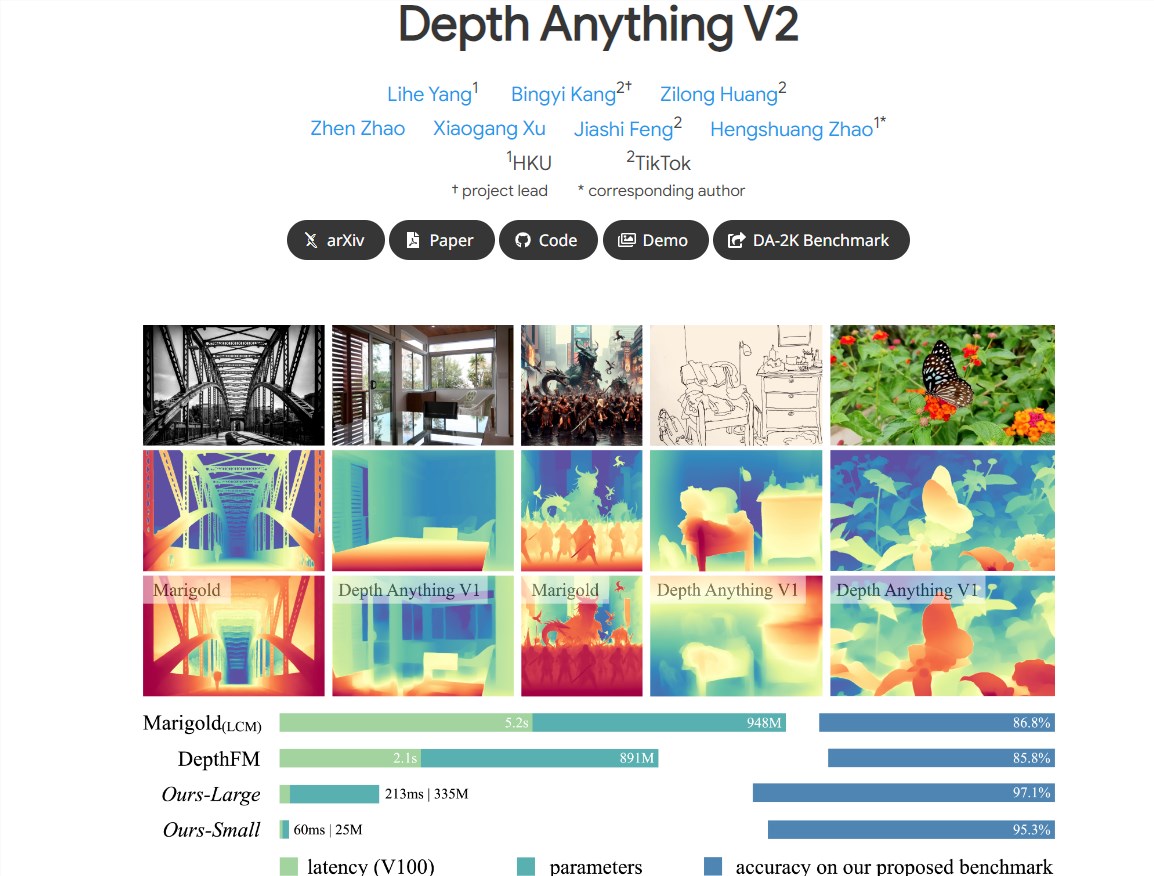

Detalhes mais precisos: O modelo V2 é otimizado em detalhes, fornecendo previsões de profundidade mais precisas.

Alta eficiência e precisão: Comparado com modelos construídos com base em SD, o V2 melhorou significativamente a eficiência e a precisão.

Suporte a modelos multiescala: Fornece modelos de diferentes escalas com parâmetros que variam de 25M a 1,3B para se adaptar a diferentes cenários de aplicação.

Práticas principais: Melhor desempenho do modelo substituindo imagens reais por imagens sintéticas, expandindo a capacidade do modelo do professor e usando imagens pseudo-anotadas em grande escala para ensinar modelos aos alunos.

Três práticas principais para melhorar o desempenho do modelo:

Uso de imagens sintéticas: Todas as imagens reais anotadas são substituídas por imagens sintéticas, o que melhora a eficiência de treinamento do modelo.

Capacidade expandida do modelo de professor: Ao expandir a capacidade do modelo de professor, a capacidade de generalização do modelo é aprimorada.

Aplicação de imagens pseudo-anotadas: Use imagens reais pseudo-anotadas em grande escala como uma ponte para ensinar modelos aos alunos e melhorar a robustez do modelo.

Suporte para uma ampla variedade de cenários de aplicação:

Para atender às necessidades de uma ampla gama de aplicações, os pesquisadores fornecem modelos em diferentes escalas e aproveitam seus recursos de generalização para ajuste fino por rótulos de profundidade métrica.

Um benchmark de avaliação diversificado contendo anotações profundas e esparsas é construído para facilitar pesquisas futuras.

Métodos de treinamento baseados em imagens sintéticas e reais:

Os pesquisadores primeiro treinaram o maior modelo de professor em imagens sintéticas, depois geraram pseudo-rótulos de alta qualidade para imagens reais não rotuladas em grande escala e treinaram modelos de alunos nessas imagens reais pseudo-rotuladas.

O processo de treinamento usa 595 mil imagens sintéticas e mais de 62 milhões de imagens reais pseudo-rotuladas.

O lançamento do modelo Depth Anything V2 demonstra as capacidades inovadoras da ByteDance no campo da tecnologia de aprendizagem profunda. Suas características de desempenho eficientes e precisas indicam que o modelo tem amplo potencial de aplicação no campo da visão computacional.

Endereço do projeto: https://profundidade-anything-v2.github.io/

Em suma, o surgimento do modelo Depth Anything V2 marca um salto significativo na tecnologia de estimativa de profundidade monocular. Sua alta eficiência, precisão e amplas perspectivas de aplicação conferem-lhe um enorme potencial de desenvolvimento no campo da visão computacional no futuro, e vale a pena esperar sua implementação em mais cenários de aplicação.