A velocidade de decodificação do modelo Transformer sempre foi um gargalo importante que restringe sua aplicação. Recentemente, pesquisadores do Instituto Coreano de Ciência e Tecnologia, LG e DeepMind superaram esse problema em conjunto. Eles propuseram uma nova arquitetura chamada Block Transformer, que aumentou a velocidade de decodificação em surpreendentes 10 a 20 vezes! O núcleo deste desenvolvimento inovador está no "corte" inteligente do mecanismo de atenção do Transformer, que resolve efetivamente o problema de baixa utilização da GPU no Transformer tradicional e reduz significativamente a sobrecarga de memória.

Embora o modelo Transformer seja poderoso, sua eficiência na decodificação sempre foi uma dor de cabeça. Porém, pesquisadores do Instituto Coreano de Ciência e Tecnologia, LG e DeepMind desta vez nos trouxeram uma surpresa - eles propuseram uma nova arquitetura Transformer chamada Block Transformer, que aumentou diretamente a velocidade de decodificação em 10 a 20 vezes!

Como isso é feito? Acontece que eles “cortaram” o mecanismo de atenção do Transformer. Dessa forma, o método ineficiente do Transformer original de acessar o cache KV global toda vez que um Token é gerado foi completamente anulado.

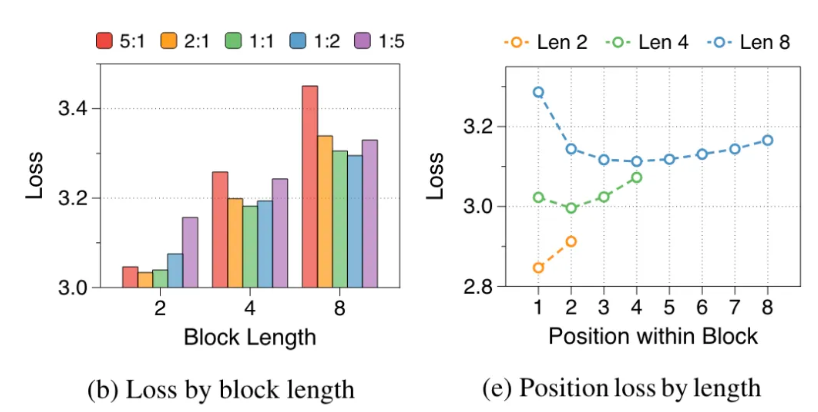

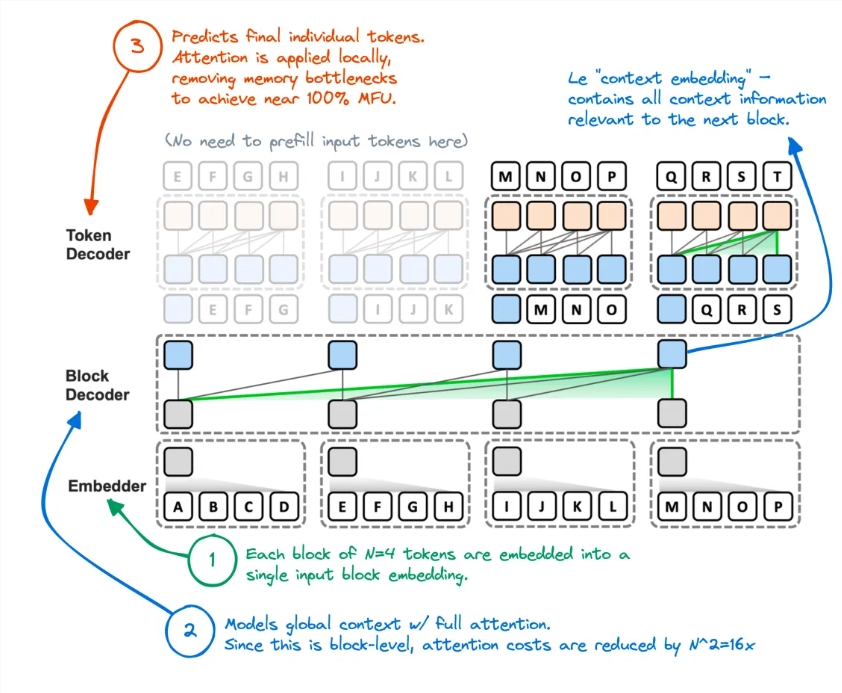

Os pesquisadores analisaram as deficiências do Transformer original: a utilização efetiva da GPU foi inferior a 1% e os 99% restantes foram usados para acesso à memória. Isso é obviamente irracional, então eles propuseram o Block Transformer. Esta nova arquitetura usa a decomposição da atenção no nível do bloco e da atenção intra-bloco para fazer explodir diretamente o rendimento do raciocínio do modelo.

Especificamente, o fluxo de trabalho do Block Transformer é o seguinte: primeiro corte a sequência em blocos e, em seguida, use o Embedder para converter cada bloco em um vetor de incorporação. O Block Decoder é responsável por processar vetores de incorporação de blocos e capturar dependências globais entre blocos. O Token Decoder é responsável por processar dependências locais entre Tokens e gerar sequências de Token.

Este método não apenas melhora a velocidade de inferência, mas também reduz bastante a sobrecarga de memória. Alguns internautas disseram que tiveram uma ideia semelhante antes, mas o desempenho do modelo resultante foi insuficiente. Agora, esse método parece ter reduzido efetivamente o cache KV.

Além disso, a precisão do Block Transformer em múltiplas tarefas de tiro zero é comparável ou até ligeiramente superior à do Transformer original do mesmo tamanho, o que prova que ele melhora a eficiência sem sacrificar a qualidade.

As implicações desta pesquisa não param por aí. Também reduz o custo de treinamento do modelo, a sobrecarga de acesso à memória secundária da atenção global é reduzida em 16 vezes e a utilização da GPU também aumenta de 1% para 44%.

Endereço do artigo: https://arxiv.org/abs/2406.02657

O surgimento do Block Transformer expandiu novas possibilidades para a aplicação de modelos de Transformer e também forneceu uma nova direção para a otimização da eficiência de modelos de linguagem em larga escala no futuro. Espera-se que a sua melhoria significativa em velocidade e eficiência promova o desenvolvimento e a aplicação da tecnologia de IA.