A plataforma aberta Kimi está prestes a lançar os tão esperados testes internos da função Context Caching. Esta tecnologia inovadora melhorará significativamente a experiência do usuário em modelos grandes de texto longo. Ao armazenar em cache o conteúdo duplicado de tokens, o cache de contexto pode reduzir significativamente o custo dos usuários que solicitam o mesmo conteúdo e melhorar significativamente a velocidade de resposta da interface da API. Isto é particularmente importante para cenários de aplicação que exigem solicitações frequentes e referências repetidas a um grande número de contextos iniciais, como cenários de prompt em grande escala e altamente repetitivos.

Notícias do ChinaZ.com em 20 de junho: Kimi Open Platform anunciou recentemente que a tão esperada função Context Caching lançará em breve testes internos. Este recurso inovador suportará grandes modelos de texto longo e proporcionará aos usuários uma experiência sem precedentes por meio de um mecanismo eficiente de cache de contexto.

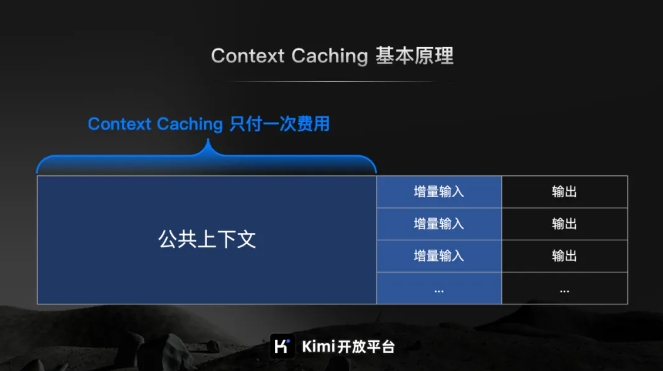

De acordo com a introdução oficial da Kimi Open Platform, o Context Caching é uma tecnologia de ponta projetada para reduzir significativamente o custo dos usuários que solicitam o mesmo conteúdo, armazenando em cache conteúdo duplicado de Tokens. Seu princípio de funcionamento é identificar e armazenar de forma inteligente fragmentos de texto processados. Quando o usuário solicita novamente, o sistema pode recuperá-lo rapidamente do cache, melhorando significativamente a velocidade de resposta da interface API.

Para cenários de prompt em grande escala e altamente repetitivos, as vantagens da função Context Caching são particularmente significativas. Ele pode responder rapidamente a um grande número de solicitações frequentes e melhorar significativamente a eficiência do processamento, ao mesmo tempo que reduz custos ao reutilizar o conteúdo armazenado em cache.

Vale ressaltar especialmente que a função Context Caching é particularmente adequada para cenários de aplicação que exigem solicitações frequentes e referências repetidas a um grande número de contextos iniciais. Através deste recurso, os usuários podem implementar facilmente um cache de contexto eficiente, melhorando assim a eficiência do trabalho e reduzindo os custos operacionais.

Os testes internos da função Context Caching estão prestes a começar, o que marca um passo importante dado pela plataforma aberta Kimi para melhorar a eficiência de grandes modelos e reduzir os custos do usuário.