Equipes de pesquisa de instituições como a Universidade Chinesa de Hong Kong e a Academia Chinesa de Ciências lançaram recentemente um paradigma de pré-treinamento totalmente modal chamado MiCo, que fez progressos inovadores no campo da aprendizagem multimodal e atualizou 37 estados de registros de performance de arte (SOTA). MiCo visa construir inteligência modal completa que possa compreender qualquer modalidade e aprender representações universais, e simular o processo cognitivo multimodal do cérebro humano, introduzindo mais modalidades, volumes de dados e parâmetros de modelo. O núcleo é dividir os diferentes modos em "modo de conhecimento" e "modo de interface", e projetar uma arquitetura de aprendizagem modal completa correspondente, usando o contexto multimodal para fortalecer o reforço mútuo entre as modalidades e construir relações contextuais intermodais. O resultado desta pesquisa fornece novos rumos e ideias para o desenvolvimento do campo da inteligência artificial.

Notícias do ChinaZ.com em 17 de junho: Uma equipe de pesquisa da Universidade Chinesa de Hong Kong, da Academia Chinesa de Ciências e de outras instituições propôs um paradigma de pré-treinamento totalmente modal chamado MiCo (Contexto Multimodal). Este método tem resultados notáveis. foram alcançados no campo da aprendizagem multimodal, estabelecendo 37 recordes de desempenho de última geração (SOTA).

Recursos principais:

Compreensão totalmente modal: o MiCo visa construir inteligência totalmente modal que possa compreender qualquer modalidade e aprender representações universais.

Pré-treinamento em larga escala: Ao introduzir mais modalidades, volumes de dados e parâmetros de modelo, o MiCo simula o processo cognitivo multimodal do cérebro humano durante o processo de pré-treinamento.

Projeto de estrutura de rede neural: MiCo divide diferentes modos em "modo de conhecimento" e "modo de interface" e projeta uma arquitetura de aprendizagem modal completa correspondente, que é alinhada por meio de métodos de raciocínio generativo.

Contexto multimodal e lei de escala: MiCo utiliza contexto multimodal para fortalecer o reforço mútuo entre modalidades e construir relações de contexto intermodal.

Os resultados experimentais mostram:

No teste de benchmark de percepção monomodal de 10 modos diferentes, o MiCo obteve 7 resultados SOTA.

Em 25 tarefas de compreensão intermodal, incluindo recuperação, pergunta e resposta, descrição, etc., o MiCo alcançou 20 resultados SOTA.

Em 18 testes de benchmark de modelos de linguagem multimodais em grande escala, o MiCo alcançou um total de 10 resultados SOTA.

Método de pré-treinamento do MiCo:

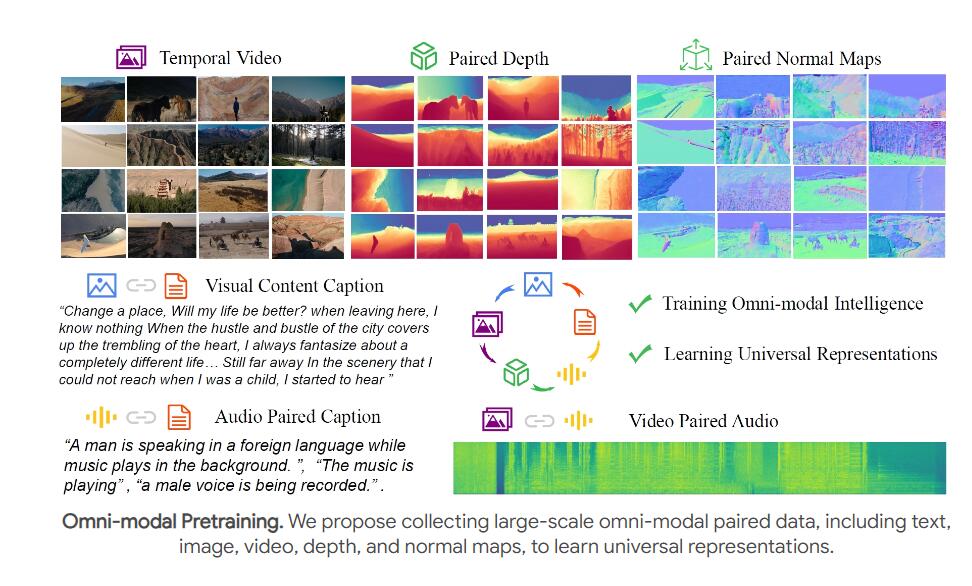

A equipe usou vídeos e áudio emparelhado, descrições de texto, profundidade e normais para pré-treinamento conjunto para simular as capacidades visuais, auditivas e de percepção espaço-temporal do cérebro humano.

Os relacionamentos de contexto multimodais são construídos extraindo recursos multimodais usando um codificador totalmente modal (como ViT) e extraindo recursos de texto usando um codificador de texto.

Conclusão e trabalhos futuros:

O projeto MiCo é uma tentativa importante da inteligência artificial para simular a cognição multimodal do cérebro humano. A equipe espera que ele inspire pesquisas futuras e desenvolva modelos básicos totalmente modais mais poderosos.

Os planos de trabalho futuros incluem a combinação de mais modalidades, como fluxo óptico, dados IMU e arquivos de eventos, para continuar a aprimorar o pré-treinamento conjunto modal completo.

O excelente desempenho do MiCo estabeleceu um novo marco no campo da aprendizagem multimodal. O seu potencial de desenvolvimento futuro é enorme e merece atenção contínua. Também vale a pena aguardar a direção futura da pesquisa da equipe, e acredito que a MiCo continuará a promover o avanço da tecnologia de inteligência artificial.