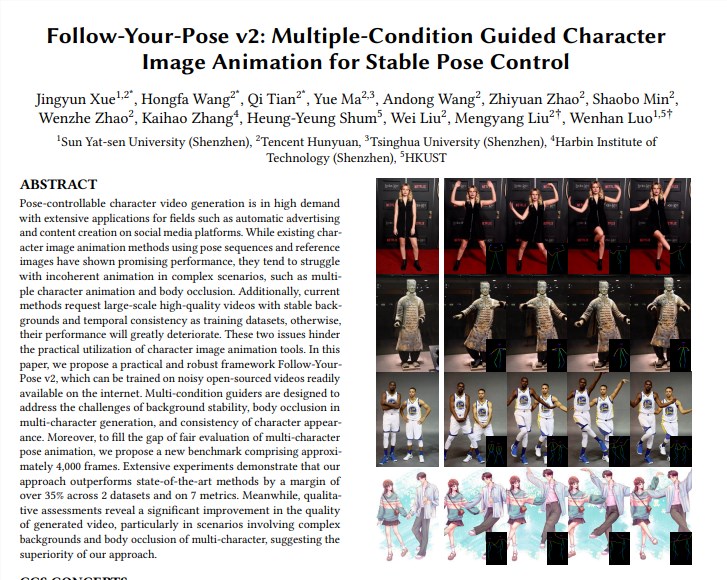

A equipe da Tencent Hunyuan uniu-se à Universidade Sun Yat-sen e à Universidade de Ciência e Tecnologia de Hong Kong para lançar um novo modelo de vídeo Tusheng "Follow-Your-Pose-v2", alcançando um avanço na tecnologia de geração de vídeo de uma pessoa a várias pessoas. Este modelo pode lidar com fotos de grupo de várias pessoas e fazer com que as pessoas nas fotos se movam no vídeo gerado ao mesmo tempo, melhorando significativamente a eficiência e a qualidade da geração do vídeo. O destaque de sua tecnologia é que ela suporta a geração de ações de vídeo para várias pessoas, possui fortes capacidades de generalização, pode ser treinada e gerada usando fotos/vídeos da vida diária e pode lidar corretamente com questões como oclusão de personagens. O modelo supera as técnicas existentes em vários conjuntos de dados, demonstrando seu desempenho poderoso e amplas perspectivas de aplicação.

Apoie a geração de ações de vídeo multipessoas: realize a geração de ações de vídeo multipessoas com raciocínio menos demorado.

Forte capacidade de generalização: Vídeos de alta qualidade podem ser gerados independentemente da idade, roupa, raça, desordem de fundo ou complexidade da ação.

Fotos/vídeos da vida diária disponíveis: O treinamento e a geração de modelos podem usar fotos ou vídeos da vida diária (incluindo instantâneos), sem procurar fotos/vídeos de alta qualidade.

Lidar corretamente com a oclusão de caracteres: Diante do problema de os corpos de vários personagens bloquearem uns aos outros em uma única imagem, ele pode gerar uma imagem de oclusão com a relação correta de frente para trás.

Implementação técnica:

O modelo usa o "guia de fluxo óptico" para introduzir informações de fluxo óptico de fundo, que podem gerar animação de fundo estável mesmo quando a câmera treme ou o fundo está instável.

Através do "Guia do Mapa de Inferência" e do "Guia do Mapa de Profundidade", o modelo pode compreender melhor as informações espaciais dos personagens na imagem e as relações de posição espacial de vários personagens, e resolver efetivamente os problemas de animação de vários personagens e oclusão corporal .

Avalie e compare:

A equipe propôs um novo benchmark Multi-Character, que contém cerca de 4.000 quadros de vídeos com vários caracteres para avaliar o efeito da geração de vários caracteres.

Os resultados experimentais mostram que "Follow-Your-Pose-v2" supera o estado da arte em mais de 35% em dois conjuntos de dados públicos (discursos TikTok e TED) e 7 indicadores.

Perspectivas de aplicação:

A tecnologia de geração de imagem para vídeo tem amplas perspectivas de aplicação em muitos setores, como produção de conteúdo cinematográfico, realidade aumentada, produção de jogos e publicidade. É uma das tecnologias de IA que atrairá muita atenção em 2024.

Informações adicionais:

A equipe Hunyuan da Tencent também anunciou uma biblioteca de aceleração para o grande modelo de código aberto de gráficos vicentinos (Hunyuan DiT), que melhora muito a eficiência do raciocínio e reduz o tempo de geração de gráficos em 75%.

O limite para usar o modelo Hunyuan DiT foi reduzido. Os usuários podem chamar o modelo na biblioteca de modelos oficial do Hugging Face com três linhas de código.

Endereço do artigo: https://arxiv.org/pdf/2406.03035

Página do projeto: https://top.aibase.com/tool/follow-your-pose

O surgimento do modelo "Follow-Your-Pose-v2" marca um grande avanço na tecnologia de vídeo da Tusheng, e vale a pena esperar por suas perspectivas de aplicação em muitos campos. No futuro, com o contínuo desenvolvimento e aprimoramento da tecnologia, acredita-se que este modelo desempenhará um papel importante em mais cenários e trará às pessoas uma experiência de geração de vídeo mais conveniente e inteligente.