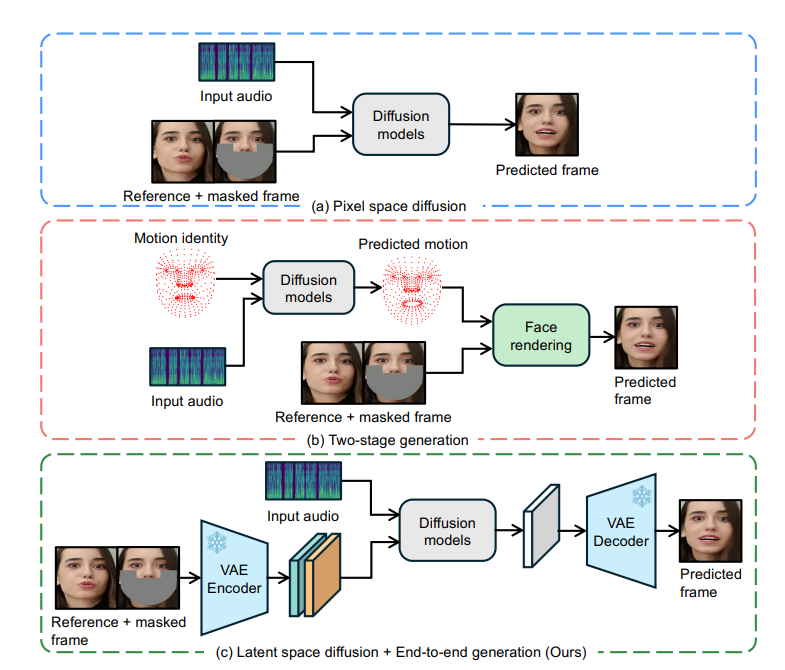

ByteDance abriu o código-fonte de uma tecnologia inovadora de sincronização labial chamada LatentSync, que se baseia no modelo de difusão latente das condições de áudio e alcança uma sincronização precisa dos movimentos labiais do personagem no vídeo com o áudio. Ele utiliza diretamente o poder da Difusão Estável sem a necessidade de representação de movimento intermediário, modela com eficácia associações audiovisuais complexas e melhora a consistência temporal por meio da tecnologia de Alinhamento de Representação Temporal (TREPA). LatentSync também otimiza o problema de convergência do SyncNet e melhora significativamente a precisão da sincronização labial. Esta tecnologia tem vantagens significativas em estrutura ponta a ponta, geração de alta qualidade, consistência temporal e otimização SyncNet, fornecendo uma nova solução para animação de retratos baseada em áudio.

Verificou-se que os métodos de sincronização labial baseados em difusão apresentam baixo desempenho em termos de consistência temporal devido a inconsistências no processo de difusão entre diferentes quadros. Para resolver este problema, LatentSync apresenta a tecnologia Time Representation Alignment (TREPA). TREPA aproveita representações temporais extraídas de grandes modelos de vídeo auto-supervisionados para alinhar quadros gerados com quadros reais, melhorando assim a consistência temporal e mantendo a precisão da sincronização labial.

Além disso, a equipe de pesquisa também conduziu um estudo aprofundado do problema de convergência do SyncNet e, por meio de um grande número de estudos empíricos, identificou os principais fatores que afetam a convergência do SyncNet, incluindo arquitetura de modelo, hiperparâmetros de treinamento e métodos de pré-processamento de dados. Ao otimizar esses fatores, a precisão do SyncNet no conjunto de testes HDTF é significativamente melhorada de 91% para 94%. Como a estrutura geral de treinamento do SyncNet não foi alterada, essa experiência também pode ser aplicada a outros métodos de sincronização labial e animação de retratos baseados em áudio utilizando o SyncNet.

Vantagens do LatentSync

Estrutura ponta a ponta: Gere movimentos labiais sincronizados diretamente do áudio, sem representação de movimento intermediário.

Geração de alta qualidade: use os poderosos recursos do Stable Diffusion para gerar vídeos de fala dinâmicos e realistas.

Consistência temporal: Melhore a consistência temporal entre quadros de vídeo através da tecnologia TREPA.

Otimização SyncNet: Resolva o problema de convergência do SyncNet e melhore significativamente a precisão da sincronização labial.

Princípio de funcionamento

O núcleo do LatentSync é baseado na tecnologia de reparo imagem a imagem, que requer a entrada de uma imagem mascarada como referência. Para integrar as características visuais faciais do vídeo original, o modelo também insere imagens de referência. Após a emenda do canal, essas informações de entrada são inseridas na rede U-Net para processamento.

O modelo usa o extrator de recursos de áudio pré-treinado Whisper para extrair embeddings de áudio. Os movimentos dos lábios podem ser afetados pelo áudio dos quadros circundantes, portanto o modelo agrupa o áudio de vários quadros circundantes como entrada para fornecer mais informações temporais. Os embeddings de áudio são integrados ao U-Net por meio de camadas de atenção cruzada.

Para resolver o problema de que o SyncNet requer entrada de espaço de imagem, o modelo primeiro prevê no espaço ruidoso e, em seguida, obtém o espaço latente limpo estimado por meio de um método de etapa única. O estudo descobriu que o treinamento do SyncNet no espaço de pixels é melhor do que o treinamento no espaço latente, o que pode ocorrer porque as informações da região labial são perdidas durante a codificação VAE.

O processo de treinamento é dividido em duas etapas: na primeira etapa, o U-Net aprende recursos visuais sem decodificação do espaço de pixel e adiciona perda de SyncNet. O segundo estágio adiciona a perda SyncNet usando o método de supervisão do espaço de pixel decodificado e usa a perda LPIPS para melhorar a qualidade visual da imagem. Para garantir que o modelo aprenda informações temporais corretamente, o ruído de entrada também precisa ser temporalmente consistente, e o modelo usa um modelo de ruído misto. Além disso, na fase de pré-processamento de dados, a transformação afim também é utilizada para obter a frontalização facial.

Tecnologia TREPA

TREPA melhora a consistência temporal alinhando as representações temporais de sequências de imagens geradas e reais. Este método usa o modelo de vídeo auto-supervisionado em larga escala VideoMAE-v2 para extrair representações temporais. Ao contrário dos métodos que utilizam apenas perda de distância entre imagens, a representação temporal pode capturar correlações temporais em sequências de imagens, melhorando assim a consistência temporal geral. Estudos descobriram que o TREPA não apenas não prejudica a precisão da sincronização labial, mas pode realmente melhorá-la.

Problemas de convergência SyncNet

A pesquisa descobriu que a perda de treinamento do SyncNet tende a ficar próxima de 0,69 e não pode ser reduzida ainda mais. Através de extensa análise experimental, a equipe de pesquisa descobriu que o tamanho do lote, o número do quadro de entrada e o método de pré-processamento de dados têm um impacto significativo na convergência do SyncNet. A arquitetura do modelo também afeta a convergência, mas em menor grau.

Os resultados experimentais mostram que o LatentSync supera outros métodos de sincronização labial de última geração em múltiplas métricas. Especialmente em termos de precisão de sincronização labial, graças ao SyncNet otimizado e à camada de atenção cruzada de áudio, que pode capturar melhor a relação entre o áudio e os movimentos labiais. Além disso, a consistência temporal do LatentSync foi significativamente melhorada graças à tecnologia TREPA.

Endereço do projeto: https://github.com/bytedance/LatentSync

O código aberto do LatentSync trouxe novos avanços para o desenvolvimento da tecnologia de sincronização labial. Seu desempenho eficiente e preciso e métodos de treinamento otimizados são dignos de pesquisa e aplicação. No futuro, espera-se que esta tecnologia desempenhe um papel mais importante na produção de vídeo, realidade virtual e outros campos.