O efeito da aplicação prática dos modelos de linguagem generativa é frequentemente limitado pela estratégia de decodificação na fase de inferência. Os métodos existentes, como o RLHF, concentram-se principalmente na taxa de vitória do modelo e ignoram o impacto das estratégias de decodificação no desempenho do modelo, resultando em baixa eficiência e dificuldade em garantir a qualidade da saída. Para resolver este problema, o Google DeepMind e a equipe de pesquisa do Google propuseram a estrutura InfAlign, que visa combinar a estratégia de inferência com o processo de alinhamento do modelo para melhorar o desempenho da inferência e a confiabilidade do modelo.

Os modelos de linguagem generativa enfrentam muitos desafios no processo, desde o treinamento até aplicações práticas. Uma das principais questões é como alcançar o desempenho ideal do modelo durante a fase de inferência.

As contramedidas atuais, como a aprendizagem por reforço por meio de feedback humano (RLHF), concentram-se principalmente em melhorar a taxa de vitórias do modelo, mas muitas vezes ignoram estratégias de decodificação durante a inferência, como amostragem Best-of-N e decodificação controlada. Esta lacuna entre os objetivos do treinamento e o uso real pode levar a ineficiências e afetar a qualidade e a confiabilidade do resultado.

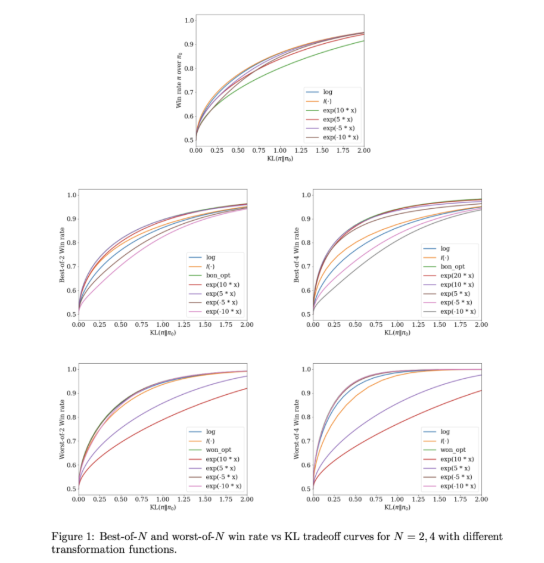

Para resolver esses problemas, o Google DeepMind e a equipe de pesquisa do Google desenvolveram o InfAlign, uma estrutura de aprendizado de máquina projetada para ser combinada com estratégias de inferência. O InfAlign incorpora métodos de tempo de inferência no processo de alinhamento e se esforça para preencher a lacuna entre o treinamento e a aplicação. Ele adota um método de aprendizagem por reforço calibrado para ajustar a função de recompensa com base em uma estratégia de inferência específica. O InfAlign é particularmente eficaz com técnicas como amostragem Best-of-N (gerando múltiplas respostas e selecionando a melhor) e Worst-of-N (comumente usada em avaliações de segurança), garantindo que o modelo alinhado funcione tanto em ambientes controlados quanto em ambientes reais. -cenários de vida bons.

O núcleo do InfAlign é o algoritmo Calibration and Transformation Reinforcement Learning (CTRL), que segue três etapas: calibrar pontuações de recompensa, transformar essas pontuações de acordo com a estratégia de inferência e resolver um problema de otimização regularizado KL. O InfAlign alinha as metas de treinamento com os requisitos de inferência, adaptando as transformações de recompensa a cenários específicos. Este método não apenas melhora a taxa de vitórias durante a inferência, mas também mantém a eficiência computacional. Além disso, o InfAlign aumenta a robustez do modelo, permitindo-lhe lidar eficazmente com várias estratégias de decodificação e produzir resultados consistentes de alta qualidade.

A eficácia do InfAlign é verificada em experimentos usando conjuntos de dados de utilidade e inocuidade da Antrópico. Em comparação com os métodos existentes, o InfAlign melhora a taxa de ganho de inferência em 8%-12% na amostragem Best-of-N e 4%-9% na avaliação de segurança Worst-of-N. Essas melhorias se devem à sua transformação de recompensa calibrada, que resolve efetivamente o problema de má calibração do modelo de recompensa e garante desempenho consistente em diferentes cenários de inferência.

O InfAlign representa um avanço importante no alinhamento de modelos de linguagem generativa. Ao incorporar estratégias com reconhecimento de inferência, o InfAlign aborda a diferença crítica entre treinamento e implantação. A sua sólida base teórica e resultados empíricos destacam o seu potencial para melhorar de forma abrangente o alinhamento do sistema de IA.

Link: https://arxiv.org/abs/2412.19792

Destaques:

InfAlign é um novo framework desenvolvido pelo Google DeepMind, com objetivo de melhorar o desempenho de modelos de linguagem na etapa de inferência.

Esta estrutura ajusta a função de recompensa da estratégia de inferência através de métodos calibrados de aprendizagem por reforço para alcançar o alinhamento entre os objetivos de treinamento e os requisitos de inferência.

Os resultados experimentais mostram que o InfAlign melhora significativamente a taxa de ganho de inferência do modelo em múltiplas tarefas, demonstrando boa adaptabilidade e confiabilidade.

O surgimento da estrutura InfAlign fornece novas ideias para resolver os problemas de eficiência e qualidade dos modelos de linguagem generativa na fase de inferência. Sua contribuição na melhoria da robustez e confiabilidade do modelo merece atenção. Pesquisas futuras podem explorar ainda mais a aplicação do InfAlign em diferentes modelos e tarefas para promover o desenvolvimento contínuo da tecnologia de IA generativa.