Um artigo sobre avaliação de IA médica revelou inesperadamente os tamanhos dos parâmetros de vários modelos de linguagem de grande porte, causando preocupação generalizada na indústria. Este artigo divulgado pela Microsoft toma o teste de benchmark da área médica MEDEC como núcleo e estima os parâmetros do modelo da OpenAI, Anthropic e outras empresas, incluindo modelos como a série GPT-4 da OpenAI e o Claude 3.5 Sonnet da Anthropic. Existem diferenças entre as escalas de parâmetros mencionadas no artigo e nas informações públicas. Por exemplo, a escala de parâmetros do GPT-4 é muito diferente dos dados anunciados anteriormente pela NVIDIA. Isso desencadeou uma discussão acalorada na indústria sobre a arquitetura e a técnica do modelo. força e mais uma vez despertou a preocupação das pessoas sobre os modelos de IA sobre a confidencialidade dos parâmetros.

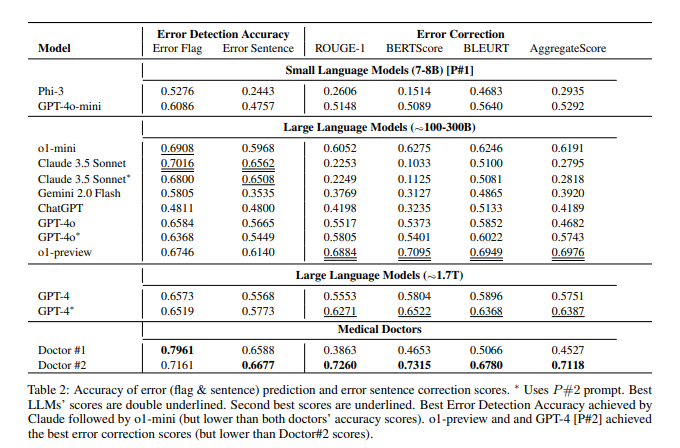

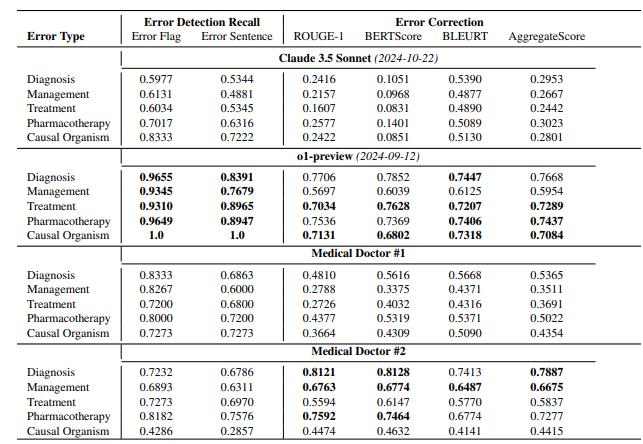

De acordo com o artigo, o modelo de visualização o1 da OpenAI tem cerca de 300B de parâmetros, o GPT-4o tem cerca de 200B e o GPT-4o-mini tem apenas 8B. O tamanho do parâmetro do Claude3.5Sonnet é de cerca de 175B; Os resultados do teste MEDEC mostram que o Claude3.5Sonnet tem um bom desempenho na detecção de erros, com pontuação tão alta quanto 70,16. Os parâmetros do Google Gemini não são mencionados no artigo. Isso pode ocorrer porque o Gemini usa TPU em vez da GPU NVIDIA, o que torna difícil estimar com precisão a velocidade de geração do token. As informações de parâmetros "vazadas" no artigo, bem como os resultados da avaliação do desempenho do modelo, fornecem uma referência valiosa para a indústria pensar profundamente sobre a rota tecnológica do grande modelo, a concorrência comercial e as direções de desenvolvimento futuro.

Esta não é a primeira vez que a Microsoft “vaza” informações de parâmetros do modelo em artigos. Em outubro do ano passado, a Microsoft divulgou o tamanho do parâmetro 20B do GPT-3.5-Turbo em um artigo, mas posteriormente excluiu essa informação em uma versão atualizada. Este repetido “vazamento” levou à especulação entre os membros da indústria sobre se ela tinha alguma intenção específica.

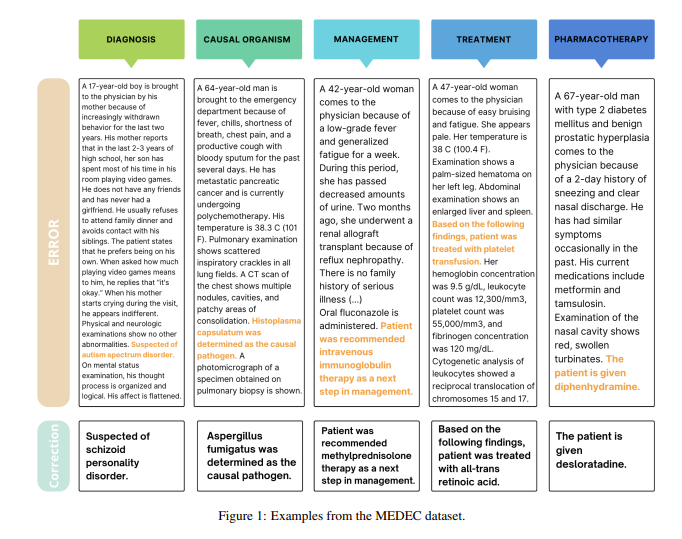

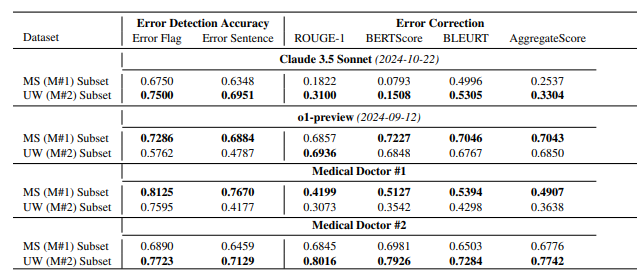

Vale ressaltar que o objetivo principal deste artigo é apresentar um benchmark na área médica denominado MEDEC. A equipe de pesquisa analisou 488 notas clínicas de três hospitais dos EUA e avaliou a capacidade dos principais modelos de identificar e corrigir erros de documentação médica. Os resultados do teste mostram que Claude3.5Sonnet lidera outros modelos na detecção de erros com uma pontuação de 70,16.

Tem havido uma discussão acalorada na indústria sobre a autenticidade desses dados. Algumas pessoas acreditam que se o Claude3.5Sonnet alcançar um desempenho excelente com um número menor de parâmetros, isso destacará a força técnica do Antrópico. Alguns analistas também acreditam que algumas estimativas de parâmetros são razoáveis através da inferência de preços do modelo.

O que é particularmente digno de nota é que o artigo apenas estima os parâmetros dos modelos convencionais, mas não menciona os parâmetros específicos do Google Gemini. Alguns analistas acreditam que isso pode estar relacionado ao uso de TPU pela Gemini em vez da GPU NVIDIA, tornando difícil estimar com precisão a velocidade de geração de tokens.

À medida que a OpenAI dilui gradualmente o seu compromisso com o código aberto, as informações essenciais, como os parâmetros do modelo, podem continuar a tornar-se o foco de atenção contínua na indústria. Esse vazamento inesperado mais uma vez desencadeou o pensamento aprofundado das pessoas sobre a arquitetura do modelo de IA, rotas técnicas e competição empresarial.

Referências:

https://arxiv.org/pdf/2412.19260

https://x.com/Yuchenj_UW/status/1874507299303379428

https://www.reddit.com/r/LocalLLaMA/comments/1f1vpyt/why_gpt_4o_mini_is_probably_around_8b_active/

Em suma, embora as informações dos parâmetros do modelo "vazadas" neste artigo não sejam o conteúdo principal da pesquisa do artigo, elas desencadearam discussões aprofundadas na indústria sobre a escala de grandes parâmetros do modelo, a seleção de rotas técnicas e o cenário da concorrência comercial, fornecendo uma base para o desenvolvimento futuro do campo da inteligência artificial. Fornece novas direções de pensamento.