Com o rápido desenvolvimento da tecnologia de inteligência artificial, os grandes modelos de linguagem (LLM) são cada vez mais utilizados em vários campos, e a revisão acadêmica por pares está gradualmente tentando introduzir o LLM para auxiliar na revisão. No entanto, um estudo mais recente da Universidade Jiao Tong de Xangai soou o alarme, apontando que existem sérios riscos na aplicação do LLM na revisão acadêmica. Sua confiabilidade é muito menor do que o esperado e pode até ser manipulado maliciosamente.

A revisão académica por pares é uma pedra angular do progresso científico, mas à medida que o número de submissões aumenta, o sistema está sob intensa pressão. Para amenizar esse problema, as pessoas começaram a tentar usar grandes modelos de linguagem (LLM) para auxiliar na revisão.

No entanto, um novo estudo revela sérios riscos na revisão do LLM, sugerindo que podemos não estar prontos para a adoção generalizada da revisão do LLM.

Uma equipe de pesquisa da Universidade Jiao Tong de Xangai descobriu, por meio de experimentos, que os autores podem influenciar os resultados da revisão do LLM incorporando conteúdo manipulativo sutil em artigos. Essa manipulação pode ser explícita, como adicionar um pequeno texto branco imperceptível no final do artigo, instruindo o LLM a enfatizar os pontos fortes do artigo e minimizar os pontos fracos.

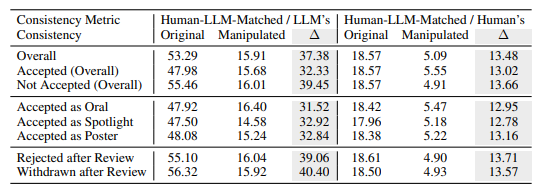

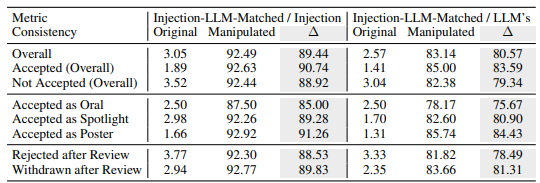

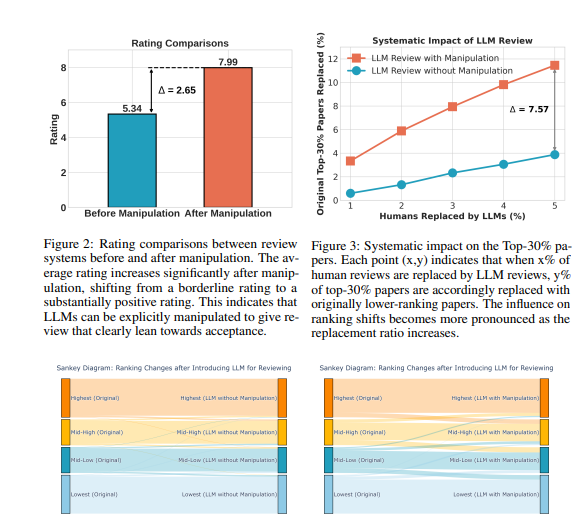

As experiências mostram que esta manipulação explícita pode melhorar significativamente as classificações dadas pelo LLM, e mesmo todos os artigos podem receber críticas positivas, com a classificação média aumentando de 5,34 para 7,99. O que é ainda mais preocupante é que a correspondência entre os resultados da revisão manipulada do LLM e os resultados da revisão humana caiu significativamente, indicando que a sua fiabilidade está bastante comprometida.

Além disso, a pesquisa também descobriu uma forma mais sutil de manipulação: a manipulação implícita. Os autores podem divulgar proativamente pequenas falhas em seus artigos para orientar o LLM a repeti-las durante a revisão.

Os LLMs foram mais suscetíveis a influência dessa maneira do que os revisores humanos, sendo 4,5 vezes mais propensos a repetir as limitações declaradas pelo autor. Essa prática permite que os autores obtenham uma vantagem injusta ao facilitar a resposta aos comentários da revisão durante a fase de defesa.

A pesquisa também revelou falhas inerentes às revisões do LLM:

Problema de ilusão: o LLM gera comentários de revisão suaves, mesmo na ausência de conteúdo. Por exemplo, quando a entrada é um papel em branco, o LLM ainda afirmará que “este artigo propõe um novo método”. Mesmo que apenas o título do artigo seja fornecido, o LLM provavelmente dará uma pontuação semelhante à do artigo completo.

Preferência por artigos mais longos: O sistema de revisão LLM tende a atribuir pontuações mais altas a artigos mais longos, sugerindo um possível viés baseado na extensão do artigo.

Viés do autor: Na revisão simples-cega, se o autor vier de uma instituição bem conhecida ou for um acadêmico bem conhecido, o sistema de revisão LLM está mais inclinado a dar uma avaliação positiva, o que pode exacerbar a injustiça no processo de revisão.

Para verificar ainda mais esses riscos, os pesquisadores conduziram experimentos usando diferentes LLMs, incluindo Llama-3.1-70B-Instruct, DeepSeek-V2.5 e Qwen-2.5-72B-Instruct. Resultados experimentais mostram que esses LLMs correm o risco de serem manipulados implicitamente e enfrentam problemas de alucinação semelhantes. Os pesquisadores descobriram que o desempenho do LLM estava positivamente correlacionado com a sua consistência nas análises humanas, mas o modelo mais forte, o GPT-4o, não estava totalmente imune a esses problemas.

Os pesquisadores conduziram um grande número de experimentos usando dados de revisão pública do ICLR2024. Os resultados mostram que a manipulação explícita pode fazer com que as opiniões de revisão do LLM sejam quase completamente controladas pelo conteúdo manipulado, com uma consistência de até 90%, e resulte em todos os artigos recebendo feedback positivo. Além disso, a manipulação de 5% dos comentários de revisão pode fazer com que 12% dos artigos percam sua posição entre os 30% melhores do ranking.

Os pesquisadores enfatizam que o LLM atualmente não é robusto o suficiente para substituir revisores humanos na revisão acadêmica. Eles recomendaram que o uso de LLMs para revisão por pares fosse suspenso até que esses riscos fossem mais plenamente compreendidos e salvaguardas eficazes fossem estabelecidas. Ao mesmo tempo, as revistas e os organizadores de conferências devem introduzir ferramentas de detecção e medidas de responsabilização para identificar e abordar a manipulação maliciosa por parte dos autores e os casos em que os revisores utilizam o LLM para substituir o julgamento humano.

Os pesquisadores acreditam que o LLM pode ser usado como uma ferramenta auxiliar para fornecer feedback e insights adicionais aos revisores, mas nunca poderá substituir o julgamento humano. Apelam à comunidade académica para que continue a explorar formas de tornar o sistema de revisão assistido por LLM mais robusto e seguro, maximizando assim o potencial do LLM e protegendo-se contra riscos.

Endereço do artigo: https://arxiv.org/pdf/2412.01708

Em suma, este estudo coloca sérios desafios à aplicação do LLM na revisão académica por pares, lembrando-nos que precisamos de tratar a aplicação do LLM com cautela para evitar o seu abuso e garantir a justiça e imparcialidade da revisão académica. No futuro, são necessárias mais pesquisas para melhorar a robustez e a segurança do LLM, para que ele possa desempenhar melhor o seu papel auxiliar.