Alibaba Damo Academy lançou Valley2, um modelo de linguagem multimodal em grande escala baseado em cenários de comércio eletrônico. Este modelo combina Qwen2.5, codificador visual SigLIP-384 e módulos Eagle inovadores e adaptadores de convolução para melhorar o comércio eletrônico e o desempenho do aplicativo. no campo de vídeo curto. O conjunto de dados do Valley2 abrange dados de estilo OneVision, dados de campo de vídeo curto e de comércio eletrônico e dados de pensamento em cadeia. Após treinamento em vários estágios, obteve excelentes resultados em vários testes de benchmark públicos, especialmente em avaliações relacionadas ao comércio eletrônico. A otimização de seu projeto de arquitetura e estratégia de treinamento fornece novas ideias para melhorar o desempenho de grandes modelos multimodais.

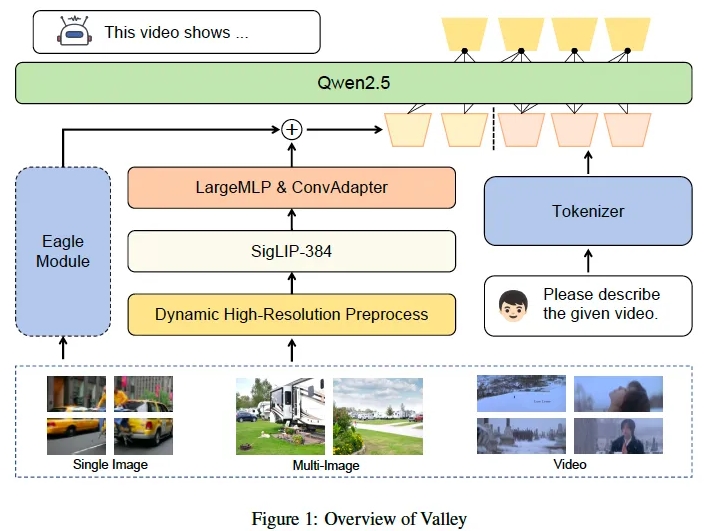

Alibaba Damo Academy lançou recentemente um modelo de linguagem multimodal em grande escala chamado Valley2. Este modelo foi projetado com base em cenários de comércio eletrônico e visa melhorar o desempenho em vários campos e expandir o comércio eletrônico e o uso de curto prazo por meio de um visual escalável. arquitetura de linguagem. Limites de aplicação de cenas de vídeo. Valley2 usa Qwen2.5 como backbone LLM, emparelhado com o codificador visual SigLIP-384 e combina camadas MLP e convoluções para conversão eficiente de recursos. Sua inovação reside na introdução de um grande vocabulário visual, adaptador de convolução (ConvAdapter) e módulo Eagle, que aumenta a flexibilidade de processamento de diversas entradas do mundo real e a eficiência da inferência de treinamento.

Os dados do Valley2 consistem em dados do estilo OneVision, dados para comércio eletrônico e campos de vídeo curtos, e dados de Cadeia de Pensamento (CoT) para resolução de problemas complexos. O processo de treinamento é dividido em quatro etapas: alinhamento texto-visual, aprendizagem de conhecimento de alta qualidade, ajuste fino de instruções e pensamento em cadeia pós-treinamento. Em experimentos, o Valley2 teve um bom desempenho em vários testes de benchmark públicos, especialmente com pontuações altas no MMBench, MMStar, MathVista e outros benchmarks, e também superou outros modelos do mesmo tamanho no teste de benchmark Ecom-VQA.

No futuro, a Alibaba DAMO Academy planeja lançar um modelo abrangente, incluindo modalidades de texto, imagem, vídeo e áudio, e introduzir um método de treinamento de incorporação multimodal baseado em Valley para apoiar aplicações de recuperação e detecção downstream.

O lançamento do Valley2 marca um progresso importante no campo dos modelos de linguagem multimodais em grande escala, demonstrando a possibilidade de melhorar o desempenho do modelo através da melhoria estrutural, construção de conjuntos de dados e otimização da estratégia de treinamento.

Link do modelo:

https://www.modelscope.cn/models/bytedance-research/Valley-Eagle-7B

Link do código:

https://github.com/bytedance/Valley

Link do papel:

https://arxiv.org/abs/2501.05901

O lançamento do Valley2 não apenas demonstra a tecnologia avançada da Alibaba Damo Academy no campo de grandes modelos multimodais, mas também indica que os campos de comércio eletrônico e vídeos curtos darão início a aplicações mais inovadoras baseadas em IA no futuro. Esperamos que a Valley2 seja capaz de melhorar e expandir ainda mais seus cenários de aplicação no futuro, trazendo serviços mais convenientes e inteligentes aos usuários.