Melhorar a eficiência do raciocínio de grandes modelos é um desafio fundamental no campo da inteligência artificial. Alta carga de inferência, alto custo e longo tempo de resposta restringem severamente a aplicação de modelos grandes. Para resolver esses problemas, a Kimi Company cooperou com o Laboratório MADSys da Universidade Tsinghua para desenvolver em conjunto o sistema de inferência Mooncake baseado em KVCache e será lançado oficialmente em junho de 2024. O sistema adota uma arquitetura inovadora de separação PD e um conceito centrado na conversão de armazenamento para melhorar significativamente o rendimento do raciocínio. Com o objetivo de promover a aplicação e popularização da tecnologia, o projeto Mooncake é oficialmente open source.

A Kimi Company, em conjunto com o Laboratório MADSys da Universidade de Tsinghua, lançou o plano de design do sistema de inferência Mooncake baseado em KVCache, que será lançado oficialmente em junho de 2024.

O sistema de inferência Mooncake melhorou significativamente o rendimento da inferência por meio de sua inovadora arquitetura de separação PD e conceito centrado na conversão de armazenamento, atraindo ampla atenção da indústria. A fim de promover ainda mais a aplicação e popularização desta estrutura técnica, o Laboratório MADSys da Universidade Kimi e Tsinghua se uniu a uma série de empresas, como 9#AISoft, Alibaba Cloud, Huawei Storage, etc., para lançar o projeto de código aberto Mooncake . No dia 28 de novembro, o framework técnico do Mooncake foi lançado oficialmente na plataforma GitHub.

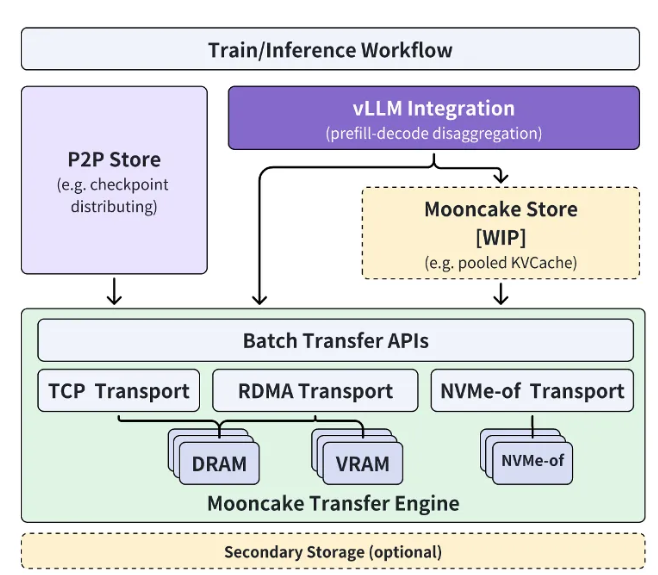

O projeto de código aberto Mooncake gira em torno do pool de cache KVCache de escala ultralarga e está comprometido em abrir gradualmente o código-fonte do Mooncake Store de cache multinível KVCache de alto desempenho em fases. Ao mesmo tempo, o projeto será compatível com uma variedade de mecanismos de inferência e recursos subjacentes de armazenamento e transmissão.

Atualmente, a parte do Transfer Engine tem código aberto globalmente no GitHub. O objetivo final do projeto Mooncake é construir uma nova interface padrão para armazenamento semântico de memória de alto desempenho para a era dos grandes modelos e fornecer soluções de implementação de referência relacionadas.

Xu Xinran, vice-presidente de engenharia da Kimi Company, disse: “Através de estreita cooperação com o laboratório MADSys da Universidade de Tsinghua, criamos em conjunto Mooncake, uma arquitetura de inferência de grande modelo separada, alcançando a otimização final dos recursos de inferência.

Mooncake não apenas melhora a experiência do usuário, mas também reduz custos, fornecendo uma solução eficaz para processamento de textos longos e altos requisitos de simultaneidade. ” Ele espera que mais empresas e instituições de pesquisa se juntem ao projeto Mooncake para explorar conjuntamente uma arquitetura de sistema de raciocínio de modelo mais eficiente, para que produtos baseados em tecnologia de grande modelo, como assistentes de IA, possam beneficiar uma gama mais ampla de pessoas.

Entrada do projeto: https://github.com/kvcache-ai/Mooncake

Destaque:

Kimi e a Universidade Tsinghua lançaram em conjunto o sistema de raciocínio Mooncake para melhorar a eficiência do raciocínio de IA.

O projeto Mooncake tem código aberto no GitHub e tem como objetivo construir uma interface padrão de armazenamento semântico de memória de alto desempenho.

Aguardamos com expectativa a participação de mais empresas e instituições de investigação para promover conjuntamente o progresso da tecnologia de IA.

O lançamento do projeto de código aberto Mooncake marca uma nova etapa na arquitetura de sistemas de inferência de grandes modelos. O seu desempenho eficiente e o seu modelo de cooperação aberta promoverão eficazmente o progresso e a aplicação da tecnologia de inteligência artificial e contribuirão para a construção de um mundo mais inteligente.