Os pesquisadores científicos ainda estão preocupados com revisões de literatura e redação de artigos? OpenScholar trazido pela equipe AI2 pode resolver seu problema! Este poderoso artefato de eficiência de pesquisa científica possui 450 milhões de artigos de acesso aberto e 237 milhões de incorporações de parágrafos de artigos. Ele pode lidar com eficiência com vários problemas de pesquisa científica e aprimorar o mecanismo de raciocínio por meio de recuperação exclusiva de autofeedback para melhorar continuamente as respostas até que satisfaça suas necessidades. OpenScholar não é apenas poderoso, mas também pode ser usado para treinar modelos mais eficientes. Superou especialistas humanos no teste SCHOLARQABENCH, demonstrando seu enorme potencial no campo da pesquisa científica.

Ficar acordado até tarde para revisar a literatura? Coçando a cabeça e escrevendo um artigo Não entre em pânico! Os especialistas em pesquisa científica da AI2 estão aqui para salvá-lo com sua mais recente obra-prima, o OpenScholar! como passear no parque!

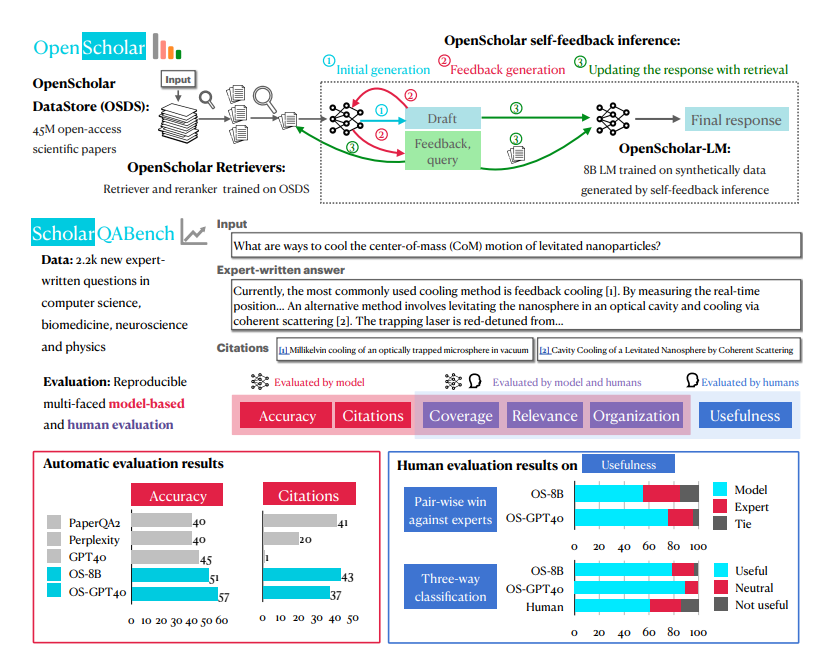

A maior arma secreta do OpenScholar é um sistema chamado OpenScholar-Datastore (OSDS) com 450 milhões de artigos de acesso aberto e 237 milhões de parágrafos de artigos incorporados. Com uma base de conhecimento tão forte, o OpenScholar pode lidar com vários problemas de pesquisa científica com facilidade.

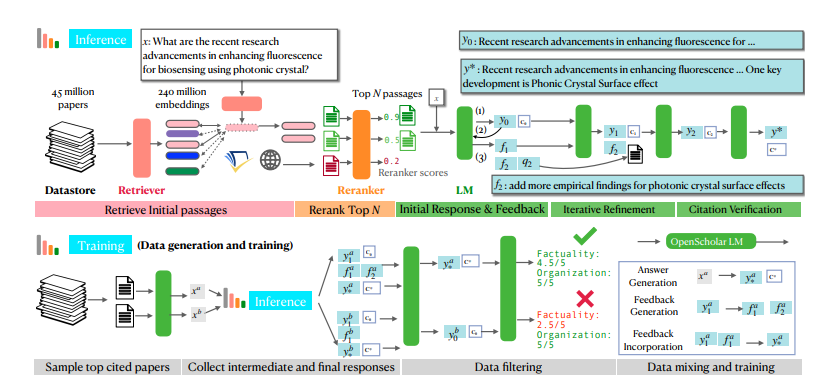

Quando você encontrar um problema de pesquisa científica, o OpenScholar primeiro enviará suas ferramentas poderosas - o buscador e reordenador, para filtrar rapidamente os parágrafos do artigo relacionados ao seu problema do OSDS. A seguir, um modelo de linguagem (LM) contém a resposta completa para a referência. O que é ainda mais poderoso é que o OpenScholar continuará a melhorar as respostas com base no seu feedback em linguagem natural e a complementar as informações que faltam até que você esteja satisfeito.

O OpenScholar não é apenas poderoso por si só, mas também pode ajudar a treinar modelos menores e mais eficientes. Os pesquisadores usaram o processo do OpenScholar para gerar grandes quantidades de dados de treinamento de alta qualidade e usaram esses dados para treinar um modelo de linguagem de 8 bilhões de parâmetros chamado OpenScholar-8B, bem como outros modelos de recuperação.

Para testar de forma abrangente a eficácia de combate do OpenScholar, os pesquisadores também criaram especialmente uma nova arena de testes chamada SCHOLARQABENCH. Uma variedade de tarefas de revisão de literatura científica são estabelecidas nesta área, incluindo classificação fechada, múltipla escolha e geração de formato longo, cobrindo vários campos, como ciência da computação, biomedicina, física e neurociência. A fim de garantir a imparcialidade e justiça da competição, o SCHOLARQABENCH também utiliza métodos de avaliação multifacetados, incluindo revisão de especialistas, indicadores automáticos e testes de experiência do usuário.

Depois de muitas rodadas de competição acirrada, o OpenScholar finalmente se destacou. Os resultados experimentais mostraram que ele teve um bom desempenho em diversas tarefas, superando até mesmo os especialistas humanos. Este resultado inovador certamente desencadeará uma revolução no campo da pesquisa científica e permitirá que os cientistas digam adeus ao difícil! trabalho de revisão de literatura, com foco na exploração dos mistérios da ciência!

As poderosas funções do OpenScholar se beneficiam principalmente de seu mecanismo exclusivo de raciocínio aprimorado de recuperação de autofeedback. Simplificando, ele primeiro fará perguntas a si mesmo, depois melhorará continuamente as respostas com base em suas próprias respostas e, finalmente, apresentará a você a resposta mais perfeita. Não é incrível?

Especificamente, o processo de raciocínio de autofeedback do OpenScholar é dividido em três etapas: geração inicial de respostas, geração de feedback e integração de feedback. Primeiro, o modelo de linguagem gera uma resposta inicial com base nas passagens do artigo recuperadas. Então, como um examinador severo, ele autocriticará suas respostas, identificará deficiências e gerará algum feedback em linguagem natural, como "A resposta contém apenas resultados experimentais em tarefas de perguntas e respostas, complemente outros tipos de resultados de tarefas". . Finalmente, o modelo de linguagem irá pesquisar a literatura relevante com base neste feedback e integrar todas as informações para gerar uma resposta mais completa.

Para treinar modelos menores, mas igualmente poderosos, os pesquisadores também usaram o processo de inferência de autofeedback do OpenScholar para gerar grandes quantidades de dados de treinamento de alta qualidade. Eles primeiro selecionaram os artigos mais citados do banco de dados, depois geraram algumas perguntas de consulta de informações com base nos resumos desses artigos e, finalmente, usaram o processo de inferência do OpenScholar para gerar respostas de alta qualidade. Estas respostas e as informações de feedback geradas no processo constituem dados de treinamento valiosos. Os pesquisadores misturaram esses dados com dados de ajuste fino de instrução de domínio geral existentes e dados de ajuste fino de instrução de domínio científico para treinar um modelo de linguagem de 8 bilhões de parâmetros chamado OpenScholar-8B.

Para avaliar de forma mais completa o desempenho do OpenScholar e de outros modelos semelhantes, os pesquisadores também criaram um novo benchmark chamado SCHOLARQABENCH. Este benchmark contém 2.967 questões de revisão de literatura escritas por especialistas que abrangem quatro áreas: ciência da computação, física, biomedicina e neurociência. Cada pergunta tem uma resposta longa escrita por um especialista e, em média, cada resposta leva cerca de uma hora para ser concluída. O SCHOLARQABENCH também emprega uma abordagem de avaliação multifacetada que combina métricas automatizadas e avaliação manual para fornecer uma medida mais abrangente da qualidade das respostas geradas pelo modelo.

Os resultados experimentais mostram que o desempenho do OpenScholar no SCHOLARQABENCH excede em muito outros modelos e até supera os especialistas humanos em alguns aspectos. Por exemplo, no campo da ciência da computação, a taxa correta do OpenScholar-8B é 5% maior que a do GPT-4o, que é 5% maior! do que o do GPT-4o é 7% maior. Além disso, a precisão de citação das respostas geradas pelo OpenScholar é comparável à de especialistas humanos, enquanto o GPT-4o chega a 78-90% fabricado do nada.

O surgimento do OpenScholar é, sem dúvida, um grande benefício para o campo da pesquisa científica. Ele pode não apenas ajudar os pesquisadores científicos a economizar muito tempo e energia, mas também a melhorar a qualidade e a eficiência das revisões da literatura! Acredito que num futuro próximo o OpenScholar se tornará um auxiliar indispensável para pesquisadores científicos!

Endereço do artigo: https://arxiv.org/pdf/2411.14199

Endereço do projeto: https://github.com/AkariAsai/OpenScholar

Em suma, o OpenScholar trouxe mudanças revolucionárias ao trabalho de investigação científica com as suas poderosas reservas de dados, mecanismos de raciocínio inovadores e excelentes resultados de testes. Melhorará efetivamente a eficiência da investigação científica e ajudará os investigadores a concentrarem-se em explorações científicas mais importantes. É um grande avanço no campo da investigação científica.