Você está curioso para saber como funcionam IA como ChatGPT e Wen Xinyiyan? Todos eles são baseados em grandes modelos de linguagem (LLM). Este artigo usará um método simples e fácil de entender. Mesmo que você tenha apenas um nível de matemática da segunda série, poderá entender o princípio de funcionamento do LLM. Começaremos com os conceitos básicos de redes neurais e explicaremos gradualmente as principais tecnologias, como digitalização de texto, treinamento de modelos, técnicas avançadas e arquitetura GPT e Transformer, levando você a desvendar o mistério do LLM.

Redes Neurais: A Magia dos Números

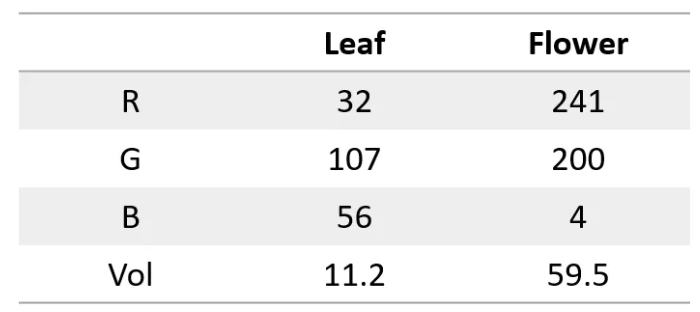

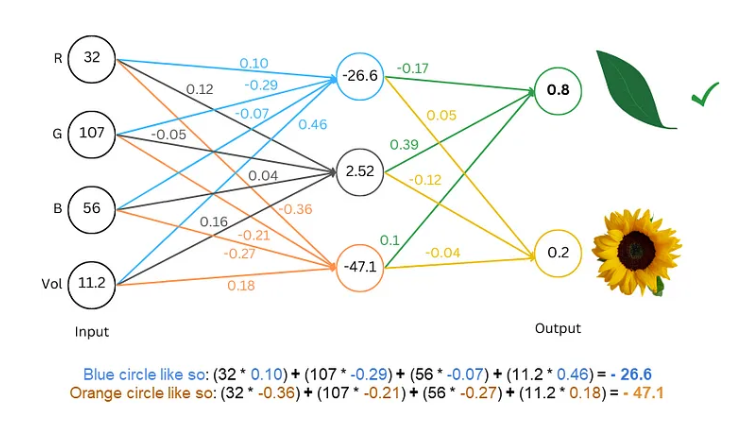

Em primeiro lugar, precisamos saber que uma rede neural é como um supercomputador, ela só consegue processar números. Tanto a entrada quanto a saída devem ser números. Então, como podemos fazer com que ele entenda o texto?

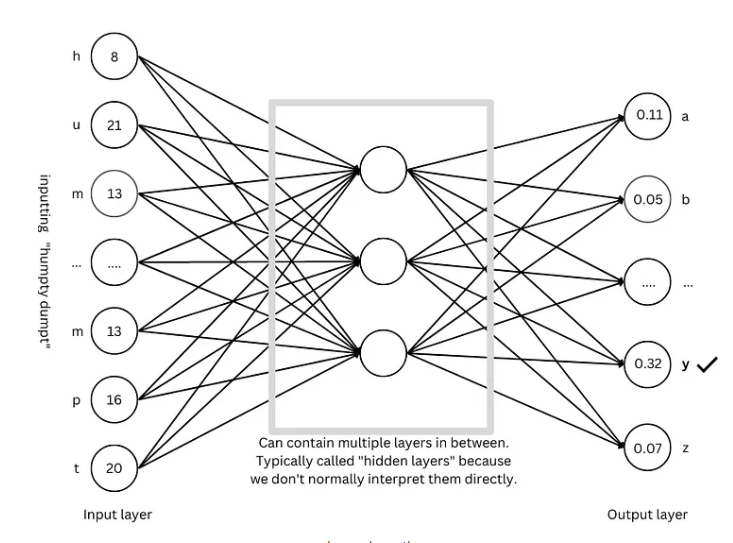

O segredo é converter palavras em números. Por exemplo, podemos representar cada letra com um número, como a=1, b=2 e assim por diante. Desta forma, a rede neural pode “ler” o texto.

Treinando o modelo: deixe a rede “aprender” a linguagem

Com o texto digitalizado, o próximo passo é treinar o modelo e deixar a rede neural “aprender” as leis da linguagem.

O processo de treinamento é como um jogo de adivinhação. Mostramos à rede algum texto, como “Humpty Dumpty”, e pedimos que ela adivinhe qual é a próxima letra. Se acertar, damos uma recompensa; se acertar, damos uma penalidade. Ao adivinhar e ajustar constantemente, a rede pode prever a próxima letra com precisão crescente, eventualmente produzindo frases completas como "Humpty Dumpty sentou na parede".

Técnicas avançadas: Torne o modelo mais “inteligente”

Para tornar o modelo mais “inteligente”, os pesquisadores inventaram muitas técnicas avançadas, como:

Incorporação de palavras: em vez de usar números simples para representar letras, usamos um conjunto de números (vetores) para representar cada palavra, o que pode descrever mais completamente o significado da palavra.

Segmentador de subpalavras: Divida palavras em unidades menores (subpalavras), como dividir "gatos" em "gato" e "s", o que pode reduzir o vocabulário e melhorar a eficiência.

Mecanismo de autoatenção: Quando o modelo prevê a próxima palavra, ele ajustará o peso da previsão com base em todas as palavras do contexto, assim como entendemos o significado da palavra com base no contexto durante a leitura.

Conexão residual: Para evitar dificuldades de treinamento causadas por muitas camadas de rede, os pesquisadores inventaram a conexão residual para facilitar o aprendizado da rede.

Mecanismo de atenção multicabeças: Ao executar vários mecanismos de atenção em paralelo, o modelo pode compreender o contexto de diferentes perspectivas e melhorar a precisão das previsões.

Codificação posicional: para que o modelo compreenda a ordem das palavras, os pesquisadores adicionarão informações posicionais aos embeddings de palavras, assim como prestamos atenção à ordem das palavras durante a leitura.

Arquitetura GPT: o “modelo” para modelos de linguagem em larga escala

A arquitetura GPT é atualmente uma das arquiteturas de modelos de linguagem de grande escala mais populares. É como um "projeto" que orienta o design e o treinamento do modelo. A arquitetura GPT combina de forma inteligente as técnicas avançadas mencionadas acima para permitir que o modelo aprenda e gere linguagem de forma eficiente.

Arquitetura do Transformer: A “revolução” dos modelos de linguagem

A arquitetura do Transformer é um grande avanço no campo dos modelos de linguagem nos últimos anos. Ela não apenas melhora a precisão da previsão, mas também reduz a dificuldade de treinamento, estabelecendo as bases para o desenvolvimento de modelos de linguagem em larga escala. A arquitetura GPT também evoluiu com base na arquitetura Transformer.

Referência: https://towardsdatascience.com/understanding-llms-from-scratch-using-middle-school-math-e602d27ec876

Através da explicação deste artigo, acredito que você já tenha uma compreensão preliminar dos modelos de linguagem em larga escala. Embora o mecanismo interno do LLM seja muito complexo, seus princípios básicos não são misteriosos. Espero que este artigo possa ajudá-lo a compreender melhor essa tecnologia incrível.