A tecnologia de animação de imagens orientada por áudio tem feito progressos significativos nos últimos anos, mas os problemas de complexidade e eficiência dos modelos existentes limitam a sua aplicação. Para resolver esses problemas, os pesquisadores desenvolveram uma nova tecnologia chamada JoyVASA, que melhora significativamente a qualidade, a eficiência e o escopo de aplicação da animação de imagens orientada por áudio por meio de um design inovador de dois estágios. JoyVASA não só é capaz de gerar vídeos animados mais longos, mas também anima retratos humanos e rostos de animais e oferece suporte a vários idiomas.

Recentemente, pesquisadores propuseram uma nova tecnologia chamada JoyVASA, que visa melhorar os efeitos de animação de imagens baseados em áudio. Com o desenvolvimento contínuo de modelos de aprendizagem profunda e difusão, a animação de retratos baseada em áudio fez um progresso significativo na qualidade do vídeo e na precisão da sincronização labial. No entanto, a complexidade dos modelos existentes aumenta a eficiência do treinamento e da inferência, ao mesmo tempo que limita a duração e a continuidade entre quadros dos vídeos.

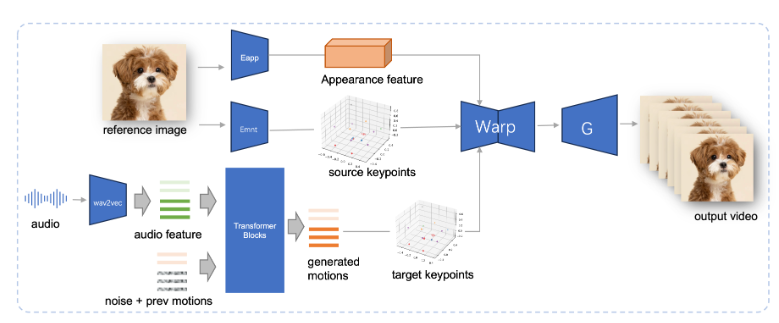

JoyVASA adota um design de dois estágios. O primeiro estágio introduz uma estrutura de representação facial desacoplada para separar expressões faciais dinâmicas de representações faciais tridimensionais estáticas.

Essa separação permite que o sistema combine qualquer modelo facial 3D estático com sequências de ação dinâmicas para gerar vídeos animados mais longos. Na segunda etapa, a equipe de pesquisa treinou um transformador de difusão que pode gerar sequências de ação diretamente a partir de sinais de áudio, processo independente da identidade do personagem. Finalmente, o gerador baseado no treinamento do primeiro estágio utiliza a representação facial 3D e a sequência de ação gerada como entrada para renderizar efeitos de animação de alta qualidade.

Notavelmente, JoyVASA não se limita à animação de retratos humanos, mas também pode animar rostos de animais perfeitamente. Este modelo é treinado em um conjunto de dados misto, combinando dados privados em chinês e dados públicos em inglês, mostrando boas capacidades de suporte multilíngue. Os resultados experimentais comprovam a eficácia deste método. Pesquisas futuras se concentrarão na melhoria do desempenho em tempo real e no refinamento do controle de expressão para expandir ainda mais a aplicação desta estrutura na animação de imagens.

O surgimento do JoyVASA marca um avanço importante na tecnologia de animação baseada em áudio, promovendo novas possibilidades no campo da animação.

Entrada do projeto: https://jdh-algo.github.io/JoyVASA/

Destaque:

A tecnologia JoyVASA permite a geração de vídeos animados mais longos, separando as expressões faciais dos modelos 3D.

Essa tecnologia pode gerar sequências de ação com base em sinais de áudio e possui a dupla capacidade de animação de personagens e animais.

JoyVASA é treinada em conjuntos de dados em chinês e inglês, tem suporte multilíngue e fornece serviços para usuários em todo o mundo.

A inovação da tecnologia JoyVASA reside no seu design desacoplado e no uso eficiente de sinais de áudio, que fornecem uma nova direção para o desenvolvimento futuro da tecnologia de animação de imagens orientada por áudio. Seu suporte multilíngue e recursos eficientes de geração de animação também o tornam um aplicativo amplamente utilizado. perspectivas. Espera-se que o JoyVASA possa melhorar ainda mais o desempenho em tempo real e alcançar um controle de expressão mais sofisticado no futuro.