A Meta AI abriu recentemente um modelo de linguagem multi -modo chamado Spirit LM. para um estado modal de voz O Spirit LM não pode apenas entender e gerar texto e voz, mas, mais importante, pode misturar os dois para alcançar várias funções, como reconhecimento de voz, síntese de voz e classificação de voz. versões de sua "versão básica" e "versão de expressão".

A Meta AI abriu recentemente o modelo básico de linguagem multi -modal chamado Spirit LM.

O Spirit LM é baseado em um modelo de linguagem de texto de pré -treinamento de 7 bilhões de parâmetros. Ele pode entender e gerar texto como um modelo de texto grande e também pode entender e gerar voz e até misturar o texto e a voz para criar uma variedade de efeitos mágicos! Para tomar, deixe -o ser convertido em texto;

O que é ainda mais poderoso é que o Spirit LM também é particularmente bom em "expressão emocional"! Você pode imaginar que a voz gerada pelo Spirit LM não é mais o tipo de som de máquina fria, mas como uma pessoa real, cheia de alegria e tristeza!

Para melhorar a IA "alto", os pesquisadores da Meta também desenvolveram duas versões do Spirit LM:

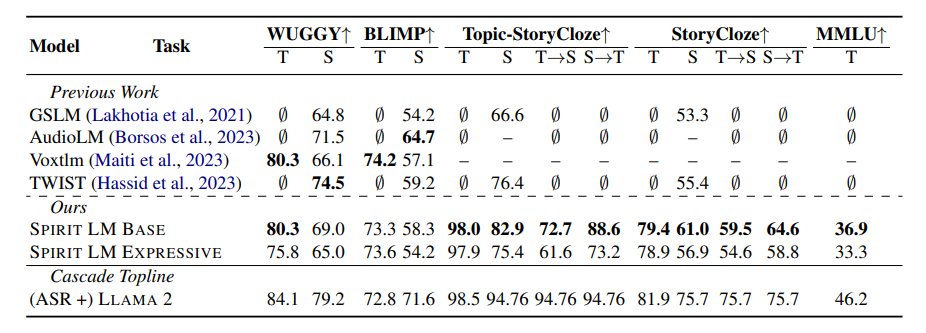

"Basic Edition": Esta versão se concentra principalmente nas informações de som fonéticas, ou seja, a "composição básica" da voz.

"Expressivo": Além das informações fonéticas, esta versão também adiciona informações de tom e estilo, que podem tornar a voz da IA mais vívida e expressiva.

Então, como o Spirit LM faz tudo isso?

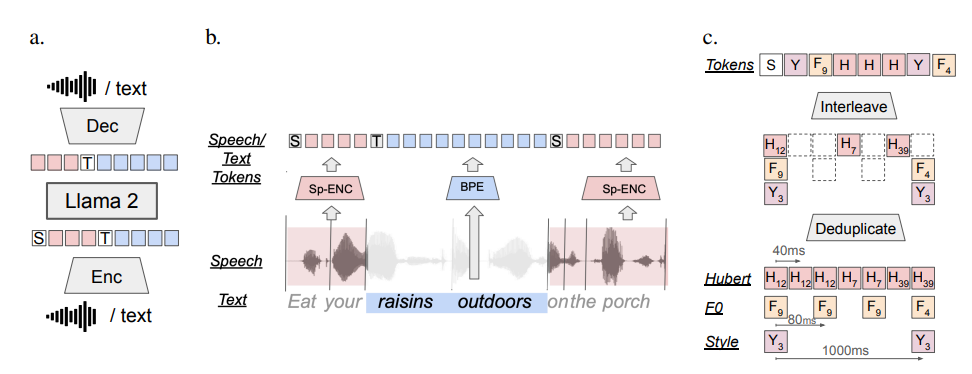

Em termos simples, o Spirit LM é treinado pelo LLAMA2 com base no modelo de texto super -forte lançado pela Meta antes. Os pesquisadores "alimentavam" uma grande quantidade de dados de texto e voz para o LLAMA2 e usaram um método especial de "treinamento escalonado" para permitir que o LLAMA2 aprendesse as leis do texto e da voz ao mesmo tempo.

Para testar a capacidade da "expressão emocional" do Spirit LM, os pesquisadores da Meta também criaram especificamente um novo benchmark de teste- "Benchmark de reserva emocional de texto por voz" (STSP). Esse benchmark de teste contém várias solicitações de voz e texto que expressam emoções diferentes para testar se o modelo de IA pode identificar e gerar com precisão a voz e o texto emocionais correspondentes. Os resultados mostram que a "versão de expressão" do Spirit LM teve um bom desempenho em termos de retenção emocional.

Obviamente, pesquisadores da Meta também admitiram que o Spirit LM ainda tem muitos lugares para melhorar. Por exemplo, o Spirit LM atualmente suporta o inglês e precisa ser estendido a outros idiomas no futuro; melhorar o desempenho do modelo.

Spirit LM é um grande avanço na meta no campo da IA. Acredito que, em um futuro próximo, veremos aplicativos mais interessantes com base no desenvolvimento da Spirit LM, para que a IA não apenas possa dizer que eles podem expressar emoções como pessoas reais e se comunicar de maneira mais natural e mais amigável conosco!

Endereço do projeto: https://speechbot.github.io/spiritlm/

Endereço da tese: https: //arxiv.org/pdf/2402.057555

Em suma, o código aberto do Spirit LM traz novas oportunidades para o desenvolvimento da AI de modo multi. Ansioso pela implementação do Spirit LM em mais cenários de idiomas e aplicativos no futuro.