O Alibaba Cloud lançou o recém-atualizado modelo de idioma de grande linguagem QWEN2.5-TURBO. Isso representa um grande salto para recursos de processamento de texto longo. Esse modelo é excelente em vários testes de referência, especialmente em termos de entendimento de texto longo, e excede o GPT-4 e, ao manter a precisão do processamento de texto curto, alcançou alta velocidade de raciocínio e custo extremamente baixo.

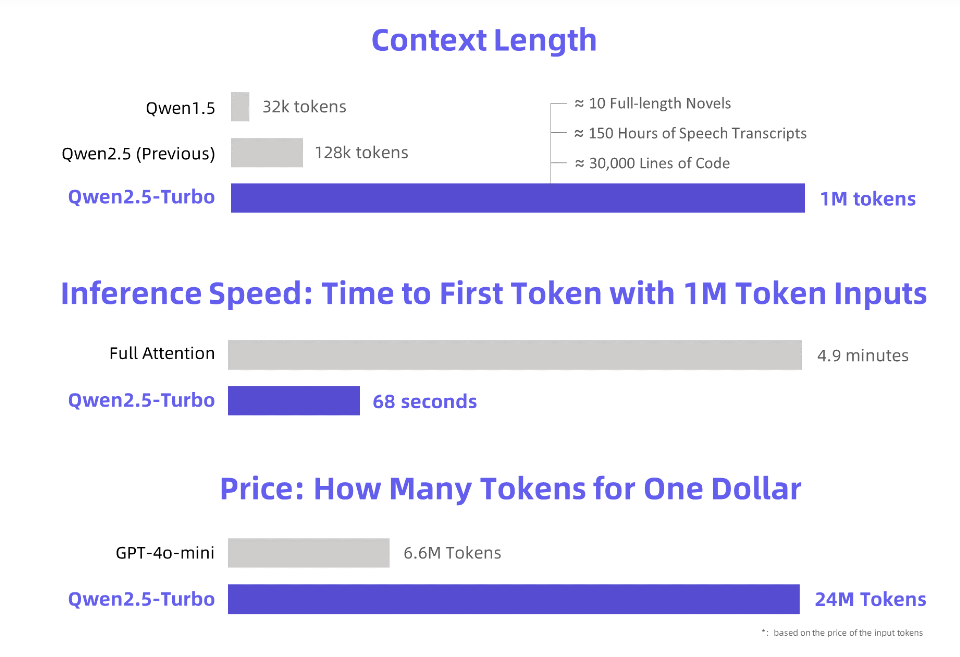

A Alibaba Cloud lançou o recém-atualizado modelo de linguagem QWEN2.5-TURBO GRANDE, e seu comprimento contextual excede o incrível token de 1 milhão. O que é equivalente a esse conceito?

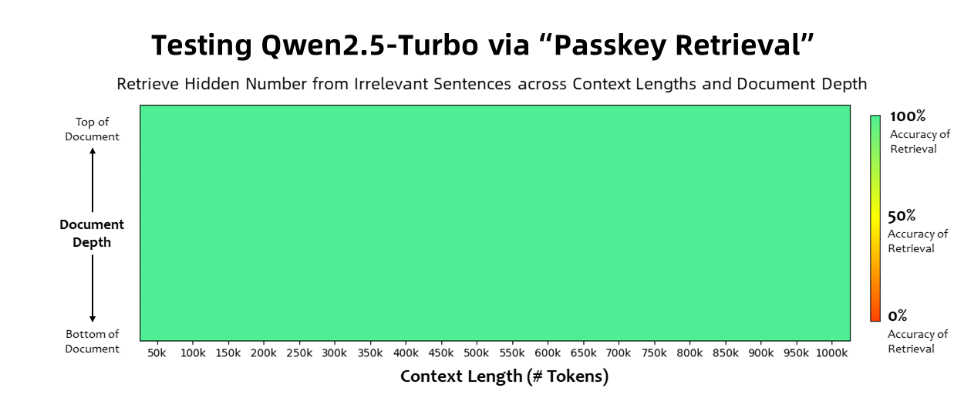

O modelo QWEN2.5-TURBO alcançou 100%de precisão na tarefa de recuperação da Passkey e supera os modelos iguais do GPT-4 em termos de recursos de entendimento de texto longo. Este modelo obteve 93,1 no teste de referência de texto longo do governante, enquanto a pontuação do GPT-4 é de apenas 91,6 e a pontuação do GLM4-9B-1M é 89,9.

Além dos recursos de processamento de texto longo, o QWEN2.5-TURBO também tem a precisão do processamento de texto curto.

Ao adotar um mecanismo de atenção escasso, o modelo QWEN2.5-TURBO processará 1 milhão de token o primeiro tempo de token de 4,9 minutos para 68 segundos, alcançando uma melhoria da velocidade de raciocínio de 4,3 vezes.

Ao mesmo tempo, o custo do processamento de 1 milhão de token é de apenas 0,3 yuan.

A Alibaba Cloud preparou uma série de demonstrações para o modelo QWEN2.5-TURBO, mostrando seus aplicativos como uma compreensão profunda de romances longos, assistência de código e vários artigos. Por exemplo, depois que o usuário enviou um romance chinês de três corpos contendo 690.000 tokens, o modelo resumiu com sucesso o enredo de cada romance em inglês.

Os usuários podem experimentar os poderosos recursos do modelo QWEN2.5-TURBO através do serviço API do Alibaba Cloud Model Studio, da demonstração do HuggingFace ou da demonstração do ModelCope.

Alibaba Cloud disse que, no futuro, continuará otimizando o modelo, melhorará suas preferências humanas em tarefas de sequência longa, otimizará ainda mais a eficiência do raciocínio, reduzirá o tempo de cálculo e tentará lançar um modelo de console de longo prazo mais forte e mais forte .

Introdução oficial: https://qwenlm.github.io/blog/qwen2.5-turbo/

Demonstração on-line: https://huggingface.co/spaces/qwen/qwen2.5-turbo-1m-demo

Documento da API: https://help.aliyun.com/zh/model-studio/getting-started/first-di-call-qwen

O QWEN2.5-TURBO abriu novas possibilidades para a aplicação de grandes modelos de idiomas com sua forte capacidade de processamento de texto longo e baixo custo, e vale a pena esperar no futuro. Para mais informações, visite o link fornecido.