Reduzir o custo do treinamento de grandes modelos é um foco de pesquisa atual no campo da inteligência artificial. A recente pesquisa divulgada pela equipe Tencent Hunyuan discute profundamente as regras de escala do treinamento de quantização de ponto flutuante de baixo bit, fornecendo novas ideias para o treinamento eficiente de grandes modelos. Através de um grande número de experimentos, este estudo analisou o impacto de fatores como tamanho do modelo, volume de dados de treinamento e precisão de quantificação no efeito de treinamento e, finalmente, criou regras sobre como alocar efetivamente recursos de treinamento sob diferentes precisões para obter o melhores resultados. Esta pesquisa não só tem um significado teórico importante, mas também fornece orientações valiosas para a aplicação prática de grandes modelos.

Hoje, com o rápido desenvolvimento do Large Language Model (LLM), o custo do treinamento e da inferência do modelo tornou-se cada vez mais o foco da pesquisa e aplicação. Recentemente, a equipe Tencent Hunyuan divulgou um importante estudo, que explorou profundamente as "Leis de Escala" do treinamento de quantização de ponto flutuante de baixo bit, ou seja, a lei de escala do treinamento de quantização de ponto flutuante. O núcleo desta pesquisa é explorar como reduzir significativamente os custos de computação e armazenamento sem perder desempenho, reduzindo a precisão do modelo.

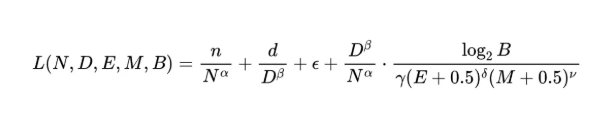

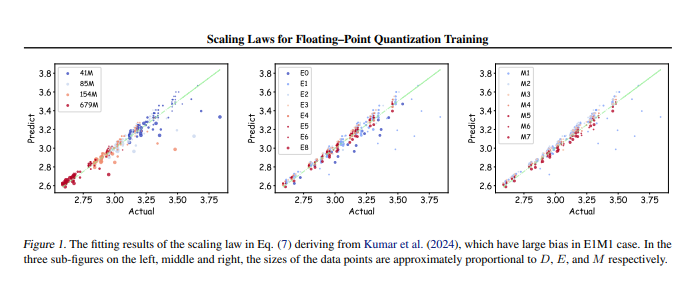

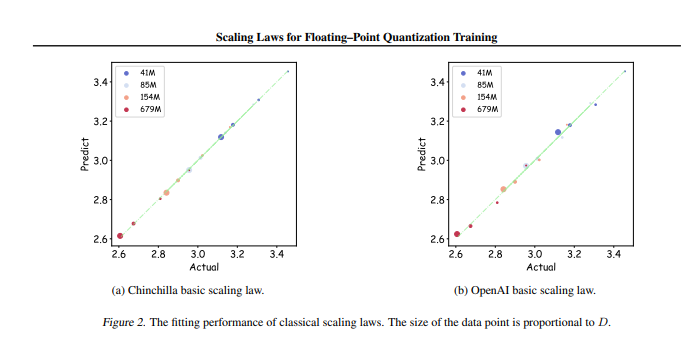

A equipe de pesquisa conduziu até 366 conjuntos de treinamento quantitativo de ponto flutuante com diferentes tamanhos de parâmetros e precisões, e analisou sistematicamente vários fatores que afetam o efeito de treinamento, incluindo tamanho do modelo (N), volume de dados de treinamento (D), bit exponencial (E ), bits Mantissa (M) e granularidade de quantização (B). Por meio desses experimentos, os pesquisadores derivaram um conjunto unificado de Leis de Escala, que revelou como configurar efetivamente os dados de treinamento e os parâmetros do modelo sob diferentes precisão para obter o melhor efeito de treinamento.

O mais crítico é que a pesquisa aponta que no treinamento arbitrário de quantificação de ponto flutuante de baixa precisão, há um “efeito limite”, ou seja, sob uma quantidade específica de dados, o desempenho do modelo atingirá o ideal, e excedendo esta quantidade de dados pode causar efeitos de declínio. Além disso, o estudo também descobriu que a precisão do treinamento de quantificação de ponto flutuante com melhor custo-benefício, teoricamente, deveria estar entre 4 e 8 bits, o que tem um significado orientador importante para o desenvolvimento de um LLM eficiente.

Esta pesquisa não apenas preenche a lacuna no campo do treinamento em quantificação de ponto flutuante, mas também fornece uma referência para futuros fabricantes de hardware para ajudá-los a otimizar as capacidades de computação de ponto flutuante sob diferentes precisões. Em última análise, esta investigação fornece uma direcção clara para a prática de formação em grandes modelos, garantindo que efeitos de formação eficientes ainda podem ser alcançados mesmo com recursos limitados.

Endereço do artigo: https://arxiv.org/pdf/2501.02423

Em suma, esta pesquisa da equipe Tencent Hunyuan fornece uma solução eficaz para reduzir o custo do treinamento de modelos grandes. As regras de escala e a faixa de precisão ideal descobertas terão um impacto profundo no desenvolvimento e aplicação de modelos grandes no futuro. Este trabalho aponta a direção para o treinamento de grandes modelos de alto desempenho e baixo custo, que merece atenção e pesquisa aprofundada.