A equipe do Alibaba Cloud Tongyi lança um novo modelo de recompensa de processo de raciocínio matemático Qwen2.5-Math-PRM. Este modelo está disponível nos tamanhos 72B e 7B. Ele supera significativamente modelos de código aberto semelhantes em desempenho, especialmente na identificação de erros de raciocínio. Vale a pena notar que a versão 7B superou até mesmo o popular GPT-4o, demonstrando o progresso revolucionário do Alibaba Cloud no campo de pesquisa e desenvolvimento de modelos de inferência. Para avaliar o desempenho do modelo de forma mais abrangente, a equipe também abriu o código-fonte do primeiro padrão de avaliação de nível ProcessBench, que contém 3.400 questões matemáticas cobrindo a dificuldade da Olimpíada de Matemática e é marcado com processos de raciocínio detalhados por especialistas para garantir a cientificidade. e rigor da avaliação.

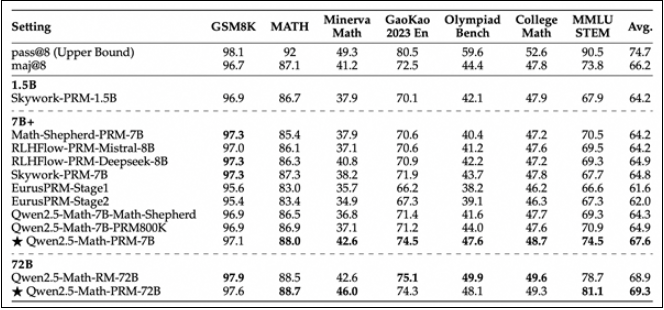

Hoje, a equipe Alibaba Cloud Tongyi lançou oficialmente um novo modelo de recompensa do processo de raciocínio matemático Qwen2.5-Math-PRM. O modelo está disponível em dois tamanhos: 72B e 7B, e seu desempenho é significativamente melhor do que modelos semelhantes de recompensa de processo de código aberto, especialmente na identificação de erros de inferência.

A versão 7B do Qwen2.5-Math-PRM superou surpreendentemente o popular GPT-4o da indústria. Esta conquista marca um passo importante para o Alibaba Cloud no desenvolvimento de modelos de inferência. A fim de avaliar de forma abrangente o desempenho do modelo no raciocínio matemático, a equipe Tongyi também abriu o código-fonte do primeiro padrão de avaliação em nível de etapa - ProcessBench. Este padrão de avaliação abrange 3.400 casos de teste de problemas matemáticos, incluindo questões difíceis da Competição Internacional das Olimpíadas de Matemática. Cada caso é marcado com um processo de raciocínio detalhado por especialistas humanos para garantir a cientificidade e abrangência da avaliação.

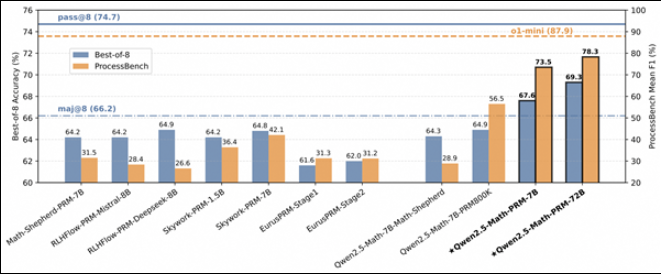

Ao avaliar o desempenho do Qwen2.5-Math-PRM no ProcessBench, a equipe de pesquisa descobriu que os modelos de tamanho 72B e 7B tiveram um bom desempenho. Principalmente a versão 7B, não só supera o modelo de código aberto do mesmo tamanho, mas até supera o GPT-4o-0806 de código fechado em alguns aspectos. Isto demonstra o grande potencial do modelo de recompensa de processo (PRM) na melhoria da confiabilidade da inferência e fornece novas idéias para o desenvolvimento de futuras tecnologias de supervisão de processos de inferência.

Este trabalho inovador da equipe Alibaba Cloud Tongyi não apenas promove o avanço da tecnologia de raciocínio de inteligência artificial, mas também fornece uma referência valiosa para outros desenvolvedores do setor. Através do código aberto, a equipe Tongyi espera compartilhar experiências com mais pesquisadores e promover o progresso tecnológico em toda a indústria.

O lançamento do Qwen2.5-Math-PRM marca um novo avanço para grandes modelos no campo do raciocínio matemático. Seu recurso de código aberto também oferece grande conveniência para pesquisa e aplicação na academia e na indústria. Mais possibilidades no desenvolvimento futuro da inteligência artificial.