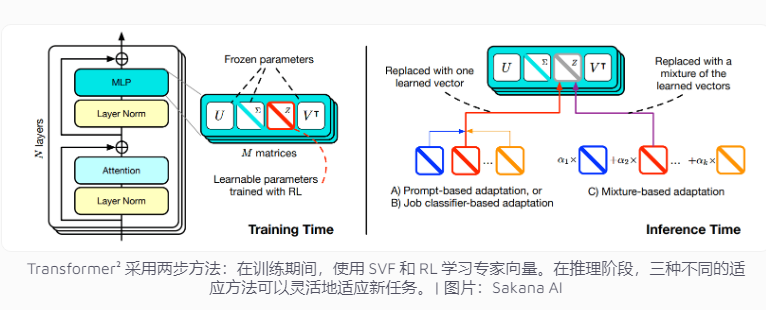

A empresa Sakana AI do Japão lançou recentemente Transformer², uma tecnologia inovadora que visa melhorar as tarefas de modelos de idiomas. Diferente do sistema de IA tradicional que precisa lidar com várias tarefas ao mesmo tempo, o Transformer² usa aprendizado de dois palcos para usar vetores especializados e a tecnologia Strange Value Fine -Tuning (SVF) para fazê -lo se adaptar com eficiência a novas tarefas sem retenção de todo o mundo Rede, mostrando que é aparente, mostrando que é aparente. Essa tecnologia se concentra em vetores de especialistas que controlam a importância da conexão de rede para se concentrar em tarefas específicas, como operações matemáticas, programação e raciocínio lógico, e combinado com o fortalecimento do aprendizado para otimizar ainda mais o desempenho do modelo.

O atual sistema de inteligência artificial geralmente precisa lidar com várias tarefas em um treinamento, mas eles são propensos a desafios acidentais ao enfrentar novas tarefas, resultando em restrições à adaptabilidade do modelo. O conceito de design de transformador 理 é voltado para esse problema.

Os métodos tradicionais de treinamento precisam ajustar o peso de toda a rede neural, e essa prática não é apenas altamente eficaz, mas também pode levar ao conhecimento aprendido antes do modelo "esquecido". Por outro lado, a tecnologia SVF evita esses problemas, aprendendo vetores especialistas que controlam a importância de cada conexão de rede. Os vetores especializados podem ajudar os modelos a se concentrar em tarefas específicas, ajustando a matriz de peso da conexão de rede, como computação matemática, programação e raciocínio lógico.

Esse método reduz significativamente o número de parâmetros necessários para que o modelo se adapte às novas tarefas. Por exemplo, o método Lora requer 6,82 milhões de parâmetros, enquanto o SVF precisa apenas de 160.000 parâmetros. Isso não apenas reduz o consumo de recursos de memória e processamento, mas também impede que o modelo esqueça outros conhecimentos ao se concentrar em uma determinada tarefa. O mais importante é que esses vetores de especialistas possam trabalhar efetivamente juntos para aprimorar a capacidade do modelo de se adaptar a diversas tarefas.

Para melhorar ainda mais a adaptabilidade, o Transformer² introduziu um aprendizado aprimorado. Durante o processo de treinamento, o modelo otimiza continuamente o vetor de especialistas, propondo uma solução de tarefas e obtendo feedback, aumentando assim o desempenho de novas tarefas. A equipe desenvolveu três estratégias para usar esses especialistas: adaptar -se a dicas, classificadores de tarefas e pequenas amostras adaptativas. Em particular, a estratégia adaptativa de pequenas amostras, analisando os exemplos das novas tarefas e ajustando o vetor de especialista, melhora ainda mais a flexibilidade e a precisão do modelo.

Em vários testes de benchmark, o Transformer² teve um desempenho mais do que o método tradicional Lora. Nas tarefas matemáticas, seu desempenho aumentou 16%e os parâmetros necessários foram bastante reduzidos. Diante de uma nova tarefa, a precisão do transformador² é 4%maior que o modelo original, enquanto Lora não conseguiu alcançar o efeito esperado.

O transformador 能 pode não apenas resolver problemas matemáticos complexos, mas também combinar recursos de programação e raciocínio lógico para obter compartilhamento de conhecimento cruzado. Por exemplo, a equipe descobre que modelos menores também podem transferir vetores especializados para melhorar o desempenho com o conhecimento de modelos maiores, que fornecem novas possibilidades para o compartilhamento de conhecimento entre os modelos.

Embora o Transformerr tenha feito um progresso significativo na adaptabilidade de tarefas, ele ainda enfrenta algumas restrições. Atualmente, vetores especializados que usam treinamento em SVF só podem contar com as habilidades existentes no modelo de pré -treinamento e não podem adicionar novas habilidades. O aprendizado contínuo real significa que o modelo pode aprender novas habilidades de forma independente, e esse objetivo ainda leva tempo para alcançar. Como expandir essa tecnologia em um grande modelo de mais de 70 bilhões de parâmetros ainda é um problema indizível.

Em suma, o Transformer² mostrou um enorme potencial no campo de aprendizado contínuo. No entanto, a tecnologia ainda precisa ser continuamente melhorada para superar as limitações existentes e alcançar verdadeiros objetivos de aprendizado contínuo.