A compreensão de vídeos longos sempre foi um grande desafio no campo da análise de vídeo. Os modelos tradicionais são ineficientes no processamento de vídeos longos e são difíceis de extrair informações importantes com eficácia. Este artigo apresenta uma tecnologia de compactação de marcação de vídeo hierárquica chamada HiCo e o sistema "VideoChat-Flash" baseado nesta tecnologia, que melhora significativamente a tarefa de "agulha no palheiro" por meio de aprendizado em vários estágios e recursos aprimorados de compreensão de vídeo longo e redução significativa requisitos de computação. A equipe de pesquisa construiu um grande conjunto de dados contendo 300 mil horas de vídeo e 200 milhões de palavras de anotações para treinamento e avaliação de modelos.

Especificamente, o HiCo reduz a complexidade computacional segmentando vídeos longos em segmentos curtos e compactando informações redundantes, ao mesmo tempo que aproveita associações semânticas com consultas de usuários para reduzir ainda mais o número de tags processadas. "VideoChat-Flash" adota um esquema de aprendizagem em vários estágios, primeiro usando vídeos curtos para ajuste fino supervisionado e, em seguida, introduzindo gradualmente treinamento em vídeo longo e, finalmente, alcançando uma compreensão abrangente do corpus de duração mista. Além disso, a tarefa aprimorada de “agulha no palheiro” melhora a compreensão do modelo sobre o contexto e as configurações de vídeo multi-hop.

Na implementação específica de processamento de vídeo longo, o "VideoChat-Flash" adota um esquema de aprendizagem em vários estágios, desde vídeos curtos até vídeos longos. Os pesquisadores primeiro usaram vídeos curtos e suas anotações correspondentes para ajuste fino supervisionado e, em seguida, introduziram gradualmente vídeos longos para treinamento, alcançando finalmente uma compreensão abrangente do corpus de duração mista. Este método não apenas melhora as capacidades de percepção visual do modelo, mas também fornece suporte de dados rico para processamento de vídeo longo. A equipe de pesquisa construiu um enorme conjunto de dados contendo 300.000 horas de vídeo e 200 milhões de palavras de anotações.

Além disso, uma tarefa aprimorada de "agulha no palheiro" é proposta no estudo para configurações de vídeo multi-hop. Com o novo benchmark, o modelo não só precisa encontrar uma única imagem alvo no vídeo, mas também compreender múltiplas sequências de imagens inter-relacionadas, melhorando assim a capacidade do modelo de compreender o contexto.

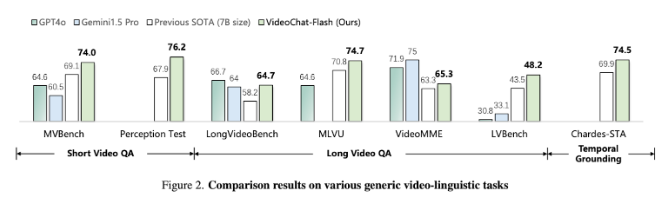

Os resultados experimentais mostram que o método proposto reduz a computação em duas ordens de grandeza, especialmente tem um bom desempenho em testes de benchmark de vídeos curtos e longos, tornando-se líder no novo campo de compreensão de vídeos curtos. Ao mesmo tempo, este modelo também supera os modelos de código aberto existentes na compreensão de vídeos longos, mostrando fortes capacidades de posicionamento no tempo.

Artigo: https://arxiv.org/abs/2501.00574

Destaque:

Os pesquisadores propuseram a tecnologia hierárquica de compressão de tags de vídeo HiCo, que reduz significativamente os requisitos computacionais para processamento de vídeo longo.

O sistema "VideoChat-Flash" adota um método de aprendizagem em vários estágios e combina vídeos curtos e longos para treinamento, o que melhora a capacidade de compreensão do modelo.

Resultados experimentais mostram que este método atinge novos padrões de desempenho em vários testes de benchmark e se torna um modelo avançado na área de processamento de vídeo longo.

Em suma, esta pesquisa fornece uma nova solução para a compreensão eficiente de vídeos longos. A tecnologia HiCo e o sistema VideoChat-Flash alcançaram avanços significativos na eficiência computacional e no desempenho do modelo, estabelecendo as bases para futuras aplicações de análise de vídeos longos. Os resultados da pesquisa têm importante significado teórico e valor de aplicação prática.