Codestral 25.01, o mais recente modelo de codificação de código aberto lançado pela Mistral, alcançou melhorias significativas no desempenho e é duas vezes mais rápido que a geração anterior. Como uma versão atualizada do Codestral, o Codestral 25.01 herda suas características de operação de baixa latência e alta frequência e é otimizado para aplicações de nível empresarial, suportando tarefas como correção de código, geração de testes e preenchimento intermediário. Seu excelente desempenho no teste de codificação Python, especialmente a alta pontuação de 86,6% no teste HumanEval, o torna líder entre os atuais modelos de codificação de peso pesado, superando muitos produtos similares.

Semelhante ao Codestral original, o Codestral 25.01 ainda se concentra em operações de baixa latência e alta frequência, suportando correção de código, geração de testes e tarefas de preenchimento intermediário. Mistral disse que esta versão é particularmente adequada para empresas que exigem mais dados e residência de modelo. Os testes de benchmark mostram que o Codestral25.01 tem um desempenho além das expectativas no teste de codificação Python, com uma pontuação no teste HumanEval de 86,6%, superando em muito a versão anterior, Codellama70B Instruct e DeepSeek Coder33B Instruct.

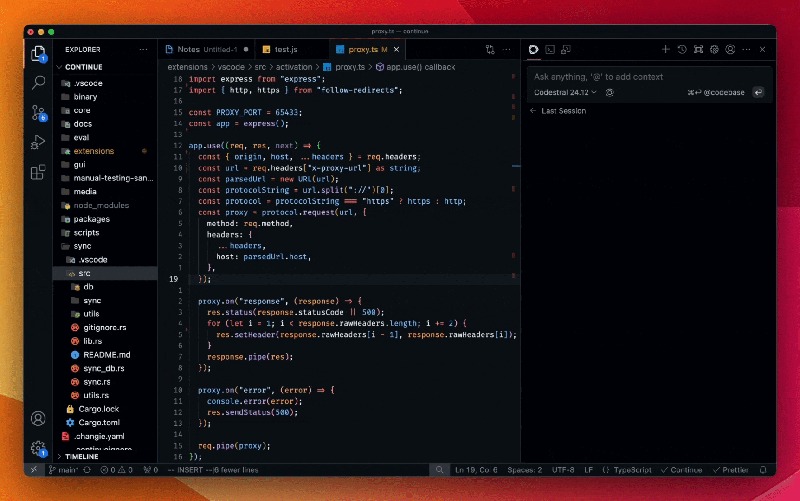

Os desenvolvedores podem acessar o modelo por meio do plug-in Mistral IDE, bem como da ferramenta de implantação local Continue. Além disso, o Mistral também fornece acesso à API por meio do Google Vertex AI e do Mistral la Plateforme. O modelo está atualmente disponível em versão prévia no Azure AI Foundry e em breve estará disponível na plataforma Amazon Bedrock.

Desde o seu lançamento no ano passado, Codestral by Mistral tornou-se líder no modelo de código aberto focado em código. Sua primeira versão do Codestral é um modelo de parâmetros de 22B que suporta até 80 idiomas e tem melhor desempenho de codificação do que muitos produtos similares. Imediatamente depois, a Mistral lançou o Codestral-Mamba, um modelo de geração de código baseado na arquitetura Mamba que pode lidar com cadeias de código mais longas e lidar com mais requisitos de entrada.

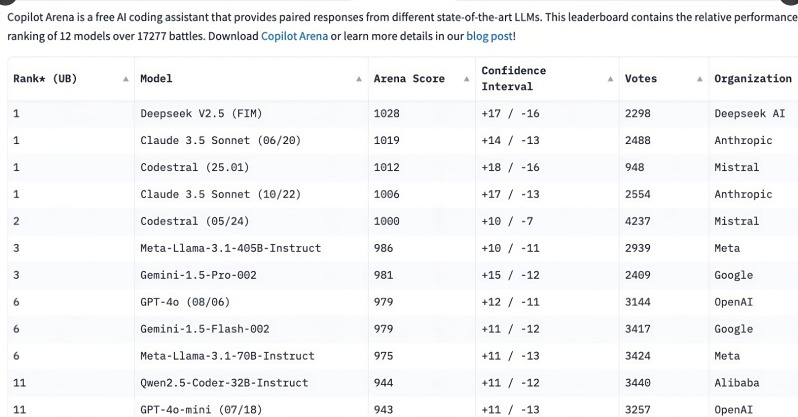

O lançamento do Codestral 25.01 atraiu grande atenção dos desenvolvedores, ficando no topo do ranking da C o pilot Arena apenas algumas horas após o lançamento. Esta tendência mostra que os modelos de codificação especializados estão rapidamente se tornando a primeira escolha para os desenvolvedores, especialmente no campo das tarefas de codificação. Em comparação com os modelos gerais multifuncionais, a necessidade de modelos de codificação focados é cada vez mais óbvia.

Embora modelos de uso geral como o3 da OpenAI e Claude da Anthropic também possam codificar, modelos de codificação especialmente otimizados tendem a ter melhor desempenho. No ano passado, várias empresas lançaram modelos dedicados para codificação, como o Qwen2.5-Coder da Alibaba e o DeepSeek Coder da China, este último tornando-se o primeiro modelo a superar o GPT-4Turbo. Além disso, a Microsoft também lançou o GRIN-MoE baseado no modelo misto de especialistas (MOE), que pode não apenas codificar, mas também resolver problemas matemáticos.

Embora os desenvolvedores ainda estejam debatendo se devem escolher modelos de uso geral ou modelos especializados, o rápido aumento dos modelos de codificação revelou uma enorme necessidade de ferramentas de codificação eficientes e precisas. Com a vantagem de ser especialmente treinado para tarefas de codificação, o Codestral25.01 ocupa sem dúvida um lugar no futuro da codificação.

O lançamento do Codestral25.01 marca mais um avanço no campo dos modelos de codificação profissional. Seu desempenho superior e acesso conveniente trarão aos desenvolvedores uma experiência de codificação mais eficiente e promoverão o desenvolvimento da inteligência artificial na área de desenvolvimento de software. No futuro, esperamos ver surgir mais modelos profissionais semelhantes para fornecer aos desenvolvedores mais opções.