A Sakana AI lança o inovador Modelo de linguagem adaptativa Transformer², que usa um mecanismo de ajuste dinâmico de peso dinâmico em duas etapas que aprende e adapta dinamicamente as novas tarefas durante o processo de inferência sem ajuste caro. Isso marca uma grande inovação na tecnologia de modelo de grande idioma (LLM) e deve mudar a maneira como o LLM é aplicado para torná -lo mais eficiente, personalizado e prático. Comparado com os métodos tradicionais de ajuste fino, o transformador² ajusta seletivamente os principais componentes dos pesos do modelo por meio de decomposição de valor singular (SVD) e técnicas de ajuste fino (SVF) de valor singular (SVF) para otimizar o desempenho em tempo real, evitando a reciclagem demorada. Os resultados dos testes mostram que o Transformer² é superior ao modelo LORA em várias tarefas, com menos parâmetros, e também demonstra fortes recursos de transferência de conhecimento.

A inovação central do transformador² está em seu mecanismo exclusivo de ajuste dinâmico de peso em duas etapas. Primeiro, ele analisa solicitações de usuário recebidas e entende os requisitos de tarefas; Ajustando seletivamente os componentes principais dos pesos do modelo, o Transformer² permite a otimização em tempo real do desempenho sem reciclagem demorada. Isso contrasta nítido com o método tradicional de ajuste fino, que exige manter os parâmetros estáticos após o treinamento ou usar métodos como adaptação de baixo rank (LORA) para modificar apenas um pequeno número de parâmetros.

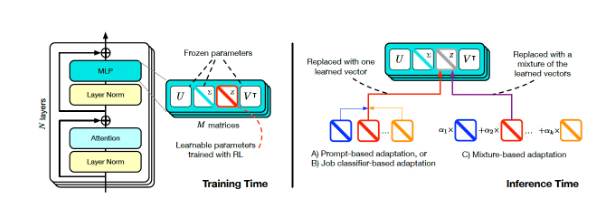

Treinamento e inferência do Transformer Square (Fonte: Arxiv)

Para alcançar o ajuste dinâmico, os pesquisadores adotaram o método de ajuste fino (SVF) de valor singular. Durante o treinamento, a SVF aprende um conjunto de representações de habilidade chamadas vetores z dos componentes SVD do modelo. Ao raciocinar, o Transformer² determina as habilidades necessárias analisando os prompts e configurando os vetores z correspondentes para obter uma resposta adaptada a cada prompt.

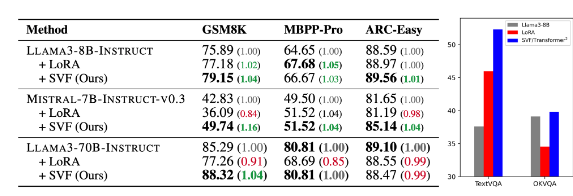

Os resultados dos testes mostram que o Transformer² é superior ao modelo LORA em várias tarefas, como matemática, codificação, raciocínio e resposta visual e resposta, e tem menos parâmetros. Mais notável é que o modelo também possui a capacidade de transferência de conhecimento, ou seja, os vetores z aprendidos de um modelo podem ser aplicados a outro, demonstrando assim o potencial de aplicação generalizada.

Comparação de Transformer-Squared (SVF na tabela) com o modelo subjacente e Lora (Fonte: Arxiv)

A Sakana AI lançou o código de treinamento para o componente Transformer² em sua página do Github, abrindo a porta para outros pesquisadores e desenvolvedores.

À medida que as empresas continuam a explorar a aplicação do LLM, a tecnologia de personalização de inferência está gradualmente se tornando a tendência convencional. O Transformer², juntamente com outras tecnologias, como os Titãs do Google, está mudando a maneira como o LLM está sendo usado, permitindo que os usuários ajustem dinamicamente os modelos às suas necessidades específicas sem reciclagem. Esse avanço tecnológico tornará o LLM mais útil e prático em uma ampla gama de áreas.

Pesquisadores da Sakana AI disse que o Transformer² representa uma ponte entre inteligência artificial estática e inteligência da vida, estabelecendo as bases para ferramentas de IA eficientes, personalizadas e totalmente integradas.

A liberação de código aberto do Transformer² promoverá bastante o desenvolvimento e a aplicação da tecnologia LLM e fornecerá uma nova direção para a construção de sistemas de inteligência artificial mais eficientes e personalizados. Sua capacidade de aprender dinamicamente e se adaptar a novas tarefas faz com que ele tenha um enorme potencial de aplicação em vários campos e vale a pena ansiar pelo desenvolvimento futuro.