O Instituto Allen de Inteligência Artificial (AI2) lançou recentemente um novo modelo de linguagem em larga escala Olmoe, um modelo de especialista em híbridos esparsos (MOE) com 7 bilhões de parâmetros, mas cada marca de entrada usa apenas 1 bilhão de parâmetros, o que reduz significativamente o número de inferência Custos e requisitos de memória. O OLMOE possui duas versões: a versão universal olmoe-1b-7b e a versão de ajuste fina de instrução olmoe-1b-7b-instruct, que executa nada menos que outros modelos grandes em benchmarks e até supera alguns modelos maiores. A AI2 enfatiza o código aberto completo de Olmoe, que é particularmente precioso no campo dos modelos MOE e fornece recursos valiosos para a pesquisa acadêmica.

O Olmoe adota uma arquitetura de especialista em híbridos esparsos (MOE) com 7 bilhões de parâmetros, mas apenas 1 bilhão de parâmetros são usados por tag de entrada. Ele vem em duas versões, o Olmoe-1B-7B mais geral e a instrução olmoe-1b-7b de instrução.

Ao contrário da maioria dos outros modelos de especialistas híbridos que são de código fechado, a AI2 enfatiza que o Olmoe é completamente de código aberto. Eles mencionaram no artigo que "a maioria dos modelos MOE é de código fechado: embora alguns divulguem pesos do modelo, há informações extremamente limitadas sobre seus dados de treinamento, código ou receitas".

O cientista de pesquisa da AI2, Nathan Lambert, disse nas mídias sociais que a Olmoe ajudará na elaboração de políticas, o que poderia fornecer um ponto de partida para o lançamento do cluster H100 na academia. Ele também mencionou que o lançamento do modelo Olmoe faz parte do objetivo da AI2 de desenvolver modelos de código aberto e tornar seu desempenho comparável aos modelos fechados.

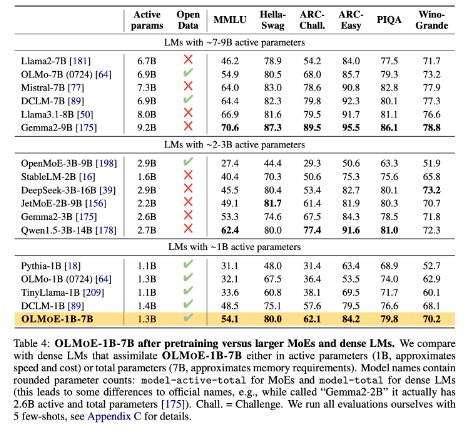

Em termos de construção de modelos, a AI2 decidiu usar 64 pequenos especialistas para roteamento fino e ativar apenas oito deles em tempo de execução. As experiências mostram que o Olmoe é comparável a outros modelos de desempenho, mas é significativamente reduzido no custo de inferência e no armazenamento de memória. O OLMOE também se baseia no modelo de código aberto olmo1.7-7b antes do AI2, suportando Windows de contexto com tag 4096. Os dados de treinamento da Olmoe vem de várias fontes, incluindo rastreamento comum, Dolma CC, Wikipedia, etc.

No benchmark, o OLMOE-1B-7B supera muitos modelos existentes quando comparado com modelos com parâmetros semelhantes e até supera modelos maiores, como LLAMA2-13B-CAT e Deepseekmoe-16b.

Um dos objetivos da AI2 é fornecer aos pesquisadores modelos de IA de código aberto mais totalmente aberto, incluindo arquiteturas especialistas híbridas. Embora muitos desenvolvedores usem a arquitetura MOE, a AI2 acredita que a maioria dos outros modelos de IA está longe de ser aberta o suficiente.

Huggingface: https://huggingface.co/collections/allenai/olmoe-66cf678c047657a30c8cd3da

Entrada de papel: https://arxiv.org/abs/2409.02060

Pontos -chave:

- O novo modelo de código aberto OLMOE lançado pela AI2 é competitivo em termos de desempenho e custo.

- Olmoe adota uma arquitetura de especialistas híbridos esparsos que pode efetivamente reduzir os custos de inferência e os requisitos de memória.

- A AI2 está comprometida em fornecer um modelo de IA de código aberto totalmente que promove pesquisas e desenvolvimento acadêmico.

Em suma, a liberação de código aberto do Olmoe é um grande avanço no campo de modelos de idiomas em larga escala. A mudança da AI2 reflete seu firme compromisso com o desenvolvimento da IA de código aberto e vale a pena ansiar por contribuições mais semelhantes no futuro.