Nos últimos anos, o custo de treinamento de grandes modelos de idiomas permaneceu alto, o que se tornou um fator importante que restringe o desenvolvimento da IA. Como reduzir os custos de treinamento e melhorar a eficiência tornou -se o foco da atenção da indústria. Pesquisadores da Universidade de Harvard e Stanford adotaram uma abordagem diferente e começaram com a precisão do treinamento modelo para explorar um método de treinamento econômico. Eles descobriram que, reduzindo a precisão do modelo, a quantidade de computação pode ser efetivamente reduzida e até melhorar o desempenho do modelo em alguns casos. Este estudo fornece novas idéias para otimizar o treinamento de modelos de idiomas e também aponta a direção para o desenvolvimento futuro da IA.

No campo da inteligência artificial, quanto maior a escala, mais forte a habilidade. Para buscar um modelo de idioma mais poderoso, as principais empresas de tecnologia estão empilhando os parâmetros do modelo e os dados de treinamento, mas descobrem que o custo também aumentou. Não existe uma maneira econômica e eficiente de treinar modelos de linguagem?

Pesquisadores da Harvard e Stanford University publicaram recentemente um artigo que descobriram que a precisão do treinamento de modelos é como uma chave oculta que desbloqueia a "senha de custo" do treinamento de modelos de idiomas.

O que é a precisão do modelo? Os modelos tradicionais de aprendizado profundo são geralmente treinados usando números de ponto flutuante de 32 bits (FP32), mas nos últimos anos, com o desenvolvimento de hardware, use tipos numéricos de precisão mais baixa, como números de ponto flutuante de 16 bits (FP16) ou 8 bits O treinamento inteiros (INT8) tornou -se possível.

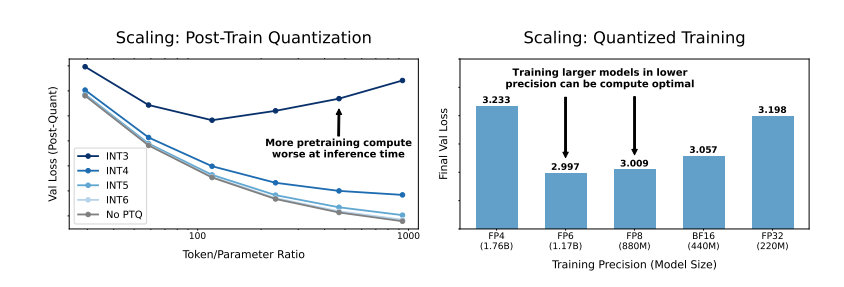

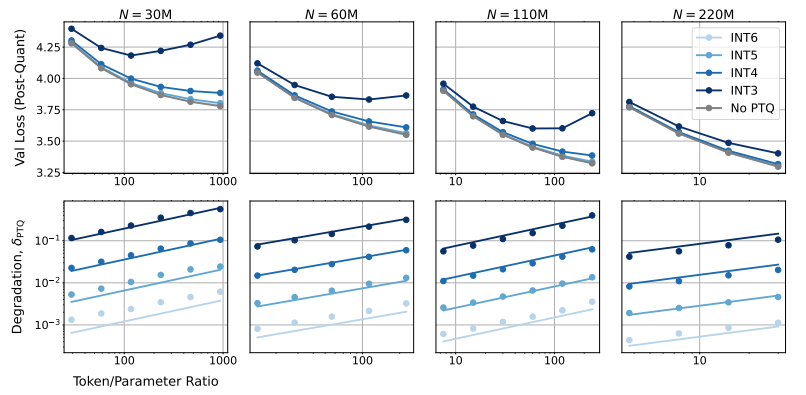

Então, que impacto reduzirá a precisão do modelo no desempenho do modelo? Esta é exatamente a questão que este artigo deseja explorar. Através de um grande número de experimentos, os pesquisadores analisaram as mudanças de custo e desempenho do treinamento e inferência de modelos em diferentes precisão e propuseram um novo conjunto de regras de escala de "percepção de precisão".

Eles descobriram que o treinamento com menor precisão pode reduzir efetivamente o "número de parâmetros eficazes" do modelo, reduzindo assim a quantidade de computação necessária para o treinamento. Isso significa que, sob o mesmo orçamento computacional, podemos treinar modelos maiores ou na mesma escala, usando menor precisão, pode economizar muitos recursos de computação.

Surpreendentemente, os pesquisadores também descobriram que, em alguns casos, o treinamento com menor precisão pode realmente melhorar o desempenho do modelo! Fase, o modelo será mais robusto para a redução na precisão da quantização, mostrando assim um melhor desempenho na fase de inferência.

Então, qual precisão devemos optar por treinar o modelo?

O treinamento tradicional de precisão de 16 bits pode não ser a melhor escolha. Sua pesquisa mostra que a precisão de 7 a 8 bits pode ser uma opção mais econômica.

Não é uma jogada sábia buscar o treinamento de precisão ultra baixa (como 4 bits). Como com uma precisão extremamente baixa, o número de parâmetros efetivos do modelo cairá acentuadamente, para manter o desempenho, precisamos aumentar significativamente o tamanho do modelo, o que levará a custos de computação mais altos.

A precisão ideal do treinamento pode variar para modelos de tamanhos diferentes. Para modelos que exigem muito "excesso de treinamento", como a série LLAMA-3 e GEMMA-2, o treinamento com maior precisão pode ser mais econômico.

Este estudo fornece uma perspectiva completamente nova para entendermos e otimizarmos o treinamento em modelos de idiomas. Ele nos diz que a escolha da precisão não é estática, mas precisa ser negociada com base no tamanho do modelo específico, no volume de dados de treinamento e nos cenários de aplicação.

Obviamente, este estudo também tem algumas limitações. Por exemplo, o modelo que eles usam é de tamanho relativamente pequeno e os resultados experimentais podem não ser diretamente generalizados para modelos maiores. Além disso, eles se concentraram apenas na função de perda do modelo e não avaliaram o desempenho do modelo em tarefas a jusante.

No entanto, este estudo é de grande significado. Ele revela a complexa relação entre a precisão do modelo e o desempenho do modelo e os custos de treinamento e fornece informações valiosas para projetar e treinar modelos de linguagem mais fortes e econômicos no futuro.

Papel: https://arxiv.org/pdf/2411.04330

Em resumo, este estudo fornece novas idéias e métodos para reduzir os custos de treinamento de grandes modelos de idiomas e fornece um importante valor de referência para o desenvolvimento futuro do campo de inteligência artificial. Embora existam algumas limitações na pesquisa, a regra de escala de "percepção de precisão" que propõe e a discussão aprofundada da relação entre precisão do modelo e custo e desempenho têm importante significado orientador teórico e prático.