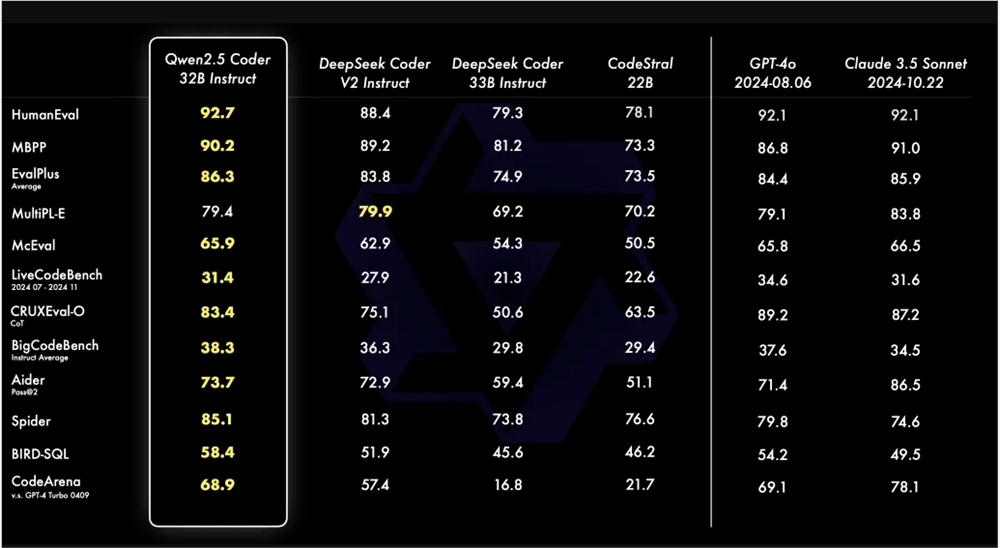

A equipe Tongyi Qianwen abriu sua mais recente série de modelos de código QWEN2.5, incluindo quatro tamanhos de modelos: 0,5b/3b/14b/32b, bem como duas versões de base e instrução. Esse movimento visa promover o desenvolvimento de modelos de código de código aberto e fornecer aos desenvolvedores mais opções. O modelo QWEN2.5-CODER-32B-INUTRUTA teve um desempenho excelentemente na geração de código, reparo e inferência, e atingiu os níveis de SOTA em vários benchmarks, que é comparável ao GPT-4O, especialmente em linguagens de programação, como Haskell e Racket . O modelo também foi testado pela Arena de Código de Código de Avaliação de Avaliação de Preferência de Código de Código, que prova sua vantagem no alinhamento de preferência humana.

O QWEN2.5-Coder suporta mais de 40 linguagens de programação e pontuam 65,9 pontos no MCEVAL e as pontuações 75.2 no benchmark MDeval, classificando-se primeiro. Sua limpeza e proporção de dados exclusivas no estágio de pré-treinamento é um dos principais fatores para seu excelente desempenho. O modelo de 0,5b/1,5b/7b/14b/32b é licenciado pelo Apache2.0 e o modelo 3B é licenciado apenas pela pesquisa. A equipe verificou a eficácia da escala no Code LLMS, avaliando o desempenho de diferentes modelos de tamanho. O código aberto do QWEN2.5-Coder promoverá, sem dúvida, o desenvolvimento e a aplicação da tecnologia do modelo de linguagem de programação.

O código aberto da série QWEN2.5-CODERS fornece aos desenvolvedores uma escolha de modelo de programação poderosa e fácil de usar, promovendo ainda mais o desenvolvimento da comunidade de código aberto. Modelos de tamanhos diferentes atendem a diferentes necessidades, enquanto as versões de base e instruções servem ao ajuste fino e aplicação direta do modelo, respectivamente. O link do modelo é fornecido e os desenvolvedores podem baixar e usá -lo e contribuir para a comunidade de código aberto.

Link do modelo QWEN2.5-Coder: https://modelscope.cn/collections/qwen25-coder-9d375446e8f5814a