A equipe do Shanghai AI Lab abriu a fonte da versão llama do projeto O1, que é um projeto de réplica de código aberto para a ferramenta de solução de problemas da OpenAi Olympiad. O projeto usa tecnologias avançadas, como a pesquisa de árvores de Monte Carlo e a aprendizagem de reforço para obter resultados notáveis na resposta às perguntas da Olimpíada Matemática, e seu desempenho ainda excede o de algumas soluções comerciais de código fechado. O código aberto do projeto fornece aos desenvolvedores que os valiosos recursos de aprendizagem e fundação de pesquisa e também promovem o desenvolvimento adicional da aplicação da inteligência artificial no campo da matemática. Este projeto inclui conjuntos de dados pré-treinados, modelos pré-treinados e códigos de treinamento de aprendizado de reforço, etc., e usa uma variedade de tecnologias de otimização, incluindo LORA e PPO, com o objetivo de melhorar a capacidade do modelo no raciocínio matemático.

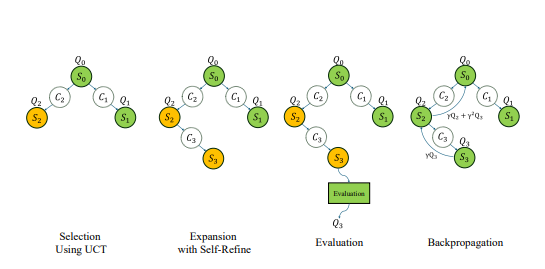

Recentemente, a equipe do Shanghai AI Lab lançou a versão llama do projeto O1, com o objetivo de replicar a ferramenta de solução de problemas da Olimpíada do OpenAI O1. O projeto adota uma variedade de tecnologias avançadas, incluindo busca de árvores de Monte Carlo, aprendizado de reforço de auto-jogo, PPO e paradigma de dupla estratégia do AlphaGo Zero, que atraiu a atenção generalizada da comunidade de desenvolvedores.

Muito antes do lançamento da série O1 do Openai, a equipe de Laboratório de Xangai AI começou a explorar o uso da pesquisa de Monte Carlo Tree para melhorar a capacidade matemática de grandes modelos. Após o lançamento do O1, a equipe atualizou ainda mais o algoritmo, concentrou -se no problema da Olimpíada de Matemática e o desenvolveu como uma versão de código aberto do projeto Strawberry Openai.

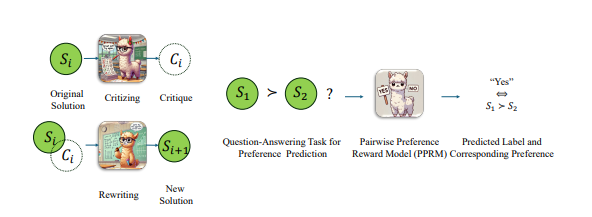

Para melhorar o desempenho do modelo de llama em problemas da Olimpíada Matemática, a equipe adotou uma estratégia de otimização emparelhada, ou seja, não é diretamente a pontuação absoluta da resposta, mas compare as vantagens e desvantagens relativas das duas respostas. Com essa abordagem, eles fizeram um progresso significativo nos benchmarks Aime2024 mais difíceis. Entre as 30 perguntas do teste, o modelo otimizado foi feito corretamente 8, enquanto o modelo original de instrução LLAMA-3.1-8B foi feito corretamente 2. Essa conquista supera outras soluções comerciais de código fechado, além da previsão O1 e O1-mini.

No final de outubro, a equipe anunciou um progresso significativo na replicação do OpenAI O1 com base na arquitetura do AlphaGo Zero, permitindo com sucesso o modelo obter capacidade de pensamento avançado através da interação com a árvore de pesquisa durante o processo de aprendizado sem anotação manual. Em menos de uma semana, o projeto foi aberto.

Atualmente, o conteúdo de código aberto da versão llama O1 inclui: conjuntos de dados pré-treinados, modelos pré-treinados e código de treinamento de aprendizado de reforço. Entre eles, o conjunto de dados "OpenLongCot-Pre-Prain" contém mais de 100.000 dados da cadeia de pensamento longos, cada dados contém um processo completo de raciocínio de problemas matemáticos, incluindo conteúdo de pensamento, resultados de pontuação, descrição do problema, coordenadas gráficas, processo de cálculo, dedução de conclusão e outros Links completos de inferência, bem como críticas e verificação de cada etapa de inferência, fornecem avaliação e orientação para o processo de inferência. Depois de continuar o pré-treinamento nesse conjunto de dados, o modelo pode ler e produzir processos de cadeia de pensamento longo, como O1.

Embora o projeto seja chamado LLAMA-O1, o modelo pré-treinado atualmente fornecido pelo funcionário é baseado no Gemma2 do Google. Com base no modelo pré-treinado, os desenvolvedores podem continuar realizando treinamento de aprendizado de reforço. O processo de treinamento inclui: Usando a Pesquisa de Tree Monte Carlo para gerar o auto-jogo para gerar experiência; Algumas tecnologias-chave também são usadas no código de treinamento, incluindo o uso do LORA para ajuste fino de parâmetros eficientes, usando o algoritmo PPO como método de otimização de estratégia, implementando o algoritmo GAE para calcular funções vantajosas e usar a reprodução de experiência prioritária para melhorar a eficiência do treinamento.

Vale a pena notar que o código LLAMA-O1 foi publicado sob a conta do GitHub chamada SimpleBerry. De outras contas relacionadas ao SimpleBerry e informações oficiais do site, só pode ser visto que sua natureza é um laboratório de pesquisa, mas não há mais informações sobre a direção da pesquisa.

Além do LLAMA-O1, outro projeto de réplica O1 de progresso público é o O1-Journey da equipe da Universidade de Xangai Jiaotong. A equipe divulgou seu primeiro relatório de progresso no início de outubro, introduzindo o inovador paradigma de aprendizado de jornada e o primeiro modelo para integrar com sucesso a pesquisa e a aprendizagem ao raciocínio matemático. A equipe de desenvolvimento principal da O1-Journey é composta principalmente por estudantes de graduação júnior e sênior da Universidade de Shanghai Jiaotong, bem como estudantes de doutorado do primeiro ano do Gair Laboratory (Laboratório de Pesquisa em Inteligência Artificial Geral). na Universidade de Xangai Jiaotong.

Endereço em papel: https://arxiv.org/pdf/2410.02884

https://arxiv.org/pdf/2406.07394

O código aberto do projeto LLAMA VERSÃO O1 marca o progresso importante no campo da solução de problemas de matemática da IA e também fornece uma base sólida para pesquisas e aplicações adicionais. Estamos ansiosos por realizações mais inovadoras com base neste projeto no futuro.