A Meta Fair, a UC Berkeley e as equipes de pesquisa da Universidade de Nova York colaboraram no desenvolvimento de uma nova tecnologia chamada Thinking Preference Optimization (TPO) para melhorar significativamente a conformidade com as instruções e a qualidade da resposta em grandes modelos de idiomas (LLM). Ao contrário dos LLMs tradicionais que fornecem respostas diretamente, a tecnologia TPO permite que os modelos pensem e reflitam internamente antes de responder, gerando respostas mais precisas e coerentes. Essa inovação orienta o modelo para otimizar seu processo de pensamento sem mostrar ao usuário as etapas intermediárias, melhorando a qualidade das respostas por meio de um método de raciocínio aprimorado de pensamento em cadeia (COT).

O núcleo da tecnologia TPO é o método de raciocínio de pensamento da cadeia aprimorado (COT). Essa abordagem incentiva os modelos a "pensar e responder" durante o treinamento, ajudando -os a construir um processo de pensamento interno mais organizado antes de fornecer a resposta final. Às vezes, as sugestões tradicionais de BOT podem levar a uma precisão reduzida e são bastante complicadas de treinar devido à falta de etapas de pensamento claras. E o TPO supera com sucesso esses desafios, permitindo que os modelos otimizem e simplifiquem seu processo de pensamento sem expor as etapas intermediárias aos usuários.

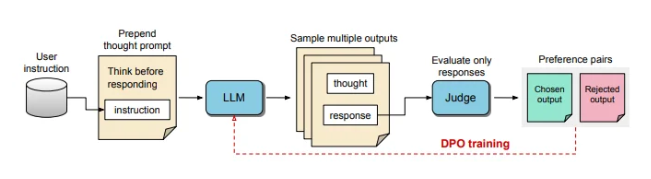

Durante o processo de treinamento do TPO, primeiro solicita o modelo de linguagem grande a gerar várias idéias e depois resolver a resposta final. Essas saídas são então avaliadas por um modelo "Judger" para escolher as respostas de melhor desempenho e com melhor desempenho. Esses resultados de avaliação são usados como pares de "escolha" e "rejeitar" para otimização de preferência direta (DPO) para melhorar continuamente a qualidade da resposta do modelo.

Ao ajustar as instruções de treinamento, a TPO incentiva o modelo a pensar internamente antes de responder. Esse processo orienta o modelo para otimizar suas respostas para torná -lo mais claro e relevante. Por fim, a avaliação é feita por um modelo de julgamento baseado em LLM que apenas obtém a resposta final, ajudando o modelo a melhorar a qualidade das respostas independentemente das etapas de pensamento oculto. O TPO também usa otimização de preferência direta para criar respostas preferidas e de rejeição que contêm pensamento oculto e, após várias rodadas de treinamento, refinam ainda mais o processo interno do modelo.

Em benchmarks para Alpacaeeval e Arena-Hard, o método TPO superou a linha de base da resposta tradicional e foi melhor que o modelo LLAMA-3-8B-instrume de "dicas de pensamento". O treinamento iterativo desse método otimiza os recursos de geração de pensamento, superando em última análise vários modelos de linha de base. Vale ressaltar que o TPO não é apenas adequado para tarefas lógicas e matemáticas, mas também faz grandes esforços em campos criativos, como instruções de marketing e saúde para seguir as tarefas.

A IA e o especialista em robótica, Karan Verma, compartilharam seus pontos de vista sobre o conceito de "Thinking LLM" na plataforma social X, dizendo que estava muito empolgado com isso e esperava o potencial dessa inovação em aplicativos médicos que podem trazer mais pacientes .

Esse processo de pensamento interno estruturado permite que o modelo processe instruções complexas de maneira mais eficaz, expandindo ainda mais sua aplicação em áreas que requerem raciocínio em vários níveis e entendimento meticuloso sem a necessidade de os seres humanos fornecerem dados de pensamento específicos. Este estudo mostra que o TPO tem o potencial de tornar grandes modelos de linguagem mais flexíveis e eficientes em diversos contextos, adequados para áreas onde existem altos requisitos para a flexibilidade e profundidade da geração de respostas.

Os avanços inovadores na tecnologia TPO trouxeram mais de inferência e compreensão de recursos de grandes modelos de idiomas, abrindo novas possibilidades para sua aplicação em vários campos, especialmente em tarefas que exigem processos de pensamento complexos.