A Meta AI, em conjunto com pesquisadores da Universidade da Califórnia, Berkeley e Universidade de Nova York, desenvolveu uma nova abordagem chamada Thinking Preference Optimization (TPO) que visa melhorar significativamente a qualidade da resposta de grandes modelos de idiomas (LLM). Ao contrário dos métodos tradicionais que se concentram apenas na resposta final, o TPO permite que o modelo pense internamente antes de gerar a resposta, resultando em uma resposta mais precisa e coerente. Esse método de raciocínio de cadeia de pensamento aprimorado da tecnologia (COT) supera as deficiências da baixa precisão e dificuldade do método do COT anterior em treinamento por meio de otimização e otimização do processo de pensamento interno do modelo e, finalmente, gera respostas de maior qualidade e de várias maneiras cada teste de referência.

Ao contrário dos modelos tradicionais que se concentram apenas na resposta final, o método TPO permite que o modelo pense internamente antes de gerar uma resposta, resultando em respostas mais precisas e coerentes.

Essa nova tecnologia combina um método de raciocínio aprimorado da cadeia de pensamento (COT). Durante o processo de treinamento, o método incentiva o modelo a "pensar" antes de responder, ajudando -o a criar um processo de pensamento interno mais sistemático. Os avisos anteriores do COT direto às vezes reduzem a precisão, e o processo de treinamento é difícil devido à falta de etapas de pensamento claro. O TPO supera essas limitações, permitindo que o modelo otimize e simplifique seu processo de pensamento e não mostra etapas de pensamento intermediário na frente do usuário.

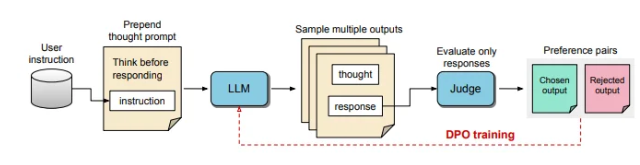

No processo de TPO, os grandes modelos de linguagem são solicitados a gerar vários processos de pensamento e, em seguida, essas saídas são amostradas e avaliadas antes de formar a resposta final. Um modelo de avaliação marcará a saída para determinar as respostas ideais e piores. Ao usar essas saídas como escolha e rejeição para otimização de preferência direta (DPO), esse método de treinamento iterativo aprimora a capacidade do modelo de gerar respostas mais relevantes e de alta qualidade, melhorando assim os resultados gerais.

Nesse método, os avisos de treinamento são ajustados, incentivando o modelo a pensar internamente antes de responder. A resposta final avaliada é pontuada por um modelo de avaliação baseado em LLM, que permite ao modelo melhorar a qualidade baseada apenas na eficácia da resposta sem considerar as etapas de pensamento implícitas. Além disso, o TPO usa otimização de preferência direta para criar respostas de preferência e rejeição que contêm pensamento implícito e refine ainda mais o processo interno do modelo através de vários ciclos de treinamento.

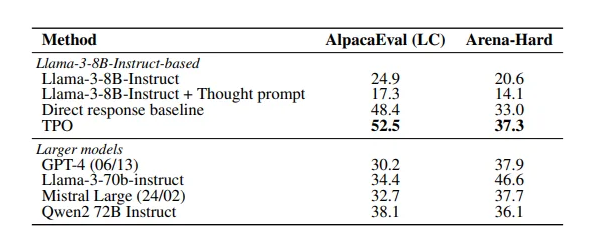

Os resultados do estudo mostram que o método TPO teve um bom desempenho em vários benchmarks, superando uma variedade de modelos existentes. Essa abordagem não apenas se aplica a tarefas lógicas e matemáticas, mas também mostra potencial em áreas criativas, como tarefas de acompanhamento de comando de marketing e saúde.

Papel: https://arxiv.org/pdf/2410.10630

Pontos -chave:

A tecnologia TPO melhora a capacidade de pensar de grandes modelos de linguagem antes de gerar respostas, garantindo que as respostas sejam mais precisas.

Através do raciocínio aprimorado da cadeia de pensamento, o modelo pode otimizar e otimizar seu processo de pensamento interno e melhorar a qualidade da resposta.

O TPO é adequado para uma variedade de campos, não apenas para tarefas lógicas e matemáticas, mas também para criativo e saúde.

Em suma, o método TPO fornece uma nova idéia para a melhoria de desempenho de grandes modelos de idiomas. Os links em papel são convenientes para os leitores obter informações sobre seus detalhes técnicos e resultados experimentais.