A OpenAI lançou um novo benchmark SimpleQA, com o objetivo de avaliar a precisão factual de grandes modelos de idiomas gerados. Com o rápido desenvolvimento da tecnologia de IA, garantir que a autenticidade da saída do modelo seja crucial e o fenômeno da "ilusão" - a geração de modelos de informações aparentemente credíveis, mas realmente erradas - se tornará um desafio cada vez mais grave. O surgimento do SimpleQA fornece novas maneiras e padrões para resolver esse problema.

Recentemente, o OpenAI lançou um novo benchmark chamado SimpleQA para avaliar a precisão factual dos modelos de idiomas gerou respostas.

Com o rápido desenvolvimento de grandes modelos de idiomas, garantir a precisão do conteúdo gerado enfrenta muitos desafios, especialmente os chamados fenômenos de "ilusão", onde o modelo gera informações que parecem confiantes, mas que são realmente erradas ou inviabilizáveis. Essa situação se tornou particularmente importante no contexto de mais e mais pessoas que dependem da IA para obter informações.

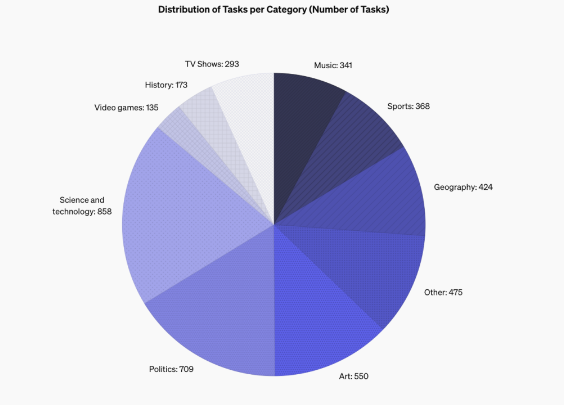

Os recursos de design da SimpleQA é que ele se concentra em perguntas curtas e claras que geralmente têm uma resposta sólida, para que possa ser mais fácil avaliar se a resposta do modelo está correta. Ao contrário de outros benchmarks, os problemas do SimpleQA são cuidadosamente projetados para permitir que modelos de ponta como o GPT-4 enfrentem desafios. Este benchmark contém 4326 perguntas, cobrindo vários campos, como história, ciência, tecnologia, arte e entretenimento, com ênfase especial na avaliação dos recursos de precisão e calibração do modelo.

O design do SimpleQA segue alguns princípios -chave. Primeiro, cada pergunta tem uma resposta de referência determinada por dois treinadores independentes de IA, garantindo a correção da resposta.

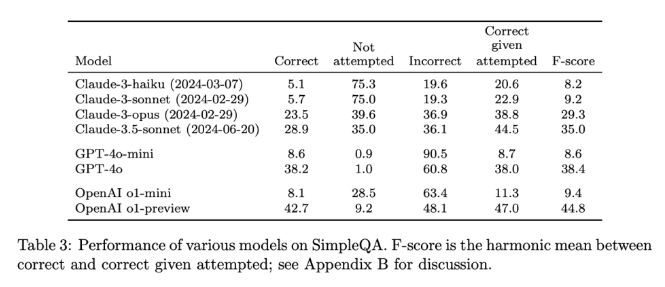

Em segundo lugar, a configuração da pergunta evita a ambiguidade e cada pergunta pode ser respondida com uma resposta simples e clara, para que as classificações se tornem relativamente fáceis. Além disso, o SimpleQA usa o classificador ChatGPT para classificação, marcando explicitamente a resposta como "correta", "erro" ou "não tentado".

Outra vantagem do SimpleQA é que ela abrange diversas questões, impede a super-especialização dos modelos e garante uma avaliação abrangente. Esse conjunto de dados é simples de usar porque as perguntas e respostas são curtas, tornando o teste rápido e os resultados mudam pouco. Além disso, o SimpleQA também considera a correlação de informações a longo prazo, evitando assim o impacto causado por mudanças nas informações, tornando-o um benchmark "sempre-verde".

A liberação do SimpleQA é uma etapa importante para promover a confiabilidade das informações geradas pela IA. Ele não apenas fornece uma referência fácil de usar, mas também define um alto padrão para pesquisadores e desenvolvedores, incentivando-os a criar modelos que não apenas geram linguagem, mas também são autênticos e precisos. Através de código aberto, o SimpleQA fornece à comunidade de IA uma ferramenta valiosa para ajudar a melhorar a precisão factual dos modelos de idiomas para garantir que os futuros sistemas de IA sejam informativos e confiáveis.

Entrada do projeto: https://github.com/openai/simple-evals

Detalhes: https://openai.com/index/introducing-simppleqa/

Pontos -chave:

O SimpleQA é um novo benchmark lançado pelo OpenAI, com foco na avaliação da precisão factual dos modelos de idiomas.

O benchmark consiste em 4326 perguntas curtas e claras, cobrindo várias áreas para garantir uma avaliação abrangente.

O SimpleQA ajuda os pesquisadores a identificar e melhorar as habilidades dos modelos de linguagem na geração de conteúdo preciso.

Em resumo, o SimpleQA fornece uma ferramenta confiável para avaliar a precisão de grandes modelos de linguagem, e sua abertura e facilidade de uso direcionarão o campo de IA em direção a uma direção mais autêntica e confiável. Estamos ansiosos pelo simplesqa para promover o nascimento de sistemas de IA mais confiáveis e confiáveis.