Pesquisadores da Meta AI e parceiros acadêmicos desenvolveram um sistema inovador, MILS (Solver Iterative LLM multimodal), que ensina grandes modelos de idiomas a processar imagens, vídeos e áudio sem treinamento especializado. O MILS depende da capacidade natural de solução de problemas dos modelos de linguagem, em vez de grandes quantidades de treinamento de dados, mostrando suas vantagens únicas.

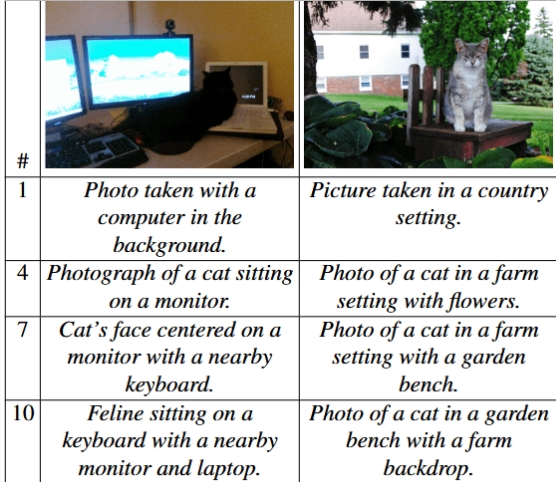

O MILS trabalha emparelhando dois modelos de IA para executar soluções de tarefas: um é um "gerador", responsável por propor soluções de tarefas, e o outro é um "ratingr", usado para avaliar a eficácia da solução gerada. O feedback fornecido pelo goleador pode ajudar o gerador a otimizar continuamente a resposta até atingir um resultado satisfatório. Por exemplo, na tarefa de descrição da imagem, o MILS pode refinar gradualmente as descrições de imagens, descrevendo com precisão os detalhes da imagem em diferentes níveis.

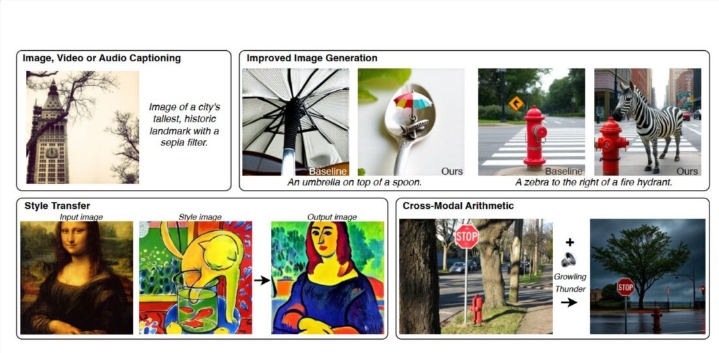

O MILS tem um desempenho particularmente bem na descrição da imagem. Ao usar o modelo LLAMA-3.1-8B como gerador e o modelo de clipe como goleador, o MILS é capaz de criar descrições de imagem comparáveis às dos métodos principais atuais, embora o clipe não seja treinado especificamente para tarefas de descrição da imagem. Além disso, o MILS também aprimora os recursos de geração de texto para imagem, com prompts de texto de ajuste fino e podem combinar instruções geradas por IA com ferramentas de processamento de imagens para lidar com tarefas de edição de imagens, como conversão de estilo.

A precisão da descrição da imagem aumenta com o número de etapas entre o gerador e o artilheiro. |

Os recursos da MILS não se limitam às imagens, mas também se estende aos campos de vídeo e áudio. Quando testado usando o conjunto de dados de vídeo MSR-VTT, o MILS supera os modelos existentes na descrição do conteúdo de vídeo. Como o MILS não modifica os parâmetros do modelo durante a operação, ele pode converter diferentes tipos de dados em texto legível, suportando a mesclagem e a conversão de informações de várias fontes, como imagens e áudio no formato desejado, fazendo com que as informações multimodais convergentes se abrem novo possibilidades.

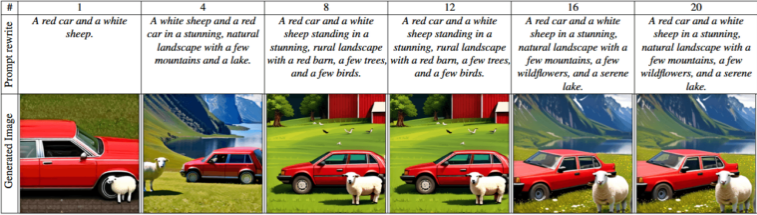

Os testes mostram que o uso de geradores maiores e modelos de pontuação pode produzir resultados mais precisos, e aumentar o número de soluções em potencial pode melhorar significativamente o desempenho. Os pesquisadores também descobriram que se estender a um modelo de linguagem maior não apenas melhora a qualidade dos resultados, mas também melhora significativamente o desempenho.

As paisagens evoluem de descrições básicas simples para representações de paisagem complexas com detalhes mais precisos e elementos mais naturais. |

Essa estratégia inovadora adotada pela MILS está alinhada com a tendência atual do campo da inteligência artificial para recursos de raciocínio mais inteligentes. A equipe da Meta também disse que o MILS pode mostrar um grande potencial no futuro em áreas como o processamento de dados 3D, promovendo ainda mais o desenvolvimento da IA multimodal.

Com o rápido desenvolvimento do GPT-4 da Openai e de outras alternativas de código aberto, como o Llama 3.2 da Meta, o Mistral's Pixtral e o Janus Pro de Deepseek, esses sistemas multimodais emergentes estão acelerando sua aplicação na vida cotidiana. Desenvolvimento da inteligência artificial.