O OpenAI demonstrou recentemente o processo de raciocínio detalhado de seu mais recente modelo de inferência O3-mini, um movimento visto como uma resposta à crescente pressão sobre o concorrente Deepseek-R1. Esse movimento marca uma mudança importante na estratégia de transparência do modelo do OpenAI.

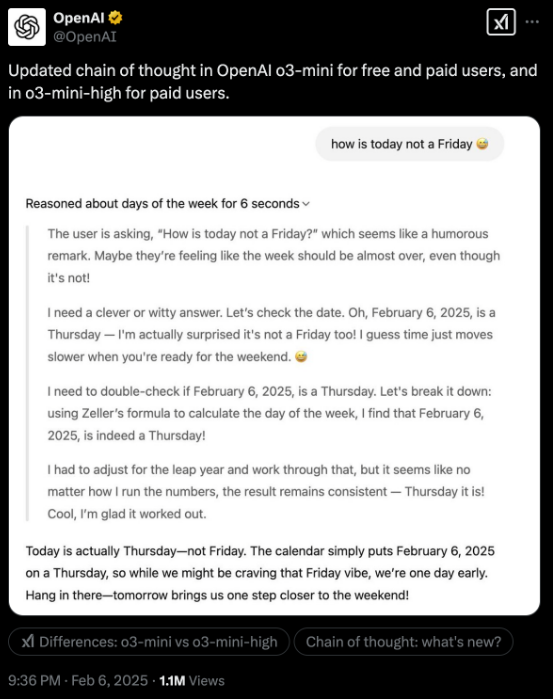

Anteriormente, o OpenAI sempre considerou a "cadeia de pensamento" (COT) como sua vantagem competitiva central e escolheu escondê -la. No entanto, como modelos abertos como Deepseek-R1 demonstram totalmente sua trajetória de inferência, essa estratégia fechada se tornou a falha do OpenAI. Embora a nova versão do O3-mini ainda não abra totalmente a marca original, ela fornece uma exibição mais clara do processo de raciocínio.

O OpenAI também está alcançando ativamente em termos de desempenho e custo. O preço do O3-mini caiu para US $ 4,40 por milhão de token de produção, bem abaixo de US $ 60 para o modelo O1 anterior e próximo ao preço de US $ 7-8 para o Deepseek-R1 para os fornecedores dos EUA. Enquanto isso, o O3-mini supera seus antecessores em vários benchmarks de inferência.

Os testes reais mostram que o processo de raciocínio detalhado demonstração de O3-mini melhora a praticidade do modelo. Ao processar dados não estruturados, os usuários podem entender melhor a lógica de inferência do modelo, otimizando as palavras rápidas para obter resultados mais precisos.

O CEO da Openai, Sam Altman, admitiu recentemente "ficar do lado errado da história" no debate de código aberto. Como a Deepseek-R1 é adotada e aprimorada por muitas instituições, os futuros ajustes do OpenAI para as estratégias de código aberto valem a pena prestar atenção.

A estratégia transparente e a otimização de custos da OpenAI indicam sua inovação e concorrência contínuas no campo da IA.