Nos últimos anos, com o rápido desenvolvimento de grandes modelos de idiomas, os modelos de aprimoramento de inferência também desencadearam extensas discussões sobre suas taxas de alucinação ao mesmo tempo em que melhoram as capacidades de processamento de tarefas complexas. A equipe de aprendizado de máquina de Vetara realizou recentemente um estudo aprofundado dos modelos da série Deepseek, revelando diferenças significativas no modelo de aumento de inferência em termos de taxas de alucinação.

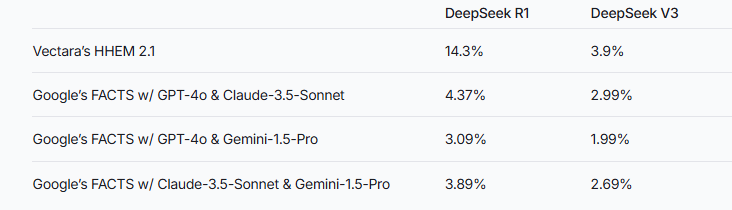

Recentemente, a equipe de aprendizado de máquina de Vetara conduziu testes de alucinação detalhados em dois modelos da série Deepseek. V3. Isso sugere que o DeepSeek-R1 produz mais imprecisos ou inconsistentes com as informações originais durante o processo de aumento do raciocínio. Esse resultado desencadeia uma discussão extensa sobre a taxa de alucinação do modelo de linguagem grande (LLM) aprimorado por inferência.

Notas da fonte da imagem: A imagem é gerada pela IA e a imagem autorizada provedor de serviços Midjourney

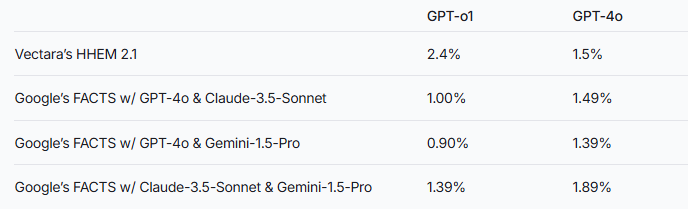

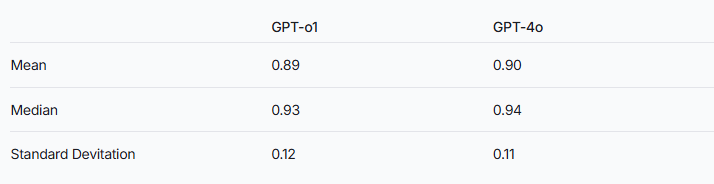

A equipe de pesquisa apontou que os modelos de aumento de inferência podem ser mais propensos a alucinações do que os grandes modelos de idiomas comuns. Esse fenômeno é particularmente evidente na comparação da série Deepseek com outros modelos de aprimoramento de inferência. Tomando a série GPT como exemplo, a diferença na taxa de alucinação entre o GPT-O1 com raciocínio e a versão normal do GPT-4O também verifica essa especulação.

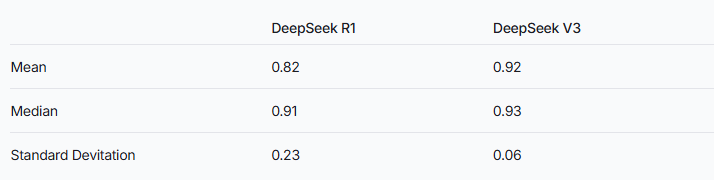

Para avaliar o desempenho desses dois modelos, os pesquisadores usaram o modelo HHEM de Vetara e o método de fatos do Google para fazer julgamentos. Como uma ferramenta de detecção de alucinação especializada, o HHEM exibe maior sensibilidade ao capturar o aumento da taxa de alucinação de Deepseek-R1, enquanto o modelo de fatos tem um desempenho relativamente ruim nesse sentido. Isso nos lembra que o HHEM pode ser mais eficaz que o LLM como padrão.

Vale a pena notar que o DeepSeek-R1, apesar de seu excelente desempenho no raciocínio, é acompanhado por uma maior taxa de alucinação. Isso pode estar relacionado à lógica complexa necessária para processar modelos de aprimoramento de inferência. À medida que a complexidade do raciocínio do modelo aumenta, a precisão do conteúdo gerado pode ser afetada. A equipe de pesquisa também enfatizou que, se o DeepSeek puder se concentrar mais na redução de alucinações durante a fase de treinamento, pode ser possível alcançar um bom equilíbrio entre a capacidade de raciocínio e a precisão.

Embora os modelos aprimorados de inferência geralmente exibam alucinações mais altas, isso não significa que eles não tenham vantagem em outros aspectos. Para a série Deepseek, ainda é necessário resolver alucinações na pesquisa e otimização subsequentes para melhorar o desempenho geral do modelo.

Referência: https://www.vectarara.com/blog/deepseek-r1-hallucinates-more-than-deepseek-v3

Com a evolução contínua de grandes modelos de linguagem, como reduzir as taxas de alucinação e melhorar os recursos de raciocínio se tornará uma direção importante para pesquisas futuras. Os resultados dos testes da série Deepseek nos fornecem referência valiosa para promover o setor para otimizar ainda mais o desempenho do modelo.