Com o rápido desenvolvimento da tecnologia de inteligência artificial, os modelos de idiomas estão se tornando cada vez mais amplamente utilizados em vários campos. No entanto, um novo estudo do OpenAI revelou que esses modelos ficaram muito aquém das expectativas ao responder a perguntas factuais, desencadeando a capacidade da capacidade da IA de adquirir conhecimento.

Um estudo recente do OpenAI mostra que, apesar do rápido desenvolvimento da tecnologia de inteligência artificial, os atuais modelos de idiomas mais avançados têm taxas de sucesso muito mais baixas na resposta a perguntas factuais.

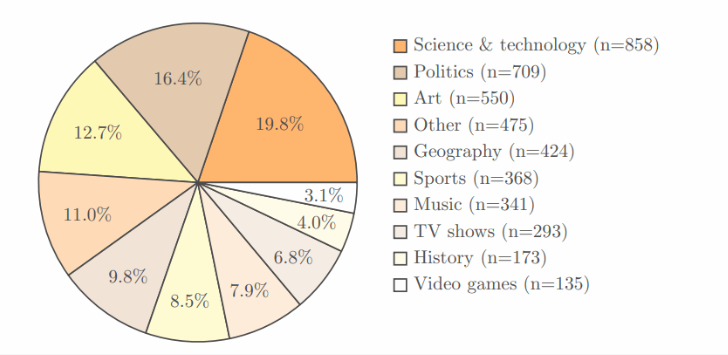

O estudo adotou o próprio teste de referência SimpleQA da OpenAI, que contém 4.326 áreas, cobrindo vários campos, como ciência, política e arte, e cada pergunta tem uma resposta clara e correta.

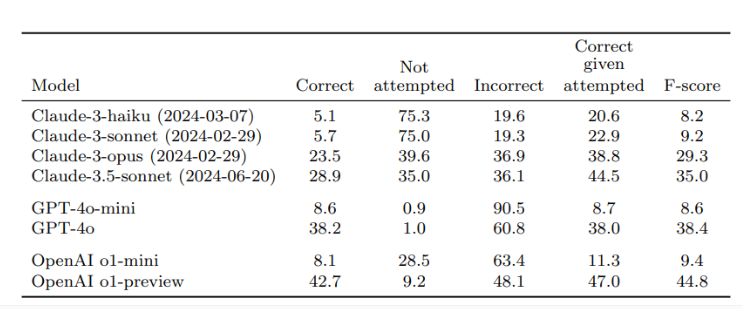

Após a verificação por dois revisores independentes, os resultados mostraram que a taxa de precisão da previsão de O1, o melhor modelo de OpenAI, era de apenas 42,7%, enquanto o GPT-4O foi ligeiramente menor, apenas 38,2%. Quanto ao GPT-4O-Mini menor, a taxa de precisão é de apenas 8,6%. Por outro lado, o modelo de Claude do Antrópico teve um desempenho pior, com a taxa de precisão do Claude-3.5 Sonnet sendo apenas 28,9%.

A chave para este estudo é o desenho do teste, não apenas para testar o desempenho da IA, mas também para fazer com que todos percebam as limitações dos modelos de IA em termos de aquisição de conhecimento. Os pesquisadores enfatizam que, ao usar esses modelos, os usuários devem considerá -los como ferramentas de processamento de informações, em vez de depender inteiramente de fontes de conhecimento. Para obter respostas mais precisas, é melhor fornecer dados confiáveis para a IA, em vez de confiar apenas em seu conhecimento interno.

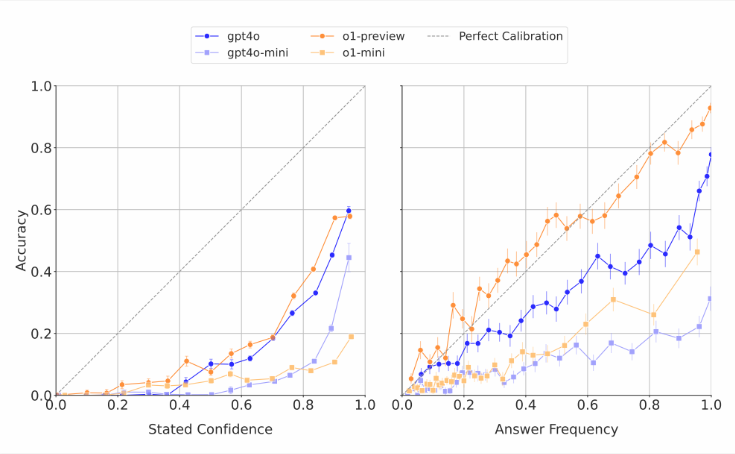

Vale a pena notar que os modelos de IA geralmente estimam suas próprias habilidades. Os pesquisadores descobriram que, quando esses modelos foram convidados a obter confiança em suas respostas, eles geralmente davam uma pontuação exagerada de precisão. Nos testes que respondem repetidamente à mesma pergunta, mesmo que o modelo dê a mesma resposta várias vezes, sua taxa de sucesso real ainda é menor que a precisão de sua auto-avaliação. Isso é consistente com as críticas do mundo externo que geralmente produz respostas absurdas para modelos de idiomas, mas parece confiante.

Os pesquisadores acreditam que existe uma lacuna clara na precisão factual dos sistemas atuais de IA e precisam urgentemente de melhorias. Ao mesmo tempo, eles também fizeram uma pergunta em aberto: se o desempenho da IA em responder a perguntas factuais curtas pode prever como ele se sai ao lidar com respostas mais longas e mais complexas. Para apoiar o desenvolvimento de modelos de idiomas mais confiáveis, o OpenAI publicou dados sobre benchmarks simples da SimpleQA publicamente no Github.

Pontos -chave:

A pesquisa de abertura mostra que os modelos de linguagem mais avançados têm baixas taxas de sucesso ao responder a perguntas factuais, com uma taxa de sucesso máxima de apenas 42,7%.

Esses modelos de IA geralmente superestimam suas habilidades e suas pontuações de confiança geralmente são exageradas.

O OpenAI tornou o SimpleQA Benchmark Public para ajudar a pesquisar modelos de linguagem mais confiáveis.

Este estudo nos lembra que, apesar do progresso significativo na tecnologia de IA, suas limitações precisam ser tratadas com cautela em aplicações práticas e continuar a promover melhorias tecnológicas.